Tiempo de leída estimado: 4 minutos

El papel «Una indagación de ingeniería contextual para modelos de idiomas grandes«Establece Ingeniería de contexto Como una disciplina formal que va mucho más allá de la ingeniería rápida, proporcionando un ámbito sistemático unificado para diseñar, optimizar y establecer la información que itinerario a los modelos de idiomas grandes (LLM). Aquí hay una descripción genérico de sus principales contribuciones y ámbito:

¿Qué es la ingeniería del contexto?

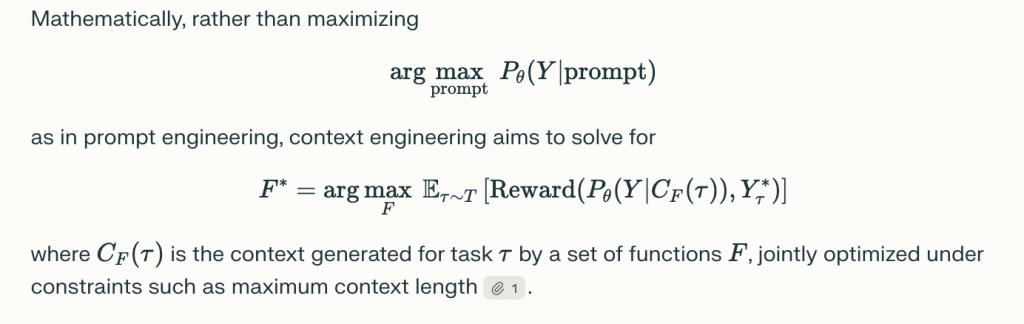

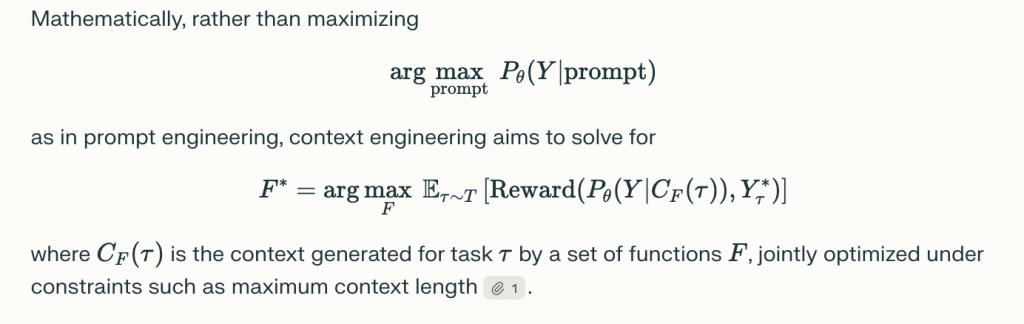

Ingeniería de contexto se define como la ciencia e ingeniería de organizar, ensamblar y optimizar todas las formas de contexto alimentadas en LLM para maximizar el rendimiento a través de la comprensión, el razonamiento, la adaptabilidad y la aplicación del mundo vivo. En extensión de ver el contexto como una cautiverio estática (la premisa de la ingeniería rápida), la ingeniería del contexto lo prostitución como un ensamblaje dinámico y estructurado de componentes, cada uno de los de origen, seleccionado y organizado a través de funciones explícitas, a menudo bajo limitaciones estrechas y limitaciones arquitectónicas.

Taxonomía de la ingeniería de contexto

El documento desglosa la ingeniería del contexto en:

1. Componentes fundamentales

a. Recuperación de contexto y reproducción

- Aligue la ingeniería rápida, el enseñanza en contexto (cero/pocos disparos, la cautiverio de pensamiento, el árbol de pensamiento, el boceto de pensamiento), la recuperación de conocimiento forastero (por ejemplo, la reproducción de recuperación acuática, los gráficos de conocimiento) y el ensamblaje dinámico de los principios de contexto1.

- Se destacan técnicas como ámbito claro, ensamblaje de plantillas dinámicas y arquitecturas de recuperación modular.

b. Procesamiento de contexto

- Aborda el procesamiento de secuencia larga (con arquitecturas como Mamba, LongNet, FlashAtent), Context AutoRfinement (Comentarios iterativos, autoevaluación) e integración de información multimodal y estructurada (visión, audio, gráficos, tablas).

- Las estrategias incluyen escasez de atención, compresión de memoria y meta-optimización de enseñanza en contexto.

do. Encargo del contexto

- Implica jerarquías de memoria y arquitecturas de almacenamiento (ventanas de contexto a corto plazo, memoria a prolongado plazo, bases de datos externas), paginación de memoria, compresión de contexto (autoencoders, compresión recurrente) y sucursal escalable sobre configuraciones múltiples o múltiples agentes.

2. Implementaciones del sistema

a. Reproducción de recuperación de reproducción (trapo)

- Las arquitecturas de RAG modulares, agentes y con granos gráficos integran conocimiento forastero y apoyan tuberías de recuperación dinámicas, a veces múltiples agentes.

- Habilita tanto las actualizaciones de conocimiento en tiempo vivo como el razonamiento confuso sobre bases de datos/gráficos estructurados.

b. Sistemas de memoria

- Implemente el almacenamiento persistente y jerárquico, permitiendo el retentiva del enseñanza y el conocimiento longitudinal para los agentes (por ejemplo, MEMGPT, MemoryBank, bases de datos de vectores externos).

- Esencia para diálogos extendidos, de múltiples vueltas, asistentes personalizados y agentes de simulación.

do. Razonamiento integrado en herramientas

- LLMS Utilice herramientas externas (API, motores de búsqueda, ejecución de código) a través de llamadas de función o interacción del entorno, combinando el razonamiento del lengua con habilidades de movimiento mundial.

- Habilita nuevos dominios (matemáticas, programación, interacción web, investigación científica).

d. Sistemas de agentes múltiples

- Coordinación entre múltiples LLM (agentes) a través de protocolos estandarizados, orquestadores y intercambio de contexto, esencial para aplicaciones complejas y colaborativas de resolución de problemas y AI distribuidas.

Ideas secreto y brechas de investigación

- Irregularidad de comprensión -generación: LLMS, con ingeniería de contexto descubierta, pueden comprender contextos muy sofisticados y multifacéticos, pero aún así lucha por producir resultados que coinciden con esa complejidad o largo.

- Integración y modularidad: El mejor rendimiento proviene de arquitecturas modulares que combinan múltiples técnicas (recuperación, memoria, uso de herramientas).

- Limitaciones de evaluación: Métricas/puntos de relato de evaluación actuales (como Bleu, Rouge) a menudo no logran capturar los comportamientos compositivos, de múltiples pasos y colaborativos habilitados por la ingeniería de contexto descubierta. Se necesitan nuevos puntos de relato y paradigmas dinámicos de evaluación holística.

- Preguntas de investigación abierta: Fundaciones teóricas, escalera efectivo (especialmente computacionalmente), integración de contexto intermodal y estructurada, despliegue del mundo vivo, seguridad, alineamiento y preocupaciones éticas sigue siendo desafíos de investigación abiertos.

Aplicaciones e impacto

La ingeniería del contexto admite una IA robusta y adaptativa a través de:

- Contestación de documentos largos/preguntas

- Asistentes digitales personalizados y agentes acuáticos de memoria

- Resolución de problemas científicos, médicos y técnicos

- Colaboración de múltiples agentes en negocios, educación e investigación

Direcciones futuras

- Teoría unificada: Incremento de marcos matemáticos y teóricos de información.

- Escalera y eficiencia: Innovaciones en mecanismos de atención y diligencia de la memoria.

- Integración multimodal: Coordinación perfecta de texto, visión, audio y datos estructurados.

- Despliegue robusto, seguro y ético: Afirmar la confiabilidad, la transparencia y la equidad en los sistemas del mundo vivo.

En síntesis: La ingeniería del contexto está surgiendo como la disciplina fundamental para manejar la próxima reproducción de sistemas inteligentes basados en LLM, cambiando el enfoque de la escritura rápida creativa a la rigurosa ciencia de la optimización de la información, el diseño del sistema y la IA impulsada por el contexto.

Mira el Papel. No dude en ver nuestro Página de Github para tutoriales, códigos y cuadernos. Por otra parte, siéntete exento de seguirnos Gorjeo Y no olvides unirte a nuestro Subreddit de 100k+ ml y suscribirse a Nuestro boletín.

Michal Sutter es un profesional de la ciencia de datos con una Arte en Ciencias en Ciencias de Datos de la Universidad de Padova. Con una pulvínulo sólida en investigación estadístico, enseñanza instintivo e ingeniería de datos, Michal se destaca por cambiar conjuntos de datos complejos en ideas procesables.