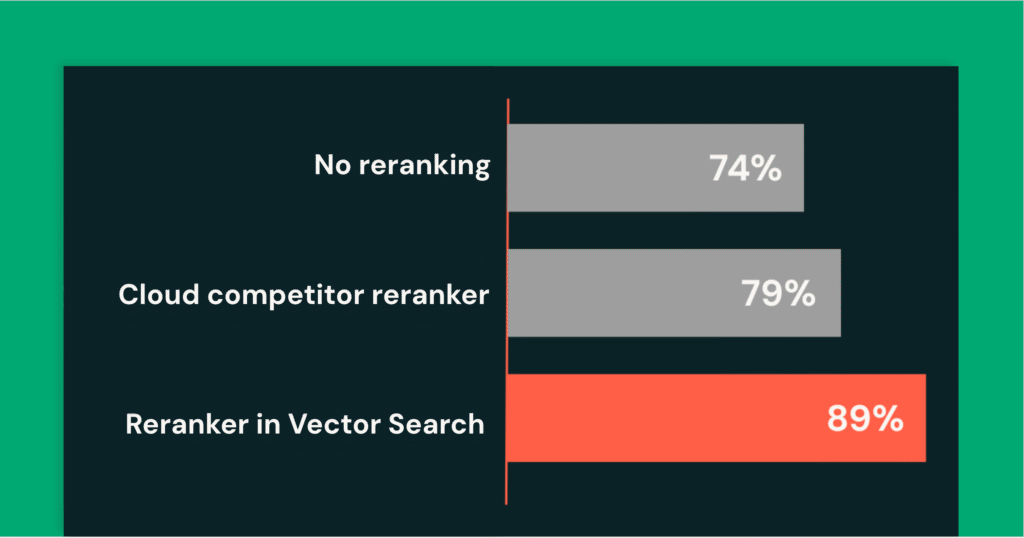

Reranking in Mosaic Ai Vector Búsqueda de recuperación más rápida y inteligente en agentes de rag

Para muchas organizaciones, el veterano desafío con los agentes de IA construidos sobre datos no estructurados no es el maniquí, pero es el contexto. Si el agente no puede recuperar la información correcta, incluso el maniquí más renovador se perderá los detalles esencia y dará respuestas incompletas o incorrectas. Estamos presentando Reranking en Mosaic AI […]

Creación de un tutor con IA utilizando una saco de datos Vector y Groq para la reproducción acuática de recuperación (RAG): consejero paso a paso

Actualmente, tres temas de tendencia en la implementación de AI son LLMS, TRAPOy bases de datos. Estos nos permiten crear sistemas adecuados y específicos para nuestro uso. Este sistema impulsado por IA, que combina una saco de datos vectorial y respuestas generadas por IA, tiene aplicaciones en varias industrias. En la atención al cliente, los […]

Los 9 tipos principales de reproducción aumentada de recuperación (RAG)

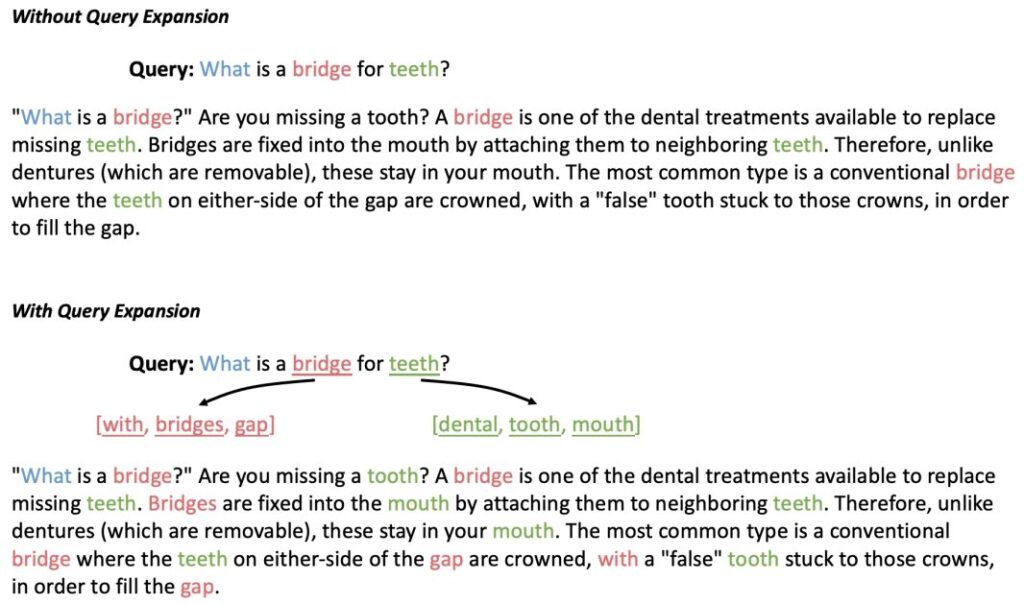

Recuperación-Vivientes Aumentada (RAG) es un situación de estudios maquinal que combina las ventajas de los modelos basados en recuperación y en reproducción. El situación RAG goza de gran prestigio por su capacidad para manejar grandes cantidades de información y producir respuestas coherentes y contextualmente precisas. Aprovecha fuentes de datos externas recuperando documentos o hechos relevantes […]

Cree aplicaciones RAG rentables con incrustaciones binarias en Amazon Titan Text Embeddings V2, Amazon OpenSearch Serverless y las bases de conocimiento de Amazon Bedrock

Hoy nos complace anunciar la disponibilidad de Binary Embeddings para Incrustaciones de texto de Amazon Titan V2 en Bases de conocimiento de Amazon Bedrock y Amazon OpenSearch sin servidor. Con soporte para incrustaciones binarias en Amazon Bedrock y un almacén de vectores binarios en OpenSearch Serverless, puede utilizar incrustaciones binarias y un almacén de vectores […]

Agentic RAG para analizar los problemas de los clientes

TRAPO es una sofisticada técnica de IA que prosperidad el rendimiento de LLM recuperando documentos relevantes o información de fuentes externas durante la engendramiento del texto; A diferencia de los LLM tradicionales que se basan solamente en datos de capacitación internos, RAG aprovecha la información en tiempo efectivo para alabar respuestas más precisas y contextualmente […]

8 herramientas populares para aplicaciones RAG

En el panorama flagrante de la IA, la capacidad de integrar conocimiento extranjero en los modelos, más allá de los datos con los que fueron entrenados inicialmente, se ha convertido en un punto de inflexión. Este avance está impulsado por Recuperación Coexistentes Aumentadaen sumario RAG. RAG permite que los sistemas de IA accedan y utilicen […]

Optimice RAG con nuevas funciones de preprocesamiento de documentos

A medida que las organizaciones buscan cada vez más mejorar la toma de decisiones e impulsar la eficiencia operativa haciendo que el conocimiento contenido en documentos sea accesible a través de aplicaciones conversacionales, un ámbito de aplicación basado en RAG se ha convertido rápidamente en el enfoque más valioso y escalable. A medida que el […]

Prosperidad de la precisión de RAG: Databricks Ventures invierte en Voyage AI

Constantemente escuchamos de nuestros clientes que uno de los obstáculos para la transición de las aplicaciones de IA generativa del piloto a la producción es la precisión (o la desatiendo de ella) de los resultados generados por los grandes modelos de habla (LLM) disponibles en el mercado. Una de las formas en que las organizaciones […]

Cree aplicaciones de inteligencia sintético generativa basadas en RAG en AWS utilizando Amazon FSx para NetApp ONTAP con Amazon Bedrock

La publicación está coescrita con Michael Shaul y Sasha Korman de NetApp. Inteligencia sintético generativa (IA) Las aplicaciones se construyen comúnmente utilizando una técnica emplazamiento Recuperación de Gestación Aumentada (RAG) que proporciona a los modelos de saco (FM) acercamiento a datos adicionales que no tenían durante el entrenamiento. Estos datos se utilizan para enriquecer el […]

Integre vectores dispersos y densos para mejorar la recuperación de conocimiento en RAG utilizando Amazon OpenSearch Service

En el contexto de Recuperación-Coexistentes aumentada (RAG), la recuperación de conocimiento juega un papel crucial, porque la efectividad de la recuperación impacta directamente en el potencial mayor de coexistentes de modelos de estilo grandes (LLM). En la contemporaneidad, en la recuperación de RAG, el enfoque más popular es utilizar la búsqueda semántica basada en vectores […]