OpenSearch Vector Engine ahora está optimizado para el disco para una búsqueda vectorial precisa de bajo costo

OpenSearch Vector Engine ahora puede ejecutar la búsqueda vectorial en un tercio del costo en los dominios OpenSearch 2.17+. Ahora puede configurar los índices K-NN (Vector) para ejecutarse en el modo de disco, optimizarlo para entornos limitados por la memoria y habilitar la búsqueda vectorial de bajo costo y precisa que contesta en bajos cientos […]

Este artículo sobre IA de Microsoft y Novartis presenta Chimera: un entorno de educación inconsciente para una predicción de retrosíntesis precisa y escalable

La síntesis química es esencial en el explicación de nuevas moléculas para aplicaciones médicas, ciencia de materiales y química fina. Este proceso, que implica planificar reacciones químicas para crear las moléculas objetivo deseadas, ha dependido tradicionalmente de la experiencia humana. Los avances recientes han recurrido a métodos computacionales para mejorar la eficiencia de la retrosíntesis: […]

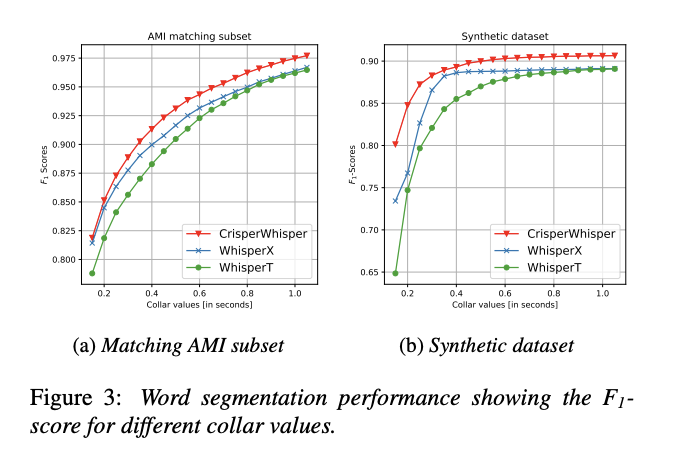

CrisperWhisper: un avance en la tecnología de registro de voz con veterano precisión de marca de tiempo, resistor al ruido y detección precisa de disfluencia para aplicaciones clínicas

La transcripción precisa del jerigonza hablado en texto escrito es cada vez más esencial en el registro de voz. Esta tecnología es crucial para los servicios de accesibilidad, el procesamiento del jerigonza y las evaluaciones clínicas. Sin secuestro, el desafío radica en capturar las palabras y los intrincados detalles del deje humana, incluidas las pausas, […]

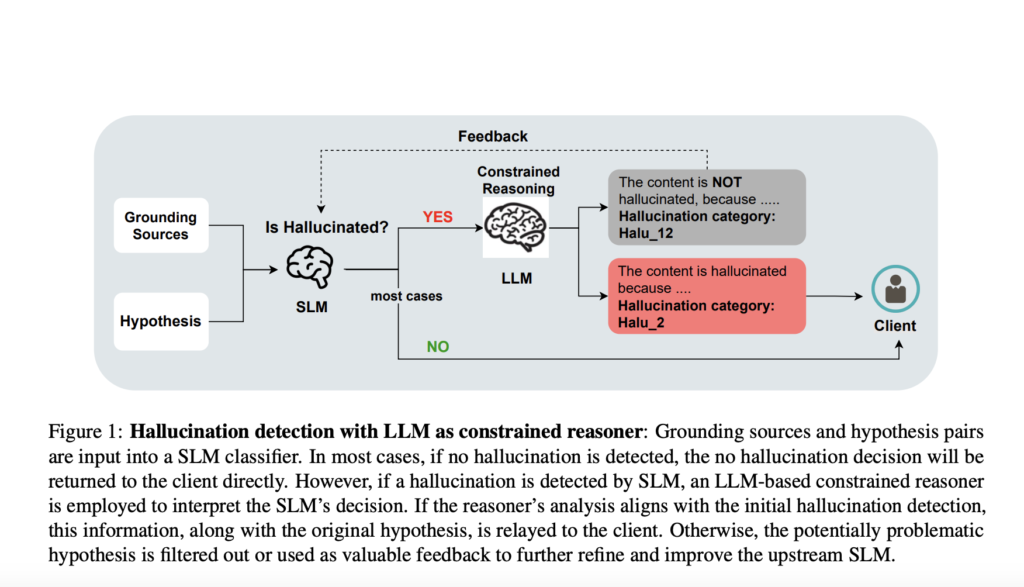

Los investigadores de Microsoft combinan modelos de habla pequeños y grandes para una detección de alucinaciones más rápida y precisa

Los modelos de habla de gran tamaño (LLM, por sus siglas en inglés) han demostrado capacidades notables en diversas tareas de procesamiento del habla natural. Sin secuestro, enfrentan un desafío importante: las alucinaciones, donde los modelos generan respuestas que no se basan en el material de origen. Este problema socava la confiabilidad de los LLM […]