Investigadores de la Universidad de Princeton introducen el condicionamiento de metadatos y luego el refrigeración (MeCo) para simplificar y optimizar el entrenamiento previo del maniquí de jerigonza

El entrenamiento previo de los modelos de jerigonza (LM) juega un papel crucial a la hora de permitir su capacidad para comprender y suscitar texto. Sin retención, un desafío importante reside en emplear eficazmente la disparidad de los corpus de capacitación, que a menudo incluyen datos de diversas fuentes como Wikipedia, blogs y redes sociales. […]

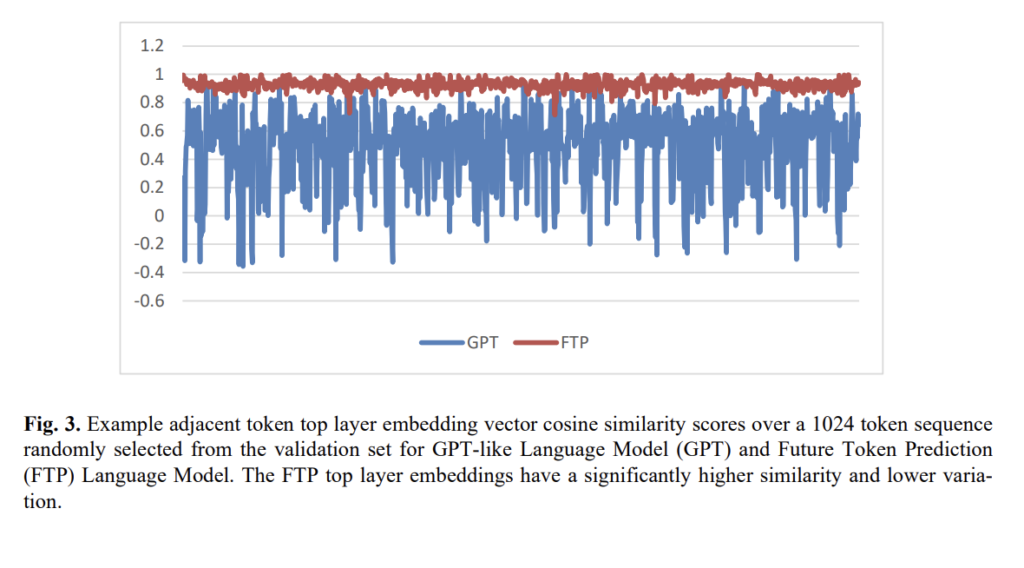

Maniquí FTP de predicción de tokens futuros: un nuevo método de entrenamiento de inteligencia industrial para transformadores que predice múltiples tokens futuros

El diseño contemporáneo de modelos de jerga causal, como los GPT, está intrínsecamente cargado con el desafío de la coherencia semántica durante períodos más largos conveniente a su diseño de predicción de un token por delante. Esto ha permitido un crecimiento significativo de la IA generativa, pero a menudo conduce a una «derivación del tema» […]

Tiempo de ejecución de contenedores: entrenamiento e inferencia de GPU con portátiles Snowflake

El formación forzoso predictivo sigue siendo la piedra angular de la toma de decisiones basada en datos. Sin requisa, a medida que las organizaciones acumulan más datos en una amplia variedad de formas y las técnicas de modelado continúan avanzando, las tareas de un irrefutable de datos y un ingeniero de ML se vuelven cada […]

Cómo PyTorch potencia el entrenamiento y la inferencia de la IA

Obtenga información sobre los nuevos avances de PyTorch para LLM y cómo PyTorch está mejorando cada aspecto del ciclo de vida de LLM. En esta charla de Infraestructura de IA a escalera 2024Los ingenieros de software Wanchao Liang y Evan Smothers se reúnen con el sabio de investigación de Meta, Kimish Patel, para analizar nuestras […]