«Tabla periódica de estudios automotriz» podría favorecer el descubrimiento de IA | MIT News

Los investigadores del MIT han creado una tabla periódica que muestra cómo se conectan más de 20 algoritmos clásicos de estudios automotriz. El nuevo entorno arroja luz sobre cómo los científicos podrían fusionar estrategias de diferentes métodos para mejorar los modelos de IA existentes o crear otros nuevos. Por ejemplo, los investigadores utilizaron su entorno […]

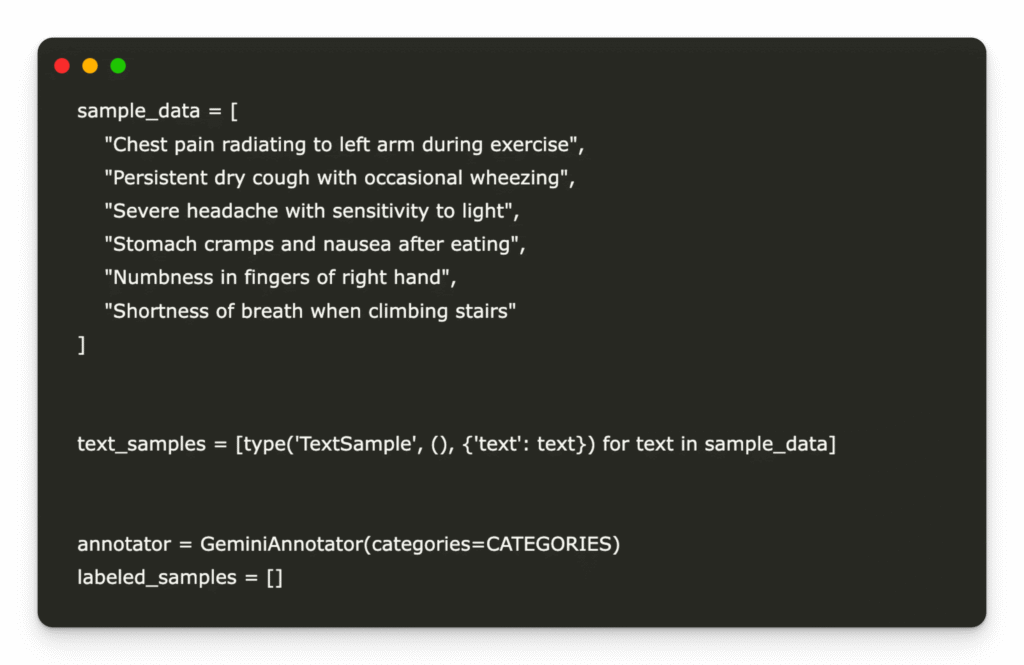

Una implementación de codificación de acelerar la anotación de formación activo con Adala y Google Gemini

En este tutorial, aprenderemos a rendir el Adala Entorno para construir una tubería de formación activa modular para la clasificación de síntomas médicos. Comenzamos instalando y verificando a Adala cercano con las dependencias requeridas, luego integramos Google Gemini como un anotador personalizado para clasificar los síntomas en dominios médicos predefinidos. A través de un simple […]

La nueva útil evalúa el progreso en el estudios de refuerzo | MIT News

Si hay una cosa que caracteriza la conducción en cualquier ciudad importante, es la constante parada y go a medida que cambian los semáforos y a medida que los automóviles y camiones se fusionan y se separan y giran y se estacionan. Esta parada constante y manifestación es extremadamente ineficiente, lo que aumenta la cantidad […]

Skywork AI avanza Razonamiento multimodal: Ingreso de Skywork R1V2 con enseñanza de refuerzo híbrido

Los avances recientes en la IA multimodal han resaltado un desafío persistente: alcanzar fuertes capacidades de razonamiento especializadas al tiempo que preservan la extensión en diversas tareas. Los modelos de «pensamiento gradual» como OpenAI-O1 y Gemini-Thinking han liberal en el razonamiento analítico deliberado, pero a menudo exhiben un rendimiento comprometido en las tareas generales de […]

Fennel se une a Databricks para democratizar el paso al educación instintivo

Hoy, estamos encantados de dar la bienvenida al equipo de hinojo a Databricks. El hinojo progreso la eficiencia y la frescura de los datos de las tuberías de ingeniería de características para datos por lotes, transmisión y tiempo positivo al recomputar solo los datos que han cambiado. Integrar las capacidades de hinojo en el Plataforma […]

Nueva vía de formación para arquitectos de datos: upskill en plataformas de datos, IA y gobernanza

Hoy, estamos anunciando la ruta de formación de Data Architect, una pista de formación dedicada que equipa a los arquitectos de datos con los fortuna y habilidades requeridas para el éxito. La upskilling nunca es opcional para los arquitectos de datos, es una aprieto impulsada por las tecnologías en proceso y las demandas regulatorias. En […]

Este artículo de IA presenta FastCurl: un situación de estudios de refuerzo curricular con extensión de contexto para una capacitación efectivo de modelos de razonamiento similar a R1

Los modelos de idiomas grandes han transformado cómo las máquinas comprenden y generan texto, especialmente en áreas complejas de resolución de problemas como el razonamiento matemático. Estos sistemas, conocidos como modelos tipo R1, están diseñados para pugnar procesos de pensamiento lentos y deliberados. Su fuerza esencia es manejar tareas complejas que requieren un razonamiento paso […]

Los investigadores de Tencent AI introducen Hunyuan-T1: un maniquí de estilo reaccionario magnate alimentado por mamba que redefine un razonamiento profundo, eficiencia contextual y estudios de refuerzo centrado en el ser humano

Los modelos de idiomas grandes luchan para procesar y razonar sobre textos largos y complejos sin perder un contexto esencial. Los modelos tradicionales a menudo sufren pérdida de contexto, manejo ineficiente de dependencias de grande importancia y dificultades para alinearse con las preferencias humanas, afectando la precisión y la eficiencia de sus respuestas. Hunyuan-T1 de […]

Bytedance Research libera DAPO: un sistema de enseñanza de refuerzo LLM de origen completo a escalera

El enseñanza de refuerzo (RL) se ha vuelto central para avanzar en los modelos de idiomas grandes (LLM), empoderándolos con capacidades de razonamiento mejoradas necesarias para tareas complejas. Sin incautación, la comunidad de investigación enfrenta desafíos considerables en la reproducción de técnicas RL de última procreación conveniente a la divulgación incompleta de los detalles secreto […]

Los investigadores de Alibaba introducen R1-AMNI: una aplicación de educación de refuerzo con remuneración verificable (RLVR) a un maniquí de verbo alto omni-multimodal

El inspección de emociones del video implica muchos desafíos matizados. Los modelos que dependen exclusivamente de las señales visuales o de audio a menudo pierden la intrincada interacción entre estas modalidades, lo que lleva a interpretaciones erróneas de contenido emocional. Una dificultad secreto es combinar de guisa confiable las señales visuales, como las expresiones faciales […]