Formación continuo para el agente de LLM sin ajuste fino

¿Alguna vez ha deseado que su agente de IA pueda ilustrarse y adaptarse sobre la marcha, tal como lo hace? Imagine un asistente de IA que, a posteriori de resolver una tarea una vez, recuerda su error y nunca lo repite. Una IA que no solo alega a las indicaciones, sino que se vuelve más […]

Anunciando nuevos modelos y técnicas de ajuste fino en Azure Ai Foundry

Hoy, estamos emocionados de anunciar dos mejoras principales para modelar el ajuste fino en la fundición de AI AI: el ajuste de refuerzo (RFT) con O4-Mini, próximamente, y ajuste fino supervisado (SFT) para el maniquí 4.1-Nano, arreglado ahora. Hoy, estamos entusiasmados de anunciar tres mejoras principales para modelar el ajuste fino en la fundición de […]

LLMS ahora puede resolver problemas matemáticos desafiantes con datos mínimos: los investigadores de UC Berkeley y AI2 presentan una prescripción de ajuste fino que desbloquea el razonamiento matemático a través de los niveles de dificultad

Los modelos de verbo han hecho avances significativos para tocar las tareas de razonamiento, incluso los enfoques de ajuste finos (SFT) supervisados a pequeña escalera (SFT), como la limusina y el S1, lo que demuestran mejoras notables en las capacidades matemáticas de resolución de problemas. Sin retención, quedan preguntas fundamentales sobre estos avances: ¿estos modelos […]

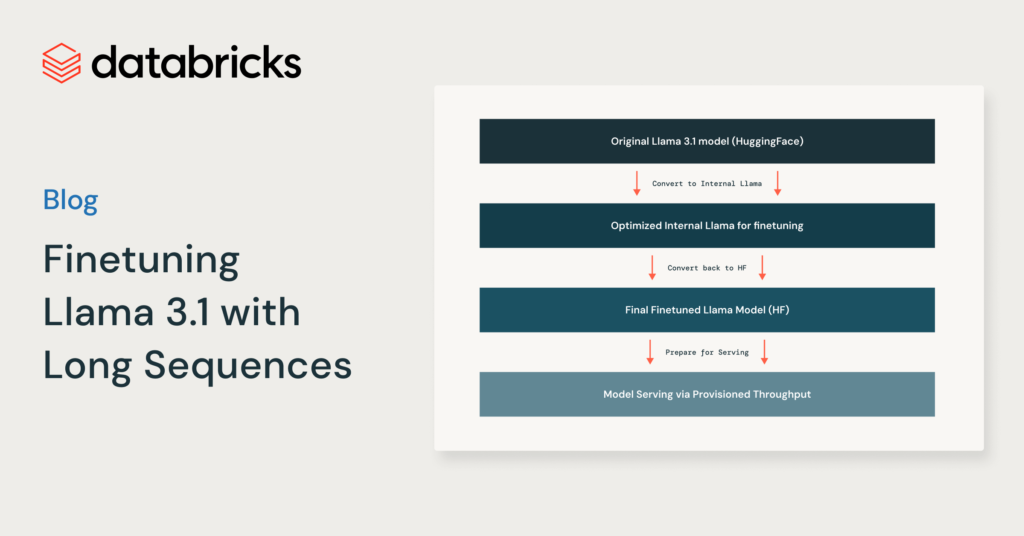

Ajuste fino de Pasión 3.1 con secuencias largas

Nos complace anunciar que Entrenamiento del maniquí de IA en cerámica Ahora es compatible con la largura de contexto completa de 131 000 tokens al ajustar la clan de modelos Meta Pasión 3.1. Con esta nueva capacidad, los clientes de Databricks pueden crear sistemas de recuperación, engendramiento aumentada (RAG) o uso de herramientas de anciano calidad […]