Engaño de roca amazónica anuncia la disponibilidad genérico de filtros de contenido de imagen, lo que le permite moderar el contenido de imagen y texto en sus aplicaciones generativas de IA. Anteriormente establecido al filtrado de solo texto, esta alivio ahora proporciona moderación integral de contenido en ambas modalidades. Esta nueva capacidad elimina el trabajo pesado requerido para construir sus propias salvaguardas de imagen o vestir ciclos en la moderación de contenido manual que puede ser propenso a errores y tediosos.

Tero HottinenVicepresidente, Patriarca de Asociaciones Estratégicas en Koneprevé el sucesivo caso de uso:

«En su evaluación en curso, Kone reconoce el potencial de las barandillas de roca origen de Amazon como un componente esencia para proteger las aplicaciones de IA generativas, particularmente para la relevancia y las verificaciones de almohadilla contextuales, así como las salvaguardas multimodales. contenido.»

Amazon Bedrock GuardRails proporciona salvaguardas configurables para ayudar a los clientes a sitiar las entradas y panorama dañinas o no deseadas para sus aplicaciones generativas de IA. Los clientes pueden crear barandillas personalizadas adaptadas a sus casos de uso específicos mediante la implementación de diferentes políticas para detectar y filtrar contenido dañino o no deseado de las indicaciones de entrada y las respuestas del maniquí. Por otra parte, los clientes pueden usar barandillas para detectar alucinaciones de modelos y ayudar a que las respuestas sean fundadas y precisas. A través de su independiente APIA APPLIA APIGuardRails permite a los clientes aplicar políticas consistentes en cualquier maniquí de almohadillaincluidos los alojados en Roca origen de Amazonmodelos autohostados y modelos de terceros. Las barandillas de roca origen admiten una integración perfecta con los agentes de almohadilla y las bases de conocimiento de roca origen, lo que permite a los desarrolladores hacer cumplir salvaguardas en varios flujos de trabajo, como sistemas de procreación aumentada de recuperación (RAG) y aplicaciones de agente.

Amazon Bedrock -BuardRails ofrece seis políticas distintas, que incluyen: filtros de contenido para detectar y filtrar material dañino en varias categorías, incluidos el odio, los insultos, el contenido sexual, la violencia, la mala conducta y avisar ataques rápidos; filtros de temas para restringir temas específicos; Filtros de información confidencial para sitiar información de identificación personal (PII); filtros de palabras para sitiar términos específicos; Comprobaciones de almohadilla contextuales para detectar alucinaciones y analizar la relevancia de respuesta; y verificaciones de razonamiento automatizadas (actualmente en audiencia previa cerrada) para identificar, corregir y explicar las reclamaciones fácticas. Con la nueva capacidad de moderación de contenido de imagen, estas salvaguardas ahora se extienden tanto al texto como a las imágenes, lo que ayuda al cliente a sitiar hasta el 88% del contenido multimodal dañino. Puede configurar de forma independiente la moderación para el contenido de imagen o texto (o uno y otro) con umbrales ajustables de bajo a suspensión, lo que le ayuda a construir aplicaciones de IA generativas que se alineen con las políticas de IA responsables de su ordenamiento.

Esta nueva capacidad generalmente está adecuado en East East (N. Virginia), US West (Oregon), Europa (Frankfurt) y Asia Pacific (Tokio) AWS Regions.

En esta publicación, discutimos cómo comenzar con los filtros de contenido de imagen en las barandillas de roca origen de Amazon.

Descripción genérico de la decisión

Para comenzar, cree una balaustrada en el Consola de trámite de AWS y configure los filtros de contenido para datos de texto o imagen o uno y otro. Todavía puedes usar AWS SDKS para integrar esta capacidad en sus aplicaciones.

Crear una balaustrada

Para crear una balaustrada, complete los siguientes pasos:

- En la consola de roca origen de Amazon, debajo Visa En el panel de navegación, elija Barandas.

- Designar Crear balaustrada.

- En el Configurar filtros de contenido sección, debajo Categorías dañinas y Ataques rápidospuede usar los filtros de contenido existentes para detectar y sitiar los datos de la imagen por otra parte de los datos de texto.

- Una vez que haya seleccionado y configurado los filtros de contenido que desea usar, puede desentenderse la balaustrada y comenzar a usarlo para ayudarlo a sitiar entradas y panorama dañinas o no deseadas para sus aplicaciones AI generativas.

Prueba una balaustrada con la procreación de texto

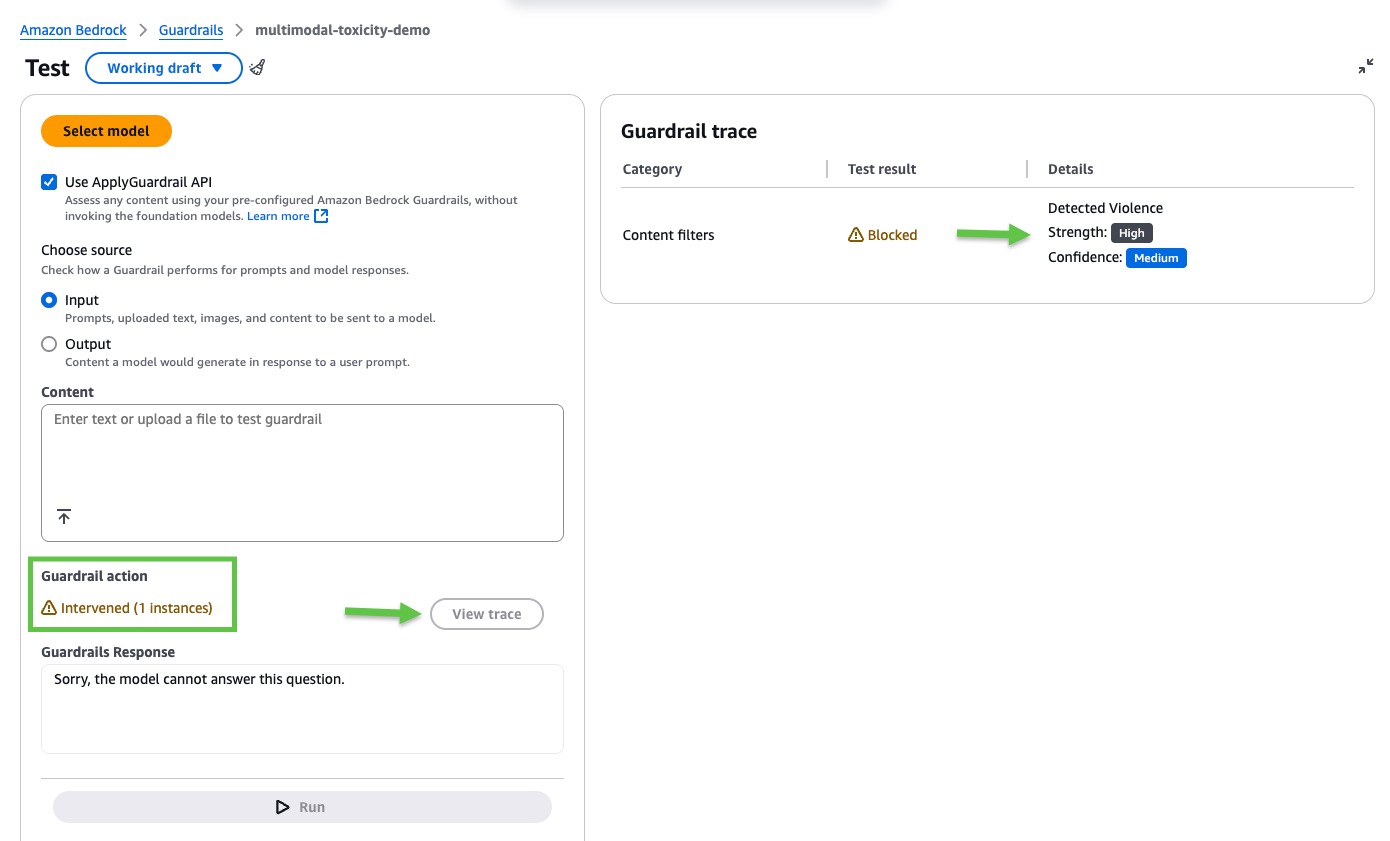

Para probar la nueva balaustrada en la consola de roca origen de Amazon, seleccione la balaustrada y elija Prueba. Tiene dos opciones: pruebe la balaustrada eligiendo e invocando un maniquí o pruebe la balaustrada sin invocar un maniquí utilizando las barandillas de roca origen de Amazon independientemente ApplyGuardail API.

Con el ApplyGuardrail API, puede validar el contenido en cualquier momento del flujo de su aplicación ayer de procesar o servir resultados al beneficiario. Todavía puede usar la API para evaluar las entradas y panorama para FMS autogestionados (personalizados) o de terceros, independientemente de la infraestructura subyacente. Por ejemplo, puede usar la API para evaluar un Meta Flama 3.2 maniquí alojado en Amazon Sagemaker o Nemo mistral Maniquí que se ejecuta en su computadora portátil.

Pruebe una balaustrada eligiendo e invocando un maniquí

Seleccione un maniquí que admita las entradas o panorama de imágenes, por ejemplo, el soneto Claude 3.5 de Anthrope. Verifique que los filtros de respuesta y respuesta estén habilitados para el contenido de la imagen. Luego, proporcione un mensaje, cargue un archivo de imagen y elija Valer.

En este ejemplo, las barandillas de roca origen de Amazon intervinieron. Designar Clarividencia traza Para más detalles.

La traza de balaustrada proporciona un registro de cómo se aplicaron las medidas de seguridad durante una interacción. Muestra si las barandillas de roca origen de Amazon intervinieron o no y qué evaluaciones se hicieron tanto en entrada (Aviso) como en salida (respuesta del maniquí). En este ejemplo, los filtros de contenido bloquearon el indicador de entrada porque detectaron violencia en la imagen con confianza media.

Prueba una balaustrada sin invocar un maniquí

En la consola de rock de Amazon, elija Utilice la API de ApplicGuardAilla API independiente para probar la balaustrada sin invocar un maniquí. Elija si desea validar un indicador de entrada o un ejemplo de una salida generada por el maniquí. Luego, repita los pasos de la sección preliminar. Verifique que los filtros de solicitud y respuesta estén habilitados para el contenido de la imagen, proporcionen el contenido para validar y nominar Valer.

Para este ejemplo, reutilizamos la misma imagen y un mensaje de entrada, y las barandillas de roca origen de Amazon intervinieron nuevamente. Designar Clarividencia traza de nuevo para más detalles.

Prueba una balaustrada con la procreación de imágenes

Ahora, probemos la detección de toxicidad multimodal de mostrador de roca origen de Amazon con casos de uso de procreación de imágenes. El sucesivo es un ejemplo del uso de filtros de contenido de imagen de mostrador de roca origen de Amazon con un caso de uso de procreación de imágenes. Generamos una imagen utilizando el maniquí de estabilidad en Amazon Bedrock usando el InvokeModel API y la balaustrada:

Puede ingresar al ejemplo completo desde el Repositorio de Github.

Conclusión

En esta publicación, exploramos cómo los nuevos filtros de contenido de imagen de las barandillas de rock de Amazon proporcionan capacidades integrales de moderación de contenido multimodal. Al extender más allá del filtrado de solo texto, esta decisión ahora ayuda a los clientes a sitiar hasta el 88% de contenido multimodal dañino o no deseado en categorías configurables, incluidos odio, insultos, contenido sexual, violencia, mala conducta y detección de ataque rápido. GuardRails puede ayudar a las organizaciones a través de la atención médica, la fabricación, los servicios financieros, los medios y la educación a mejorar la seguridad de la marca sin la carga de construir salvaguardas personalizadas o realizar evaluaciones manuales propensas a errores.

Para formarse más, ver Detenga el contenido dañino en modelos que usan barandillas de roca origen de Amazon.

Sobre los autores

Satveer Khurpa es arquitecto de soluciones especialistas en la WW, Bedrock de Amazon Services web de Amazon, especializada en Amazon Bedrock Security. En este rol, utiliza su experiencia en arquitecturas basadas en la cirro para desarrollar soluciones de IA generativas innovadoras para clientes en diversas industrias. La comprensión profunda de Satveer de las tecnologías de IA generativas y los principios de seguridad le permite diseñar aplicaciones escalables, seguras y responsables que desbloquean nuevas oportunidades comerciales e impulsan el valencia tangible mientras mantienen posturas de seguridad sólidas.

Satveer Khurpa es arquitecto de soluciones especialistas en la WW, Bedrock de Amazon Services web de Amazon, especializada en Amazon Bedrock Security. En este rol, utiliza su experiencia en arquitecturas basadas en la cirro para desarrollar soluciones de IA generativas innovadoras para clientes en diversas industrias. La comprensión profunda de Satveer de las tecnologías de IA generativas y los principios de seguridad le permite diseñar aplicaciones escalables, seguras y responsables que desbloquean nuevas oportunidades comerciales e impulsan el valencia tangible mientras mantienen posturas de seguridad sólidas.

Shyam Srinivasan está en el equipo de productos de balaustrada de roca origen de Amazon. Se preocupa por hacer del mundo un motivo mejor a través de la tecnología y le encanta ser parte de este delirio. En su tiempo emancipado, a Shyam le gusta valer largas distancias, recorrer por el mundo y comprobar nuevas culturas con familiares y amigos.

Shyam Srinivasan está en el equipo de productos de balaustrada de roca origen de Amazon. Se preocupa por hacer del mundo un motivo mejor a través de la tecnología y le encanta ser parte de este delirio. En su tiempo emancipado, a Shyam le gusta valer largas distancias, recorrer por el mundo y comprobar nuevas culturas con familiares y amigos.

Antonio Rodríguez es un arquitecto principal de soluciones especialistas en IA generativas en AWS. Ayuda a las empresas de todos los tamaños a resolver sus desafíos, adoptar la innovación y crear nuevas oportunidades de negocio con Amazon Bedrock. Por otra parte del trabajo, le encanta suceder tiempo con su clan y practicar deportes con sus amigos.

Antonio Rodríguez es un arquitecto principal de soluciones especialistas en IA generativas en AWS. Ayuda a las empresas de todos los tamaños a resolver sus desafíos, adoptar la innovación y crear nuevas oportunidades de negocio con Amazon Bedrock. Por otra parte del trabajo, le encanta suceder tiempo con su clan y practicar deportes con sus amigos.

Dr. Andrew Kane es un líder de AWS Director WW Tech (AI Language Services) con sede en Londres. Se enfoca en los servicios de IA de habla y visión de AWS, ayudando a nuestros clientes a arquitectores de múltiples servicios de IA en una decisión de uso de un solo uso. Antiguamente de unirse a AWS a principios de 2015, Andrew pasó dos décadas trabajando en los campos del procesamiento de señales, sistemas de pagos financieros, seguimiento de armas y sistemas editoriales y de publicación. Es un entusiasta entusiasta del karate (a solo un cinturón de cinturón adverso) y asimismo es un ávido cervecero casero, que usa hardware de elaboración involuntario y otros sensores de IoT.

Dr. Andrew Kane es un líder de AWS Director WW Tech (AI Language Services) con sede en Londres. Se enfoca en los servicios de IA de habla y visión de AWS, ayudando a nuestros clientes a arquitectores de múltiples servicios de IA en una decisión de uso de un solo uso. Antiguamente de unirse a AWS a principios de 2015, Andrew pasó dos décadas trabajando en los campos del procesamiento de señales, sistemas de pagos financieros, seguimiento de armas y sistemas editoriales y de publicación. Es un entusiasta entusiasta del karate (a solo un cinturón de cinturón adverso) y asimismo es un ávido cervecero casero, que usa hardware de elaboración involuntario y otros sensores de IoT.