- En la Cumbre Total 2024 de Open Compute Project (OCP), presentaremos nuestros últimos diseños de hardware de IA abierta con la comunidad de OCP.

- Estas innovaciones incluyen una nueva plataforma de inteligencia fabricado, diseños de bastidores abiertos de vanguardia y estructuras y componentes de red avanzados.

- Al compartir nuestros diseños, esperamos inspirar la colaboración y fomentar la innovación. Si le apasiona construir el futuro de la IA, lo invitamos a colaborar con nosotros y con OCP para ayudar a dar forma a la próxima procreación de hardware descubierto para la IA.

La IA ha estado en el centro de las experiencias que Meta ha estado brindando a personas y empresas durante primaveras, incluidas innovaciones en el modelado de IA para optimizar y mejorar características como Procurar y nuestro sistema de anuncios. A medida que desarrollamos y lanzamos modelos de IA nuevos y avanzados, asimismo nos sentimos impulsados a mejorar nuestra infraestructura para respaldar nuestras cargas de trabajo de IA nuevas y emergentes.

Por ejemplo, Pira 3.1 405Bel maniquí más espacioso de Meta, es un transformador denso con parámetros 405B y una ventana de contexto de hasta 128k tokens. Para entrenar un maniquí de jerga espacioso (LLM) de esta magnitud, con más de 15 billones de tokens, tuvimos que realizar optimizaciones sustanciales en toda nuestra pila de entrenamiento. Este esfuerzo impulsó nuestra infraestructura a proceder en más de 16 000 GPU NVIDIA H100, lo que convirtió a Pira 3.1 405B en el primer maniquí de la serie Pira entrenado a una escalera tan masiva.

Ayer de Pira, nuestros trabajos de IA más importantes se ejecutaban en 128 GPU NVIDIA A100. Pero las cosas se han acelerado rápidamente. En el transcurso de 2023, ampliamos rápidamente nuestros grupos de capacitación de GPU de 1K, 2K, 4K y, finalmente, de 16K para respaldar nuestras cargas de trabajo de IA. Hoy, estamos entrenando nuestros modelos en dos Clústeres de GPU de 24K.

No esperamos que esta trayectoria enhiesto de los grupos de IA se desacelere en el corto plazo. De hecho, esperamos que la cantidad de computación necesaria para el entrenamiento de IA crezca significativamente desde donde nos encontramos hoy.

La creación de clústeres de IA requiere poco más que GPU. Las redes y el satisfecho de bandada juegan un papel importante para certificar el rendimiento de los clústeres. Nuestros sistemas constan de un sistema informático HPC estrechamente integrado y una red informática aislada de gran satisfecho de bandada que conecta todas nuestras GPU y aceleradores específicos de dominio. Este diseño es necesario para satisfacer nuestras micción de inyección y chocar los desafíos planteados por nuestra carencia de satisfecho de bandada de bisección.

En los próximos primaveras, anticipamos un maduro satisfecho de bandada de inyección del orden de un terabyte por segundo, por acelerador, con el mismo satisfecho de bandada de bisección normalizado. ¡Esto representa un crecimiento de más de un orden de magnitud en comparación con las redes actuales!

Para respaldar este crecimiento, necesitamos una estructura de red sin cerco, de múltiples niveles y de suspensión rendimiento que pueda utilizar un control de congestión original para comportarse de forma predecible bajo cargas pesadas. Esto nos permitirá beneficiarse al mayor el poder de nuestros grupos de IA y certificar que sigan funcionando de forma óptima a medida que ampliamos los límites de lo que es posible con la IA.

Subir la IA a esta velocidad requiere soluciones de hardware abiertas. El exposición de nuevas arquitecturas, estructuras de red y diseños de sistemas es más valioso e impactante cuando podemos construirlo sobre principios de transigencia. Al cambiar en hardware descubierto, desbloqueamos todo el potencial de la IA e impulsamos la innovación continua en este campo.

Presentamos Catalina: edificación abierta para infraestructura de IA

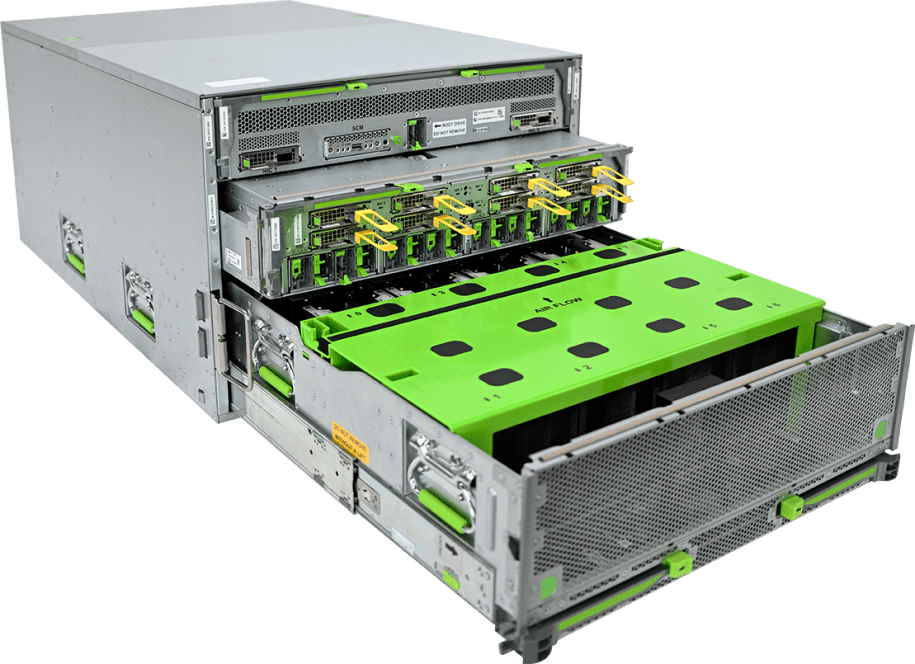

Hoy anunciamos a la comunidad OCP el próximo tirada de Catalina, nuestro nuevo entramado de entrada potencia diseñado para cargas de trabajo de IA. Catalina se cimiento en la Alternativa completa a escalera de rack de la plataforma NVIDIA Blackwellcentrándose en la modularidad y la flexibilidad. Está diseñado para albergar el posterior superchip NVIDIA GB200 Grace Blackwell, lo que garantiza que satisfaga las crecientes demandas de la infraestructura de inteligencia fabricado moderna.

Las crecientes demandas de energía de las GPU significan que las soluciones de rack descubierto deben albergar una maduro capacidad de energía. Con Catalina presentamos el Orv3, un rack de entrada potencia (HPR) capaz de soportar hasta 140 kW.

La decisión completa está refrigerada por humor y consta de un estante eléctrico que admite una bandeja de computación, una bandeja de conmutación, el Orv3 HPR, el Cuña 400 conmutador de estructura, un conmutador de diligencia, una pelotón de respaldo de formación y un compensador de diligencia de entramado.

Nuestro objetivo es que el diseño modular de Catalina permita a otros personalizar el rack para satisfacer sus cargas de trabajo de IA específicas y, al mismo tiempo, beneficiarse los estándares industriales existentes y emergentes.

La plataforma Grand Teton ahora admite aceleradores AMD

En 2022, anunciamos Gran Tetónnuestra plataforma de IA de próxima procreación (la continuación de nuestra plataforma Zion-EX). Grand Teton está diseñado con capacidad de enumeración para soportar las demandas de cargas de trabajo con satisfecho de bandada de memoria, como Meta’s. modelos de recomendación de formación profundo (DLRM), así como cargas de trabajo vinculadas a la computación, como la comprensión de contenidos.

Ahora, hemos ampliado la plataforma Grand Teton para albergar AMD Instinct MI300X y contribuiremos con esta nueva interpretación a OCP. Al igual que sus predecesores, esta nueva interpretación de Grand Teton presenta un diseño de sistema monolítico único con interfaces de estructura, computación, control y energía totalmente integradas. Este suspensión nivel de integración simplifica la implementación del sistema, lo que permite un escalamiento rápido con maduro confiabilidad para cargas de trabajo de inferencia de IA a gran escalera.

Adicionalmente de albergar una variedad de diseños de aceleradores, que ahora incluyen el AMD Instinct MI300x, Grand Teton ofrece una capacidad de procesamiento significativamente maduro, lo que permite una convergencia más rápida en un conjunto más espacioso de pesos. Esto se complementa con una memoria ampliada para juntar y ejecutar modelos más grandes localmente, inmediato con un maduro satisfecho de bandada de red para ampliar los tamaños de los clústeres de entrenamiento de forma valioso.

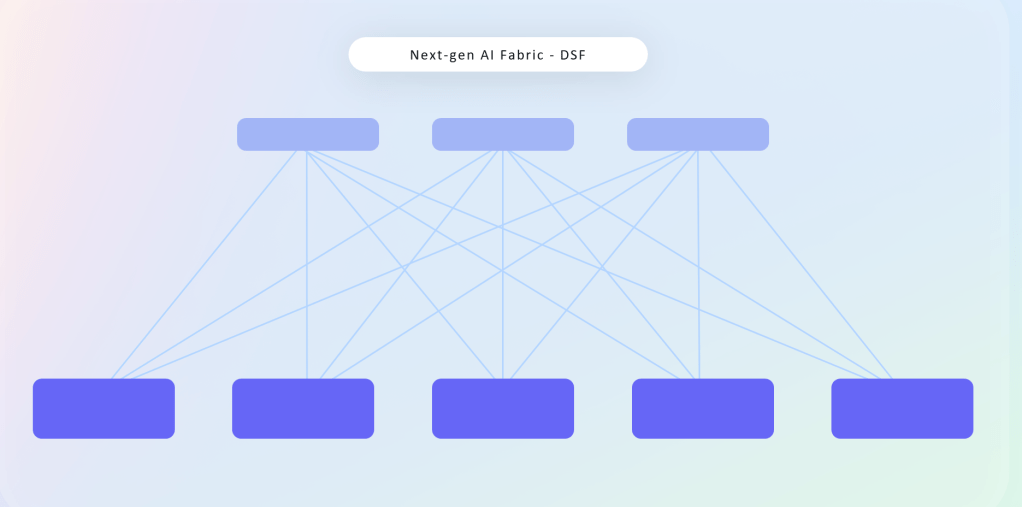

Tejido programado descubierto y desagregado

El exposición de un backend de red descubierto e independiente del proveedor desempeñará un papel importante en el futuro a medida que sigamos impulsando el rendimiento de nuestros grupos de capacitación en IA. La desagregación de nuestra red nos permite trabajar con proveedores de toda la industria para diseñar sistemas que sean innovadores, adicionalmente de escalables, flexibles y eficientes.

Nuestro nuevo Estructura programada desagregada (DSF) para nuestros clústeres de IA de próxima procreación ofrece varias ventajas sobre nuestros conmutadores existentes. Al desplegar nuestra estructura de red podemos exceder las limitaciones de escalera, opciones de suministro de componentes y densidad de energía. DSF funciona con energía abierta OCP-EFS en serie y FOBOSEl propio sistema operante de red de Meta para controlar conmutadores de red. Todavía admite una interfaz RoCE abierta y en serie basada en Ethernet para puntos finales y aceleradores en varias GPUS y NICS de varios proveedores diferentes, incluidos nuestros socios de NVIDIA, Broadcom y AMD.

Adicionalmente de DSF, asimismo hemos desarrollado y construido nuevos conmutadores de estructura 51T basados en Broadcom y Cisco ASIC. Finalmente, compartimos nuestro nuevo FBNIC, un nuevo módulo NIC que contiene nuestro primer ASIC de red Meta-design. Para satisfacer las crecientes micción de nuestra IA

Meta y Microsoft: impulsando juntos la innovación abierta

Meta y Microsoft tienen una asociación de larga data en el interior de OCP, comenzando con el exposición de Cambiar interfaz de contemplación (SAI) para centros de datos en 2018. A lo liberal de los primaveras juntos, hemos contribuido a iniciativas secreto como la Módulo acelerador descubierto (OAM) en serie y estandarización de SSD, lo que muestra nuestro compromiso compartido con el avance de la innovación abierta.

Nuestro contemporáneo La colaboración se centra en el Monte Diablo.un nuevo power rack desagregado. Es una decisión de vanguardia que presenta una pelotón escalable de 400 VCC que mejoría la eficiencia y la escalabilidad. Este diseño renovador permite más aceleradores de IA por rack de TI, lo que mejoría significativamente la infraestructura de IA. Estamos entusiasmados de continuar nuestra colaboración a través de esta contribución.

El futuro descubierto de la infraestructura de IA

Meta reto por la IA de código descubierto. Creemos que el código descubierto pondrá los beneficios y oportunidades de la IA en manos de personas de todo el mundo.

La IA no alcanzará todo su potencial sin colaboración. Necesitamos marcos de software abiertos para impulsar la innovación de modelos, certificar la portabilidad y promover la transparencia en el exposición de la IA. Todavía debemos priorizar modelos abiertos y estandarizados para poder beneficiarse la experiencia colectiva, hacer que la IA sea más accesible y trabajar para minimizar los sesgos en nuestros sistemas.

Igual de importante es que asimismo necesitamos sistemas de hardware de IA abiertos. Estos sistemas son necesarios para ofrecer el tipo de infraestructura adaptable, rentable y de suspensión rendimiento necesaria para el avance de la IA.

Alentamos a cualquiera que quiera ayudar a avanzar en el futuro de los sistemas de hardware de IA a involucrarse con la comunidad OCP. Al chocar juntos las micción de infraestructura de la IA, podemos desbloquear la verdadera promesa de una IA abierta para todos.