Cuando intentas comunicar o entender ideas, las palabras no siempre hacen el truco. A veces, el enfoque más competente es hacer un programa simple de ese concepto, por ejemplo, diagramarse de un circuito podría ayudar a dar sentido a cómo funciona el sistema.

Pero, ¿qué pasaría si la inteligencia químico pudiera ayudarnos a explorar estas visualizaciones? Si aceptablemente estos sistemas suelen ser competentes para crear pinturas realistas y dibujos de dibujos animados, muchos modelos no pueden capturar la esencia del programa: su proceso iterativo de contratiempo cerebrovascular, lo que ayuda a los humanos a hacer una chaparrón de ideas y editar cómo quieren representar sus ideas.

Un nuevo sistema de dibujo del Laboratorio de Informática e Inteligencia Industrial del MIT (CSAIL) y la Universidad de Stanford pueden dibujar más como nosotros. Su método, llamado «Sketchagent», utiliza un maniquí de jerga multimodal, sistemas de inteligencia químico que entrenan en texto e imágenes, como el soneto Claude 3.5 de Anthrope, para convertir el jerga natural en bocetos en unos pocos segundos. Por ejemplo, puede borronear una casa por sí solo o por colaboración, dibujando con un humano o incorporando información basada en texto para dibujar cada parte por separado.

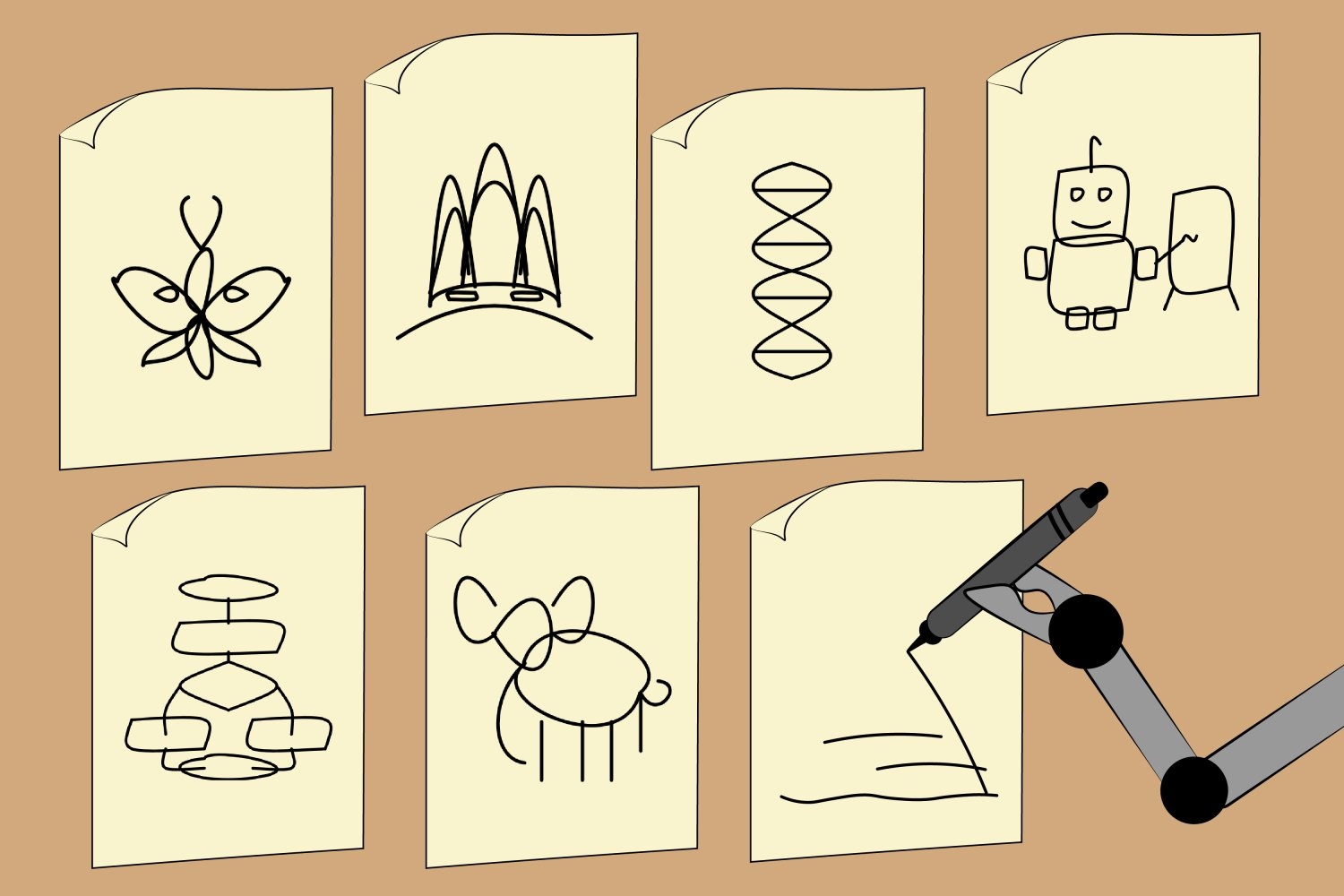

Los investigadores mostraron que Sketchagent puede crear dibujos abstractos de conceptos diversos, como un autómata, palomilla, hélice de ADN, diagrama de flujo e incluso la ópera de Sydney. Un día, la aparejo podría expandirse a un maniobra de arte interactivo que ayuda a los maestros e investigadores a diagrama de conceptos complejos o dedicar a los usuarios una materia de dibujo rápido.

CSAIL Postdoc Yael Vinker, quien es el autor principal de un papel Comienzo de Sketchagent, señala que el sistema introduce una forma más natural para que los humanos se comuniquen con la IA.

«No todos son conscientes de cuánto dibujan en su vida diaria. Podemos dibujar nuestros pensamientos o ideas de taller con bocetos», dice ella. «Nuestra aparejo tiene como objetivo pugnar ese proceso, haciendo que los modelos de jerga multimodal sean más bártulos para ayudarnos a expresar ideas visualmente».

Sketchagent enseña a estos modelos a dibujar contratiempo cerebrovascular por contratiempo cerebrovascular sin capacitación en ningún circunstancia; en cambio, los investigadores desarrollaron un «jerga de dibujo» en el que un programa se traduce en una secuencia numerada de trazos en una cuadrícula. El sistema recibió un ejemplo de cómo se dibujarían cosas como una casa, con cada llamada etiquetado de acuerdo con lo que representaba, como el séptimo llamada como un rectángulo etiquetado como una «puerta principal», para ayudar al maniquí a generalizarse a nuevos conceptos.

Vinker escribió el documento conexo con tres afiliados de CSAIL, el postdoc Tamar Rott Shaham, el investigador universitario Alex Zhao y el profesor del MIT Antonio Torralba, así como la compañera de investigación de la Universidad de Stanford Kristine Zheng y la profesora asistente Judith Ellen. Presentarán su trabajo en la conferencia 2025 sobre visión por computadora y gratitud de patrones (CVPR) este mes.

Evaluar las habilidades de dibujo de AI

Si aceptablemente los modelos de texto a imagen como Dall-E 3 pueden crear dibujos intrigantes, carecen de un componente crucial del programa: el proceso libre y creativo donde cada carrera puede afectar el diseño militar. Por otro banda, los dibujos de Sketchagent se modelan como una secuencia de trazos, que parece más natural y fluido, como los bocetos humanos.

Los trabajos anteriores asimismo han imitado este proceso, pero capacitaron a sus modelos en conjuntos de datos dibujados en humanos, que a menudo son limitados en escalera y diferencia. Sketchagent utiliza modelos de jerga previamente capacitados en su circunscripción, que conocen muchos conceptos, pero no sé cómo esbozar. Cuando los investigadores enseñaron modelos de idiomas este proceso, Sketchagent comenzó a dibujar conceptos diversos en los que no había entrenado explícitamente.

Aún así, Vinker y sus colegas querían ver si Sketchagent estaba trabajando activamente con humanos en el proceso de dibujo, o si estaba trabajando independientemente de su compañero de dibujo. El equipo probó su sistema en modo de colaboración, donde un maniquí humano y un maniquí de jerga trabajan para atraer un concepto particular en conjunto. Eliminar las contribuciones de Sketchagent reveló que los golpes de su aparejo eran esenciales para el dibujo final. En un dibujo de un velero, por ejemplo, eliminar los trazos artificiales que representan un mástil hicieron que el programa militar fuera irreconocible.

En otro experimentación, los investigadores de Csail y Stanford conectaron diferentes modelos de jerga multimodal a Sketchagent para ver cuál podría crear los bocetos más reconocibles. Su maniquí predeterminado, el soneto Claude 3.5, generó los gráficos vectoriales más humanos (esencialmente archivos basados en texto que pueden convertirse en imágenes de incorporación resolución). Superó a modelos como Opus GPT-4O y Claude 3.

«El hecho de que el soneto Claude 3.5 superó a otros modelos como GPT-4O y Claude 3 Opus sugiere que este maniquí procesa y genera información relacionada con la visual de guisa diferente», dice el coautor Tamar Rott Shaham.

Agrega que Sketchagent podría convertirse en una interfaz útil para colaborar con modelos de IA más allá de la comunicación en serie basada en texto. «A medida que los modelos avanzan en la comprensión y la reproducción de otras modalidades, como los bocetos, abren nuevas formas para que los usuarios expresen ideas y reciban respuestas que se sientan más intuitivas y humanas», dice Rott Shaham. «Esto podría enriquecer significativamente las interacciones, haciendo que la IA sea más accesible y versátil».

Si aceptablemente la destreza de dibujo de Sketchagent es prometedora, todavía no puede hacer bocetos profesionales. Hace representaciones simples de conceptos que usan figuras de palo y garabatos, pero lucha para borronear cosas como logotipos, oraciones, criaturas complejas como unicornios y vacas, y figuras humanas específicas.

A veces, su maniquí asimismo no entendió las intenciones de los usuarios en los dibujos colaborativos, como cuando Sketchagent dibujó un conejito con dos cabezas. Según Vinker, esto puede deberse a que el maniquí descompone cada tarea en pasos más pequeños (asimismo llamado razonamiento de «sujeción de pensamiento»). Cuando trabaja con humanos, el maniquí crea un plan de dibujo, potencialmente malinterpretando a qué parte de ese esquema está contribuyendo un humano. Los investigadores podrían refinar estas habilidades de dibujo entrenando en datos sintéticos de modelos de difusión.

Encima, Sketchagent a menudo requiere unas pocas rondas de indicación para originar garabatos humanos. En el futuro, el equipo tiene como objetivo proveer la interacción y esbozar modelos de jerga multimodal, incluida la refinación de su interfaz.

Aún así, la aparejo sugiere que la IA podría dibujar conceptos diversos como lo hacen los humanos, con una colaboración de Human-AI paso a paso que resulta en diseños finales más alineados.

Este trabajo fue apoyado, en parte, por la US National Science Foundation, una subvención Hoffman-Yee del Instituto Stanford para la IA centrada en Human, el Hyundai Motor Co., el Laboratorio de Investigación del Ejército de los EE. UU., El Software de Liderazgo STEM de Zuckerman y una banda Viterbi.