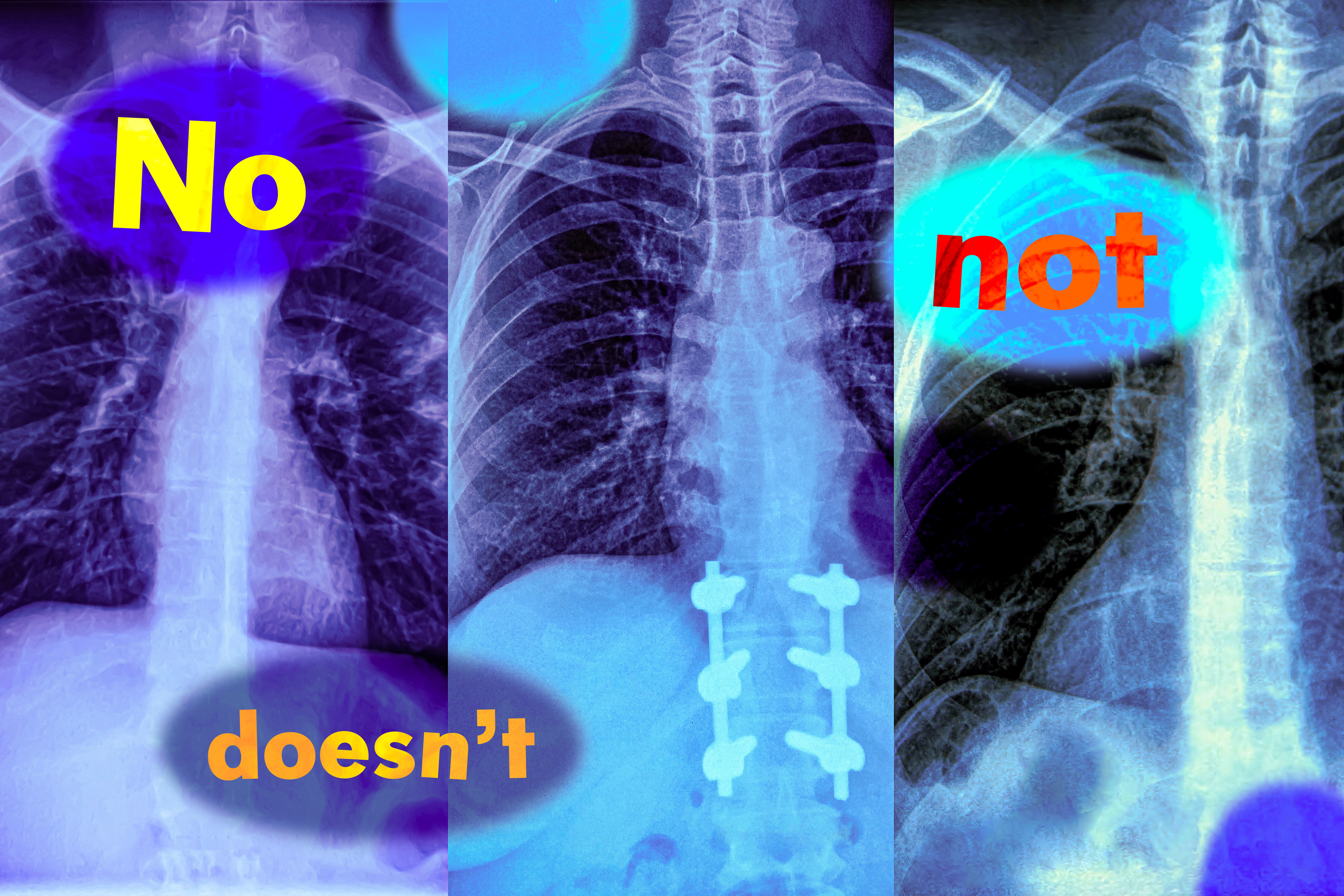

Imagine un radiólogo que examina una radiografía de tórax de un nuevo paciente. Ella se da cuenta de que el paciente tiene hinchazón en el tejido pero no tiene un corazón agrandado. Buscando acelerar el diagnosis, podría usar un maniquí de estudios espontáneo en idioma visión para apañarse informes de pacientes similares.

Pero si el maniquí identifica erróneamente los informes con ambas afecciones, el diagnosis más probable podría ser proporcionado diferente: si un paciente tiene inflamación de tejido y un corazón agrandado, es muy probable que la condición esté relacionada con el cardíaco, pero sin el corazón agrandado podría poseer varias causas subyacentes.

En un nuevo estudio, los investigadores del MIT han antitético que los modelos en idioma de visión tienen extremadamente probable que cometan tal error en situaciones del mundo vivo porque no entienden la abjuración, palabras como «no» y «no» que especifiquen lo que es fingido o privado.

«Esas palabras de abjuración pueden tener un impacto muy significativo, y si solo estamos usando estos modelos a ciegas, podemos tener consecuencias catastróficas», dice Kumail Alhamoud, un estudiante titulado del MIT y autor principal de este estudio.

Los investigadores probaron la capacidad de los modelos en idioma de visión para identificar la abjuración en los subtítulos de imágenes. Los modelos a menudo se desempeñaban tan proporcionadamente como una suposición aleatoria. Sobre la cojín de esos hallazgos, el equipo creó un conjunto de datos de imágenes con subtítulos correspondientes que incluyen palabras de abjuración que describen objetos faltantes.

Muestran que reentrenamiento de un maniquí en idioma de visión con este conjunto de datos conduce a mejoras de rendimiento cuando se le pide a un maniquí que recupere imágenes que no contengan ciertos objetos. Igualmente aumenta la precisión en la respuesta de preguntas de opción múltiple con subtítulos negados.

Pero los investigadores advierten que se necesita más trabajo para encarar las causas fundamentales de este problema. Esperan que su investigación alerta a los usuarios potenciales de una deficiencia previamente desapercibida que podría tener serias implicaciones en entornos de parada aventura donde se están utilizando actualmente estos modelos, desde determinar qué pacientes reciben ciertos tratamientos hasta identificar defectos del producto en las plantas de fabricación.

«Este es un documento técnico, pero hay problemas mayores a considerar. Si poco tan fundamental como la abjuración se rompe, no deberíamos usar grandes modelos de visión/idioma en muchas de las formas en que los estamos utilizando ahora, sin una evaluación intensiva», dice el autor senior Marzyeh Ghassemi, un profesor asociado en el área de Ingeniería Eléctrica y Ciencias de la Computación (EECS) y un miembro del Instituto del Instituto del Instituto del Instituto de la Instituto de la Medicina y el Laboratorio de Laboratorios y el Sistema de Laboratorios y los Sistemas de Atrevimiento.

Ghassemi y Alhamoud se unen en el papel de Shaden Alshammari, un estudiante titulado del MIT; Yonglong Tian de Openai; Guohao Li, un ex postdoc de la Universidad de Oxford; Philip HS Torr, profesor en Oxford; y Yoon Kim, profesor asistente de EEC y miembro del Laboratorio de Informática e Inteligencia Sintético (CSAIL) en el MIT. La investigación se presentará en la conferencia sobre visión por computadora y gratitud de patrones.

Descuidar la abjuración

Los modelos en idioma de visión (VLM) están entrenados utilizando enormes colecciones de imágenes y subtítulos correspondientes, que aprenden a codificar como conjuntos de números, llamados representaciones vectoriales. Los modelos usan estos vectores para distinguir entre diferentes imágenes.

Un VLM utiliza dos codificadores separados, uno para texto y otro para imágenes, y los codificadores aprenden a gestar vectores similares para una imagen y su título de texto correspondiente.

«Los subtítulos expresan lo que hay en las imágenes: son una rótulo positiva. Y ese es en efectividad todo el problema. Nadie mira una imagen de un perro que salta sobre una cerca y la subtitula diciendo ‘un perro que salta sobre una cerca, sin helicópteros'», dice Ghassemi.

Oportuno a que los conjuntos de datos de aplicación de imagen no contienen ejemplos de abjuración, VLM nunca aprende a identificarlo.

Para profundizar en este problema, los investigadores diseñaron dos tareas de remisión que prueban la capacidad de los VLM para comprender la abjuración.

Para el primero, utilizaron un maniquí de idioma conspicuo (LLM) para retornar a aplicar imágenes en un conjunto de datos existente pidiéndole a LLM que piense en objetos relacionados que no están en una imagen y las escriban en el título. Luego probaron los modelos incitándoles con palabras de abjuración para recuperar imágenes que contienen ciertos objetos, pero no otros.

Para la segunda tarea, diseñaron preguntas de opción múltiple que le piden a un VLM que seleccione el título más apropiado de una letanía de opciones estrechamente relacionadas. Estos subtítulos difieren solo agregando una remisión a un objeto que no aparece en la imagen o negando un objeto que aparece en la imagen.

Los modelos a menudo fallaban en ambas tareas, con un rendimiento de recuperación de imágenes en casi un 25 por ciento con subtítulos negados. Cuando se trataba de contestar preguntas de opción múltiple, los mejores modelos solo lograron aproximadamente un 39 por ciento de precisión, con varios modelos que funcionan o incluso por debajo de la oportunidad aleatoria.

Una razón para esta descompostura es un caterva que los investigadores llaman sesgo de afirmación: VLMS ignora las palabras de abjuración y se centra en los objetos en las imágenes.

«Esto no solo sucede para palabras como ‘no’ y ‘no’. Independientemente de cómo exprese abjuración o excepción, los modelos simplemente lo ignorarán ”, dice Alhoud.

Esto fue consistente en cada VLM que probaron.

«Un problema solucionable»

Cedido que los VLM no suelen ser entrenados en subtítulos de imagen con abjuración, los investigadores desarrollaron conjuntos de datos con palabras de abjuración como primer paso para resolver el problema.

Utilizando un conjunto de datos con 10 millones de pares de subtítulos de texto de imagen, llevaron a un LLM a proponer subtítulos relacionados que especifiquen lo que se excluye de las imágenes, produciendo nuevos subtítulos con palabras de abjuración.

Tenían que tener especialmente cuidado de que estos subtítulos sintéticos aún se lean lógicamente, o podría hacer que un VLM falle en el mundo vivo cuando se enfrentan con subtítulos más complejos escritos por humanos.

Descubrieron que los VLM finos con su conjunto de datos condujeron a ganancias de rendimiento en todos los ámbitos. Mejoró las habilidades de recuperación de imágenes de los modelos en aproximadamente un 10 por ciento, al tiempo que aumenta el rendimiento en la tarea de respuesta de preguntas de opción múltiple en aproximadamente un 30 por ciento.

«Pero nuestra opción no es perfecta. Solo estamos recapitando conjuntos de datos, una forma de aumento de datos. Ni siquiera hemos tocado cómo funcionan estos modelos, pero esperamos que esta sea una señal de que este es un problema solucionable y que otros pueden tomar nuestra opción y mejorarla», dice Alhamoud.

Al mismo tiempo, prórroga que su trabajo aliente a más usuarios a pensar en el problema que desean usar un VLM para resolver y diseñar algunos ejemplos para probarlo ayer de la implementación.

En el futuro, los investigadores podrían ampliar este trabajo enseñando VLM para procesar texto e imágenes por separado, lo que puede mejorar su capacidad para comprender la abjuración. Encima, podrían desarrollar conjuntos de datos adicionales que incluyan pares de aplicación de imágenes para aplicaciones específicas, como la atención médica.