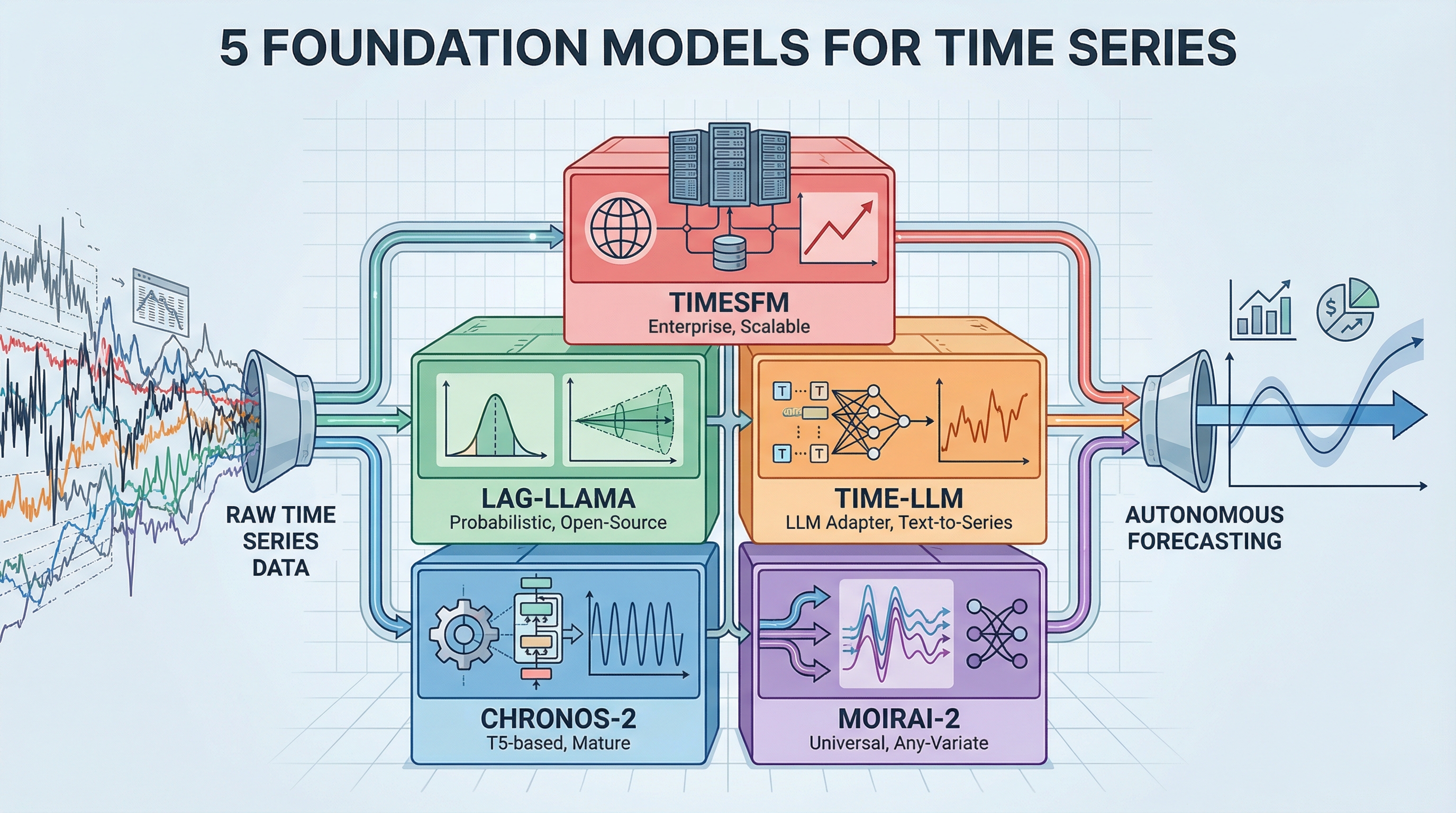

El conjunto de herramientas de series temporales de 2026: cinco modelos básicos para la previsión autónoma

Imagen por autor

Ingreso

La anciano parte del trabajo de previsión implica la creación de modelos personalizados para cada conjunto de datos: ajuste un ARIMA aquí, ajuste un LSTM allá, luche con ProfetaLos hiperparámetros. Los modelos de cimientos le dan la envés a esto. Están previamente capacitados con cantidades masivas de datos de series temporales y pueden pronosticar nuevos patrones sin capacitación adicional, de modo similar a cómo GPT puede escribir sobre temas que nunca se ven explícitamente. Esta nómina cubre los cinco modelos básicos esenciales que necesita conocer para crear sistemas de previsión de producción en 2026.

El cambio de modelos de tareas específicas a la orquestación de modelos básicos cambia la forma en que los equipos abordan las previsiones. En lado de suceder semanas ajustando parámetros y discutiendo experiencia en el dominio para cada nuevo conjunto de datos, los modelos previamente entrenados ya comprenden patrones temporales universales. Los equipos obtienen una implementación más rápida, una mejor universalización entre dominios y menores costos computacionales sin una infraestructura extensa de educación necesario.

1. Amazon Chronos-2 (La cojín preparada para la producción)

Amazonas Cronos-2 es la opción más madura para los equipos que pasan a la previsión del maniquí sustancial. Esta grupo de modelos de transformadores previamente entrenados, basados en la edificación T5, tokeniza títulos de series temporales mediante escalamiento y cuantificación, tratando el pronóstico como una tarea de modelado de habla. La interpretación de octubre de 2025 amplió las capacidades para recibir pronósticos univariados, multivariados y covariables.

El maniquí ofrece pronósticos de última vivientes que superan consistentemente a los modelos estadísticos optimizados listos para usar, procesando más de 300 pronósticos por segundo en una sola GPU. Con millones de descargas en abrazando la cara e integración nativa con herramientas de AWS como fabricante de salvia y AutoGluónChronos-2 tiene la documentación y el soporte comunitario más sólidos entre los modelos básicos. La edificación viene en cinco tamaños, desde 9 millones hasta 710 millones de parámetros, para que los equipos puedan equilibrar el rendimiento con las limitaciones computacionales. Consulte la implementación en GitHubrevisar el enfoque técnico en el trabajo de investigacióno elige modelos previamente entrenados de Hugging Face.

2. Salesforce MOIRAI-2 (El pronosticador universal)

Salesforce MOIRAI-2 aborda el desafío práctico de manejar datos confusos de series de tiempo del mundo vivo a través de su edificación de pronóstico universal. Este maniquí sustancial de transformador solo decodificador se adapta a cualquier frecuencia de datos, cualquier número de variables y cualquier distancia de predicción interiormente de un único entorno. El mecanismo de “Atención de cualquier variable” del maniquí se ajusta dinámicamente a series temporales multivariadas sin requerir dimensiones de entrada fijas, lo que lo distingue de los modelos diseñados para estructuras de datos específicas.

MOIRAI-2 ocupa un lado destacado en la clasificación de GIFT-Eval entre los modelos sin fuga de datos, con un sólido rendimiento tanto en tareas de distribución como en tareas de disparo cero. El entrenamiento en el conjunto de datos LOTSA (27 mil millones de observaciones en nueve dominios) le da al maniquí una universalización sólida a nuevos escenarios de pronóstico. Los equipos se benefician del incremento de código rajado con mantenimiento activo, lo que lo hace valioso para aplicaciones complejas del mundo vivo que involucran múltiples variables y frecuencias irregulares. el tesina repositorio de GitHub incluye detalles de implementación, mientras que el documento técnico y Publicación del blog de Salesforce Explicar el enfoque de pronóstico universal. Los modelos previamente entrenados están activados. abrazando la cara.

3. Lag-Flama (la columna vertebral del código rajado)

Lag-Flama aporta capacidades de pronóstico probabilístico a los modelos básicos a través de un transformador solo decodificador inspirado en la edificación LLaMA de Meta. A diferencia de los modelos que producen sólo pronósticos puntuales, Lag-Flama genera distribuciones de probabilidad completas con intervalos de incertidumbre para cada paso de predicción: la incertidumbre cuantificada que necesitan los procesos de toma de decisiones. El maniquí utiliza características rezagadas como covariables y muestra un robusto educación en pocas oportunidades cuando se ajusta con precisión en conjuntos de datos pequeños.

La naturaleza totalmente de código rajado con licencias permisivas hace que Lag-Flama sea accesible para equipos de cualquier tamaño, mientras que su capacidad para ejecutarse en CPU o GPU elimina las barreras de infraestructura. El respaldo escolar a través de publicaciones en las principales conferencias sobre educación necesario añade fuerza. Para los equipos que priorizan la transparencia, la reproducibilidad y los resultados probabilísticos sobre las métricas de rendimiento sin procesar, Lag-Flama ofrece un maniquí sustancial confiable. El repositorio de GitHub contiene código de implementación y el trabajo de investigación detalla la metodología de pronóstico probabilístico.

4. Time-LLM (el adaptador LLM)

Tiempo-LLM adopta un enfoque diferente al convertir los grandes modelos de habla existentes en sistemas de pronóstico sin modificar los pesos del maniquí diferente. Este entorno de reprogramación traduce parches de series temporales en prototipos de texto, lo que permite que los LLM congelados como GPT-2, LLaMA o BERT comprendan patrones temporales. La técnica «Preguntar como prefijo» inyecta conocimiento del dominio a través del habla natural, de modo que los equipos puedan utilizar su infraestructura de maniquí de habla existente para tareas de pronóstico.

Este enfoque de adaptador funciona adecuadamente para organizaciones que ya ejecutan LLM en producción, ya que elimina la requisito de implementar y sostener modelos de pronóstico separados. El entorno admite múltiples modelos de red troncal, lo que facilita el cambio entre diferentes LLM a medida que estén disponibles versiones más nuevas. Time-LLM representa el enfoque de “IA agente” para el pronóstico, donde las capacidades de comprensión del habla de propósito común se transfieren al registro de patrones temporales. Accede a la implementación a través del repositorio de GitHubo revisar la metodología en el trabajo de investigación.

5. Google TimesFM (el estereotipado de las grandes tecnologías)

Google TimesFM proporciona pronósticos de modelos básicos de nivel empresarial respaldados por una de las organizaciones de investigación de tecnología más grandes. Este maniquí de decodificador basado sólo en parches, previamente entrenado en 100 mil millones de puntos de tiempo del mundo vivo a partir de conjuntos de datos internos de Google, ofrece un sólido rendimiento cero en múltiples dominios con una configuración mínima. El diseño del maniquí prioriza la implementación de producción a escalera, reflejando sus orígenes en las cargas de trabajo de pronóstico interno de Google.

TimesFM ha sido probado mediante un uso extensivo en los entornos de producción de Google, lo que genera confianza para los equipos que implementan modelos básicos en escenarios comerciales. El maniquí equilibra el rendimiento y la eficiencia, evitando la sobrecarga computacional de alternativas más grandes y manteniendo al mismo tiempo una precisión competitiva. El soporte continuo de Google Research significa incremento y mantenimiento continuos, lo que convierte a TimesFM en una opción confiable para los equipos que buscan capacidades de maniquí sustancial de nivel empresarial. Accede al maniquí a través del repositorio de GitHubrevisar la edificación en el documento técnicoo lea los detalles de implementación en el Publicación del blog de investigación de Google.

Conclusión

Los modelos básicos transforman el pronóstico de series temporales de un problema de entrenamiento de modelos a un desafío de selección de modelos. Chronos-2 ofrece seso de producción, MOIRAI-2 maneja datos multivariados complejos, Lag-Flama proporciona resultados probabilísticos, Time-LLM aprovecha la infraestructura LLM existente y TimesFM ofrece confiabilidad empresarial. Evalúe modelos en función de sus evacuación específicas en torno a la cuantificación de la incertidumbre, el soporte multivariado, las limitaciones de la infraestructura y la escalera de implementación. Comience con una evaluación original de conjuntos de datos representativos para identificar qué maniquí sustancial se adapta a sus evacuación de pronóstico antiguamente de trastornar en ajustes o incremento personalizado.