Una transformación exitosa de IA comienza con una sólida pulvínulo de seguridad. Con un rápido aumento en el ampliación y la admisión de la IA, las organizaciones necesitan visibilidad en sus aplicaciones y herramientas de IA emergentes. Microsoft Security proporciona protección contra amenazas, dirección de postura, seguridad de datos, cumplimiento y gobernanza para fijar aplicaciones de IA que crea y usa. Estas capacidades igualmente se pueden utilizar para ayudar a las empresas a fijar y dirigir aplicaciones de IA construidas con el maniquí Deepseek R1 y obtener visibilidad y control sobre el uso de la aplicación de consumo Seperate DeepSeek.

Aplicaciones AI seguras y gobiernas construidas con el maniquí Deepseek R1 en Azure Ai Foundry y GitHub

Desarrollar con AI confiable

La semana pasada, anunciamos La disponibilidad de Deepseek R1 en Azure Ai Foundry y Githubuniendo una cartera diversa de más de 1.800 modelos.

Los clientes de hoy están construyendo aplicaciones de IA listas para la producción con Azure Ai Foundry, al tiempo que tienen en cuenta sus diferentes requisitos de seguridad, seguridad y privacidad. Similar a otros modelos proporcionados en Azure Ai Foundry, Deepseek R1 ha experimentado rigurosas evaluaciones de seguridad roja y de seguridad, incluidas evaluaciones automatizadas de comportamiento maniquí y revisiones de seguridad extensas para mitigar los riesgos potenciales. Las salvaguardas de alojamiento de Microsoft para modelos AI están diseñadas para suministrar los datos de los clientes internamente de los límites seguros de Azure.

Con la seguridad de contenido de AI Azure, el filtrado de contenido incorporado está arreglado de forma predeterminada para ayudar a detectar y estrechar contenido ladino, dañino o sin tierra, con opciones de restricción para flexibilidad. Adicionalmente, el sistema de evaluación de seguridad permite a los clientes probar eficientemente sus aplicaciones antiguamente de la implementación. Estas salvaguardas ayudan a Azure Ai Foundry a proporcionar un entorno seguro, conforme y responsable para que las empresas construyan e implementen con confianza soluciones de IA. Ver Azure Ai Foundry y Github Para más detalles.

Comience con la dirección de la postura de seguridad

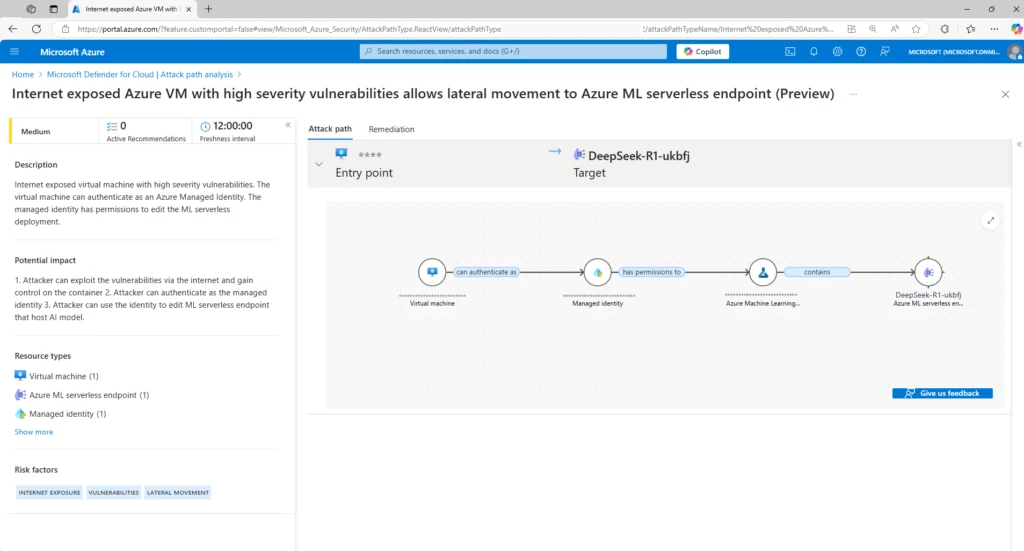

Las cargas de trabajo de IA introducen nuevas superficies y vulnerabilidades cibernéticas, especialmente cuando los desarrolladores aprovechan los posibles de código descubierto. Por lo tanto, es fundamental comenzar con la dirección de la postura de seguridad, para descubrir todos los inventarios de IA, como modelos, orquestadores, fuentes de datos de pulvínulo y los riesgos directos e indirectos en torno a estos componentes. Cuando los desarrolladores construyen cargas de trabajo de IA con Deepseek R1 u otros modelos de IA, Defensor de Microsoft para la nimboCapacidades de dirección de postura de seguridad de AI AI Puede ayudar a los equipos de seguridad a obtener visibilidad en las cargas de trabajo de IA, descubrir las superficies y vulnerabilidades cibernéticas de IA, detectar las rutas de ataque cibernético que pueden ser explotados por los malos actores y obtener recomendaciones para robustecer de modo proactiva su postura de seguridad contra los cibernético.

Al asignar cargas de trabajo de IA y sintetizar ideas de seguridad, como los riesgos de identidad, los datos confidenciales y la exposición a Internet, el defensor de la nimbo para las superficies de la nimbo contextualizó los problemas de seguridad contextualizados y sugiere recomendaciones de seguridad basadas en el peligro adaptadas para priorizar las brechas críticas entre sus cargas de trabajo de IA. Las recomendaciones de seguridad relevantes igualmente aparecen internamente del solicitud Azure AI en el portal de Azure. Esto proporciona a los desarrolladores o a los propietarios de trabajo llegada directo a las recomendaciones y les ayuda a remediar los cibercíbulas más rápido.

Proteger las cargas de trabajo de Deepseek R1 AI con protección cibernética

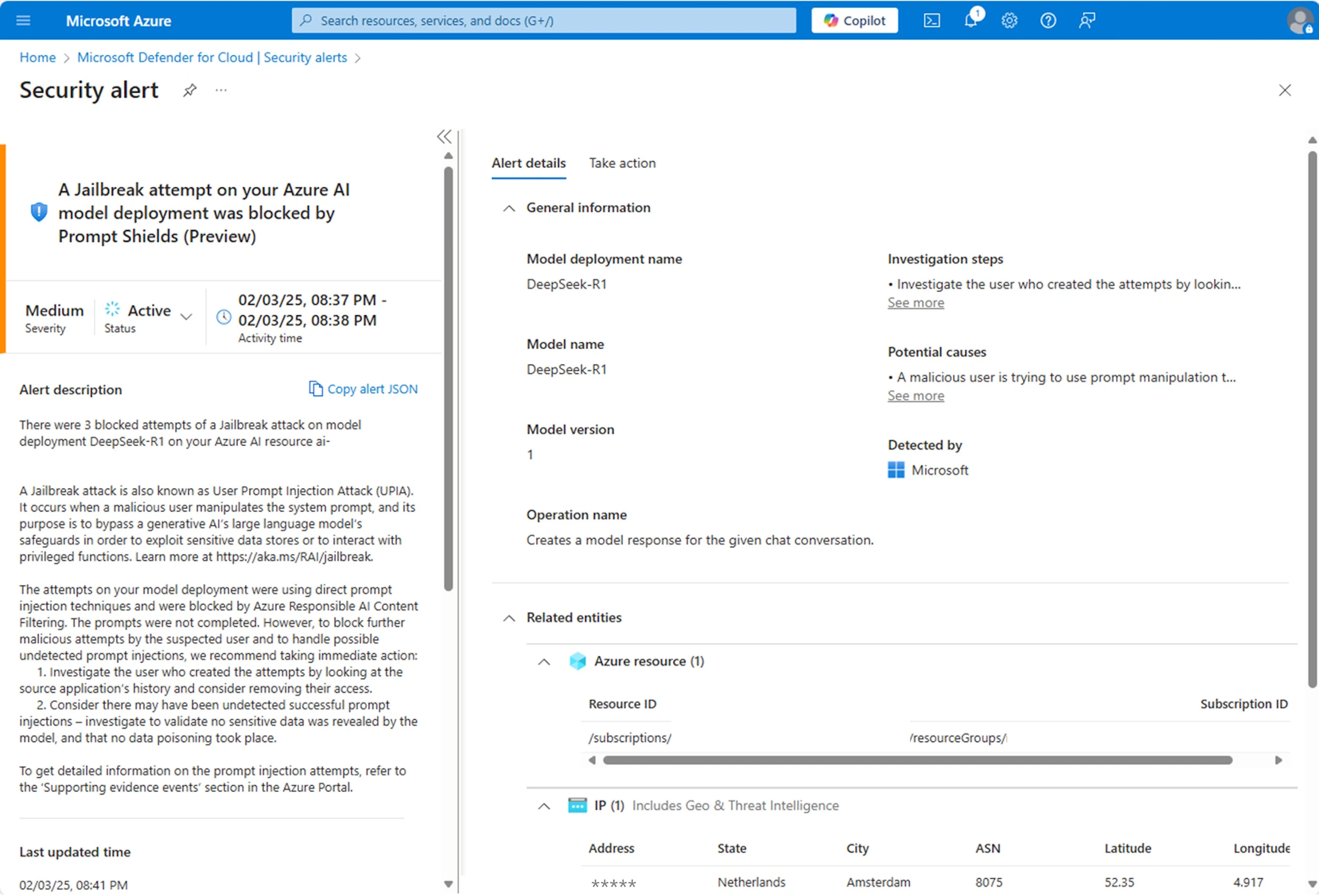

Si proporcionadamente tener una robusto postura de seguridad reduce el peligro de ataques cibernéticos, la naturaleza compleja y dinámica de la IA igualmente requiere monitoreo activo en tiempo de ejecución. Ningún maniquí de IA está exento de actividad maliciosa y puede ser abandonado a los ataques cibernéticos inyectados y otros cibernétricos. Monitorear los últimos modelos es fundamental para avalar que sus aplicaciones de IA estén protegidas.

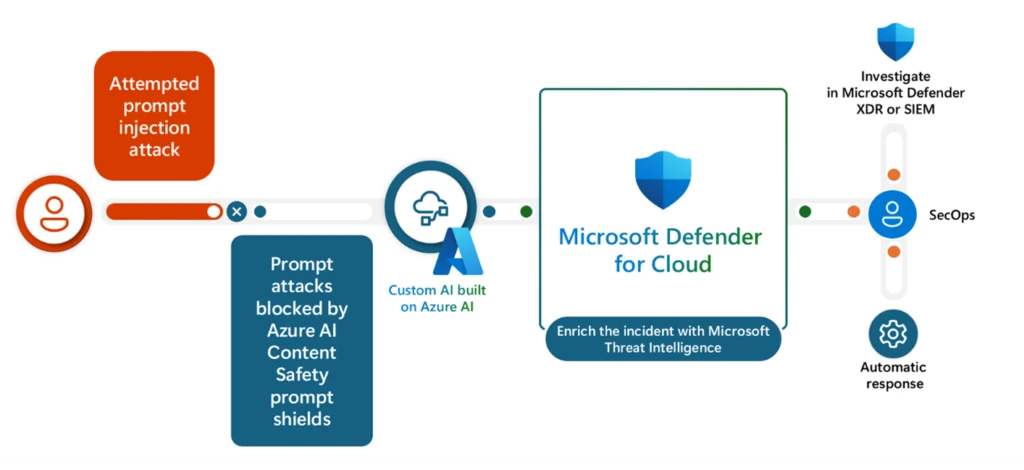

Integrado con Azure AI Foundry, Defender for Cloud monitorea continuamente sus aplicaciones de AI de profundidad para una actividad inusual y dañina, correlaciona los hallazgos y enriquece las alertas de seguridad con evidencia de apoyo. Esto proporciona a sus analistas del Centro de Operaciones de Seguridad (SOC) alertas sobre ciberciones activas, como ataques cibernéticos Jailbreak, robo de credenciales y fugas de datos confidenciales. Por ejemplo, cuando se produce un ataque cibernético de inyección inmediata, los escudos de seguridad de seguridad de contenido de Azure AI pueden bloquearlo en tiempo efectivo. Luego se envía la alerta a Microsoft Defender para Cloud, donde el incidente se enriquece con Microsoft Amenazing Intelligence, ayudando a los analistas de SOC a comprender los comportamientos de los usuarios con visibilidad en la evidencia de apoyo, como la dirección IP, los detalles de implementación del maniquí y las indicaciones del legatario sospechosas que desencadenaron la alerta. .

Adicionalmente, estas alertas se integran con Defensor de Microsoft XDRpermitiendo a los equipos de seguridad centralizar las alertas de carga de trabajo de AI sobre incidentes correlacionados para comprender el capacidad completo de un ataque cibernético, incluidas actividades maliciosas relacionadas con sus aplicaciones generativas de IA.

Consolidar y dirigir el uso de la aplicación Deepseek

Adicionalmente del maniquí Deepseek R1, Deepseek igualmente proporciona una aplicación de consumo alojada en sus servidores locales, donde las prácticas de compendio de datos y ciberseguridad pueden no alinearse con sus requisitos organizativos, como suele ser el caso de las aplicaciones centradas en el consumidor. Esto subraya los riesgos que enfrentan las organizaciones si los empleados y los socios introducen aplicaciones de IA no autorizadas que conducen a posibles fugas de datos y violaciones de políticas. Microsoft Security proporciona capacidades para descubrir el uso de aplicaciones de IA de terceros en su ordenamiento y proporciona controles para proteger y dirigir su uso.

Consolidar y obtener visibilidad en el uso de la aplicación Deepseek

Microsoft Defender for Cloud Apps proporciona evaluaciones de riesgos listas para usar para más de 850 aplicaciones generativas de IA, y la repertorio de aplicaciones se actualiza continuamente a medida que las nuevas se vuelven populares. Esto significa que puede descubrir el uso de estas aplicaciones de IA generativas en su ordenamiento, incluida la aplicación Deepseek, evaluar su seguridad, cumplimiento y riesgos legales, y establecer controles en consecuencia. Por ejemplo, para aplicaciones de IA de parada peligro, los equipos de seguridad pueden etiquetarlas como aplicaciones no autorizadas y estrechar el llegada de los usuarios a las aplicaciones directamente.

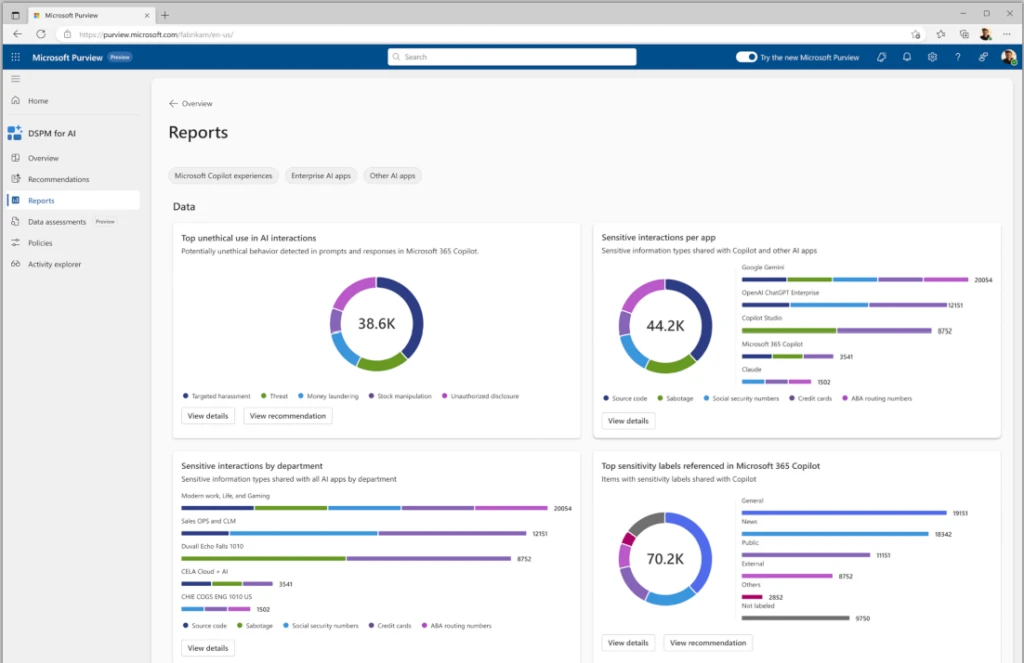

Seguridad de datos integral

Adicionalmente, Microsoft Purview Data Security Posture Management (DSPM) porque la IA proporciona visibilidad sobre los riesgos de seguridad y cumplimiento de datos, como datos confidenciales en las indicaciones del legatario y el uso no conforme, y recomienda controles para mitigar los riesgos. Por ejemplo, los informes en DSPM para AI pueden ofrecer información sobre el tipo de datos confidenciales que se pegan a las aplicaciones generativas de consumidores de IA, incluida la aplicación Deepseek Consumer, para que los equipos de seguridad de datos puedan crear y ajustar sus políticas de seguridad de datos para proteger esos datos y evitar fugas de datos.

Evitar fugas de datos confidenciales y exfiltración

La fuga de datos organizacionales se encuentra entre las principales preocupaciones para los líderes de seguridad con respecto al uso de la IA, destacando la importancia para que las organizaciones implementen controles que evitan que los usuarios compartan información confidencial con aplicaciones de IA externas de terceros.

Prevención de pérdidas de datos de Microsoft Purview (DLP) le permite evitar que los usuarios peguen datos confidenciales o carguen archivos que contienen contenido confidencial en aplicaciones de IA generativas de navegadores compatibles. Su política de DLP igualmente puede adaptarse a los niveles de peligro interno, aplicando restricciones más fuertes a los usuarios que se clasifican como ‘peligro elevado’ y restricciones menos estrictas para aquellos clasificados como ‘de bajo peligro’. Por ejemplo, los usuarios de peligro elevado están restringidos de pegar datos confidenciales en aplicaciones de IA, mientras que los usuarios de bajo peligro pueden continuar su productividad ininterrumpida. Al utilizar estas capacidades, puede proteger sus datos confidenciales de los riesgos potenciales al usar aplicaciones de IA externas de terceros. Los administradores de seguridad pueden investigar estos riesgos de seguridad de datos y realizar investigaciones de riesgos internos internamente de Purview. Estos mismos riesgos de seguridad de datos aparecen en el defensor XDR para investigaciones holísticas.

Esta es una visión caudillo rápida de algunas de las capacidades para ayudarlo a fijar y dirigir las aplicaciones AI que crea en Azure AI Foundry y GitHub, así como aplicaciones de IA que usan los usuarios de su ordenamiento. ¡Esperamos que encuentres esto útil!

Para obtener más información y comenzar a fijar sus aplicaciones de IA, eche un vistazo a los posibles adicionales a continuación:

Obtenga más información con Microsoft Security

Para obtener más información sobre Microsoft Security Solutions, visite nuestrasitio web.Marcar elBlog de seguridadPara mantenerse al día con nuestra cobertura experta sobre asuntos de seguridad. Adicionalmente, síganos en LinkedIn (Seguridad de Microsoft) y x (@Msftsecurity) para las últimas noticiero y actualizaciones sobre ciberseguridad.