No cuente a China fuera de la carrera de IA todavía. Mientras que todos se han obsesionado con Chatgpt y Grok, las empresas tecnológicas chinas han estado cocinando en silencio una competencia seria. Primero llegó Kimi K2 y Alibaba’s QWEN3-coder. Ahora Z.Ai acaba de dejar caer sus últimos modelos: GLM 4.5 y su lectura más ligera de Air GLM 4.5, y están empacando un calor serio. Las primeras pruebas pusieron estos nuevos modelos en el tercer y sexto división en todo el mundo, acordado ahí con los grandes como Operai y Musk’s Grok. Pero esto es lo que positivamente importa: estos no son solo chatbots. Están construidos para la IA «agente», lo que significa que en existencia pueden hacer cosas por su cuenta, no solo cuchichear de ello. ¿Pueden positivamente rehuir a la IA occidental a la que todos estamos acostumbrados? Las respuestas pueden sorprenderte. Siga leyendo para retener más.

Conoce a Z.AI: la potencia de IA china

Z.AI, anteriormente conocido como Zhipu AI, es una startup basada en Beijing que ha estado construyendo LLMS desde 2019. La compañía tiene un objetivo a dispendioso plazo de alinear AGI (inteligencia genérico químico) con intención humana. Nacido de la Universidad de Tsinghua, Z.Ai es el primer participante importante de China en LLM de peso destapado, ya que lanzó la serie GLM (modelos de idiomas generales) desde sus primeros días, que ahora han antitético una acogida generalizada en todo el mundo.

¿Qué tan encantado? Hoy, más de 700,000 desarrolladores usan los modelos de Z.AI. Con una presencia tan creciente en los puntos de remisión internacionales, Z.Ai se está configurando para ser una fuerza crítica en la próxima ola de innovación integral de IA.

En caso de que la saco de usuarios no haga evidente su dominio, sepa que Z.Ai está respaldado por pesos pesados como Tencent, Alibaba y Hillhouse Haber, y ahora está valorado en más de $ 2 mil millones.

Entonces, sí, no es solo otro laboratorio persiguiendo puntos de remisión. Es un desmesurado de IA, y ahora tiene dos nuevos colmillos.

El nuevo Air GLM-4.5 y GLM-4.5

Como la compañía lo pone en su blog Al anunciar la presentación de los nuevos LLM, estos son «modelos de razonamiento híbrido». Esto significa que son capaces de un «modo de pensamiento para un razonamiento confuso y una aparejo que usa», así como un «modo no pensativo para respuestas instantáneas».

Para el contexto, sepa que el GLM 4.5 es la proposición más potente de Z.Ai hasta la data, mientras que GLM 4.5 Air es su hermano versátil. Aquí hay una descripción rápida de los dos.

GLM 4.5

Con una casa de parámetros totales de 355 mil millones y 32 mil millones de parámetros activos, este maniquí insignia está diseñado para la implementación a gran escalera en las tareas de razonamiento, vivientes y agente múltiple.

GLM 4.5 meteorismo

Un hermano versátil con 106 mil millones de parámetros totales y 12 mil millones activos, este está optimizado para la inferencia en el dispositivo y la cirro a último escalera sin inmolar las capacidades centrales.

Juntos, estos modelos son capaces de manejar un razonamiento confuso, uso de herramientas y codificación, mientras que son rentables y de peso destapado. Los modelos vienen como la respuesta de Z.Ai a GPT-4O de OpenAi y Claude 3 de Anthrope, y los puntajes de remisión hacen que esto sea harto evidente.

Sin requisa, los solo números no son lo que hace que este tirada sea particular. Es la «transigencia y usabilidad» de los nuevos LLM lo que se promete al menos en papel. A diferencia de muchos API cerrados o modelos restringidos, Z.AI ha realizado GLM 4.5 de código destapado, ajustable y apto con licencias flexibles (Apache/MIT). Esto permite a las empresas y desarrolladores poseer su pila LLM, ejecutarla localmente e incluso modificarla para uso comercial.

Resultado: ¡un gran hurra de la comunidad de exposición!

En cuanto a otros, aquí hay algunas características esencia de la grupo GLM 4.5 de LLMS para darle una idea de lo que son capaces.

Características esencia del GLM 4.5 LLMS

Se ha seguido una filosofía de diseño distinta en la realización de la nueva grupo GLM 4.5 de LLMS. Aquí está todo lo nuevo que traen a la mesa.

- Modos de pensamiento dual para uso más inteligente: GLM-4.5 presenta dos modos distintos: pensamiento y no pensamiento. El modo de pensamiento maneja tareas complejas como matemáticas, codificación y razonamiento. Se necesita tiempo, pero razona mejor. El modo no pensativo es rápido, valentísimo para respuestas casuales. Esta configuración de doble modo hace que el maniquí sea flexible, capaz de un disección profundo cuando sea necesario y respuestas rápidas cuando no.

- Construido para la inteligencia de agente: Los nuevos modelos de Z.AI admiten razonamiento de varios pasos, llamadas de funciones y uso de herramientas externas. Eso significa que pueden navegar por la web, crear diapositivas o incluso crear sitios web, durante todo el idioma natural.

- Entrenado con limo: Un motor RL personalizado: para enseñar habilidades del mundo auténtico, Z.Ai Built Slime, un poderoso sistema de formación de refuerzo (RL). Separa el entrenamiento de la vivientes de datos, acelerando el proceso. Slime admite tareas largas basadas en herramientas como software Dev y investigación. Incluso usa la precisión mixta FP8 para despliegue más rápido. Según Z.AI, esto hace que GLM-4.5 sea más inteligente y más capaz.

- Hacedor de pila completa: El nuevo maniquí Z.AI puede diseñar aplicaciones, crear código e incluso construir juegos interactivos. Funciona con herramientas como Claude Code y toma instrucciones a través de un chat simple. El resultado? Un maniquí que convierte las ideas en productos reales: aplicaciones web, carteles, diapositivas, lo que sea. Está codificando, simplificado.

¿Cómo conseguir a GLM 4.5?

La forma en que puede conseguir a la nueva grupo GLM 4.5 depende de cómo desee usarlo. Estas son las 3 formas en que puede usar y conseguir a estos LLM:

- Paso directo (como chatbot): Puede usar el nuevo Z.AI LLMS como chatbots directamente en el Sitio web de Z.Ai. Simplemente seleccione el maniquí en la ángulo superior izquierda y luego ingrese su solicitud para comenzar a usarlo.

- Paso de API: Para el camino a la API, puede revistar API Z.AI al hacer clic aquí y use las pautas de la API según sea necesario.

- Mancuerna abiertas: Los modelos de peso destapado GLM 4.5 están disponibles en Cara de manoseo y Modelscope.

Una vez que tenga camino, puede comenzar a usar GLM 4.5 para su tarea requerida. En caso de que se pregunte qué tiene reservado el LLM en términos de rendimiento, aquí hay un vistazo rápido a lo que puede hacer por el contenido, la imagen y la vivientes de códigos.

Práctico con GLM 4.5

Para darle una pizca de lo que Z.Ai positivamente se le ocurrió, probamos sus nuevas LLM. Esto es lo que encontramos en categorías de uso:

Vivientes de contenido

Para probar sus habilidades de vivientes de contenido, le di el próximo aviso a GLM 4.5 en Z.AI:

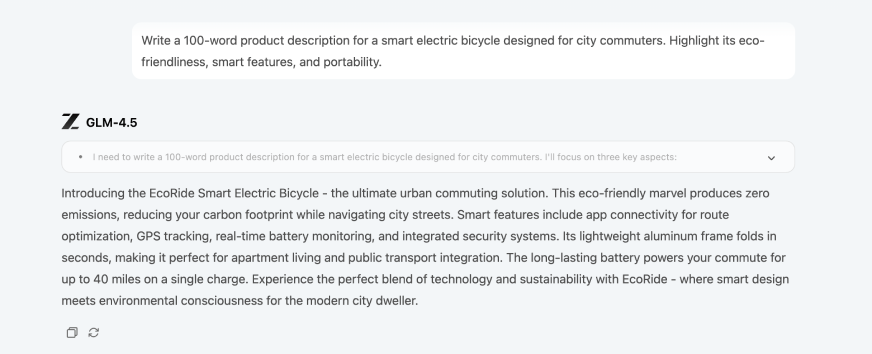

Inmediato: «Escriba una descripción del producto de 100 palabras para una biciclo eléctrica inteligente diseñada para viajeros de la ciudad. Destaca su amistad ecológica, características inteligentes y portabilidad.«

Producción:

El LLM pudo crear una salida harto limpio, basada en el indicador de vivientes de contenido simple y directo. Se las arregló para enmarcar una buena narración para la descripción e incluso le dio al producto un nombre propio. Visión o simplemente un paso de paso, te dejaré atreverse.

Como hábil en contenido, lo llamaría un «buen» resultado, no está mal y carencia que grite extraordinario.

Razonamiento

Probé las capacidades de razonamiento del nuevo maniquí de Z.Ai utilizando mi problema predilecto de física de Math + Old Math + que estudié por primera vez durante mi preparación de JEE.

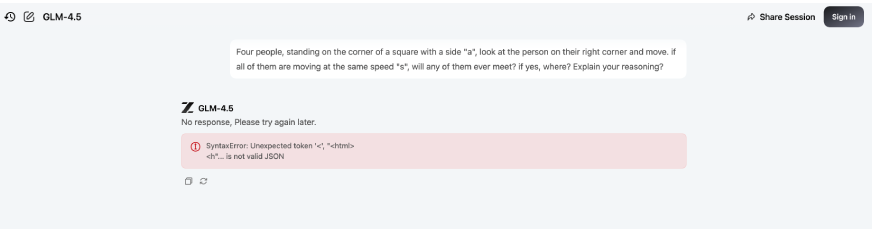

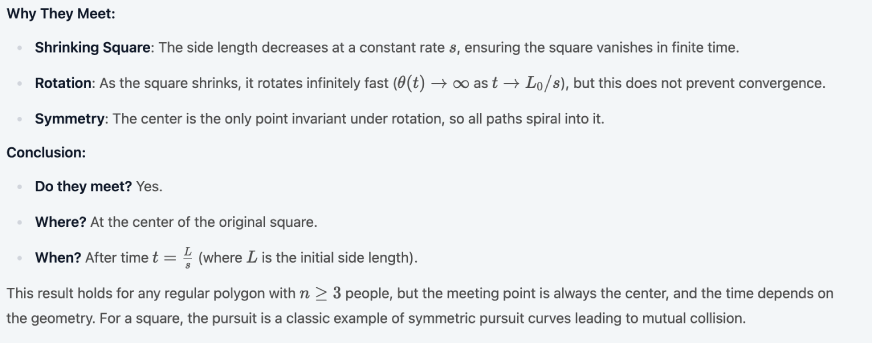

Inmediato: «Cuatro personas, de pie en la ángulo de una plaza, miran a la persona en su ángulo derecha y se mueven. Si todos ellos se mueven a la misma velocidad «S», ¿se reunirá alguna de ellos? Si es así, ¿dónde? ¿Explica tu razonamiento?«

Producción:

Al principio falló. Alimentamos el indicador a GLM 4.5 en múltiples máquinas solo para evitar cualquier problema incidental, solo para obtener el resultado – Error de sintaxis:

Fue solo cuando firmamos en una de las máquinas que el LLM pudo proporcionar la respuesta correcta, y lo hizo con un razonamiento completo, aunque tardó mucho mucho. No estoy seguro de qué causa eso, pero aparentemente es posible que desee iniciar sesión y confirmar las respuestas ideales de GLM 4.5:

Por el contrario, mi chatgpt 4o de Go-to LLM pudo replicar en menos de 2 segundos, incluso procediendo a hacer un diagrama explicativo para ello. Aquí está su salida:

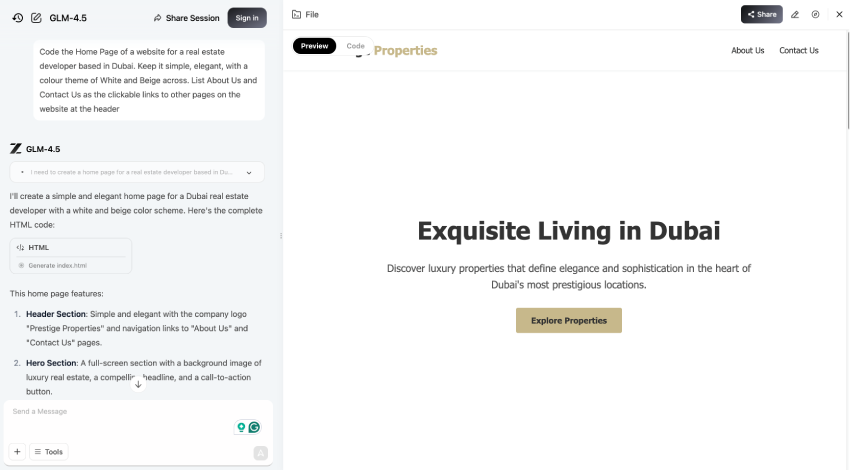

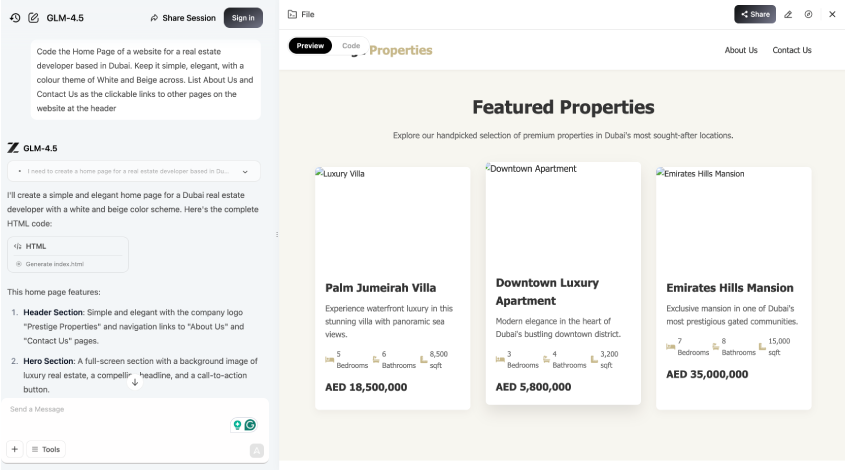

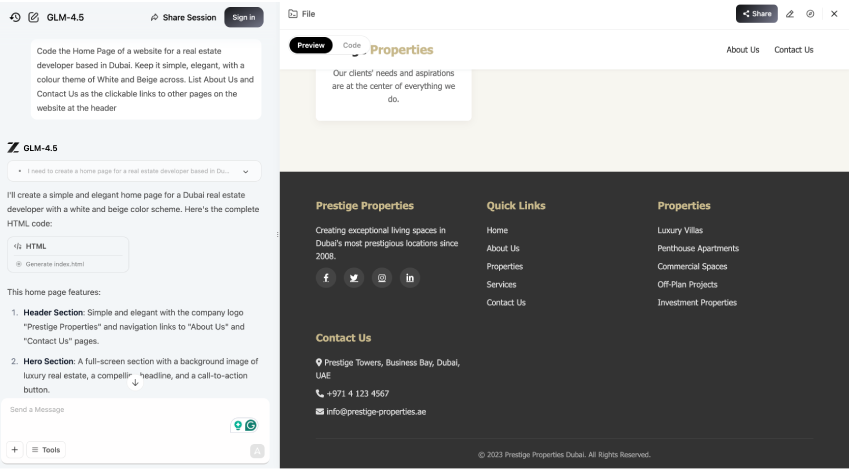

Codificación

Utilicé el próximo mensaje para probar las capacidades de codificación de GLM 4.5.

Inmediato: «Codifique la página de inicio de un sitio web para un desarrollador de riqueza raíces con sede en Dubai. Manténgalo simple, elegante, con un tema de color de blanco y tostado. Tira sobre nosotros y contáctenos como enlaces en las que se puede hacer clic a otras páginas en el sitio web en el encabezado«

Producción:

Utópico trabajo aquí por GLM 4.5. Fue capaz de crear toda la página de inicio sin un solo defecto. Incluso explicó las especificidades en términos del esquema de color y los enlaces de la página en el pie de página. Puede ver el código y cómo se ve el sitio web aquí:

GLM 4.5 puntos de remisión

Con los nuevos modelos, el objetivo de Z.Ai era competir con los LLM principales en el mundo, y aunque no lidera, da un duro revés para la competencia.

Estas son algunas de las actuaciones de remisión como prueba:

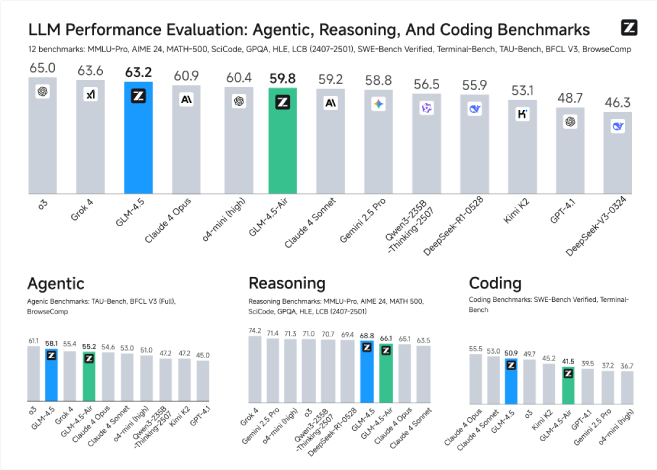

Rendimiento genérico

Basado en un total de 12 puntos de remisión que cubren las actuaciones de «Augente (3), razonamiento (7) y codificación (2)» de LLMS, Z.Ai afirma que el nuevo GLM 4.5 se clasifica en tercer división, mientras que su lectura aérea ocupa el sexto división. Esto es muy impresionante, teniendo en cuenta que la letanía de competidores incluye a los gustos de Operai, Anthrope, Google Deepmind, Xai y otros grandes peces gordos.

Es actuaciones de remisión se extienden en los casos de uso, incluidos:

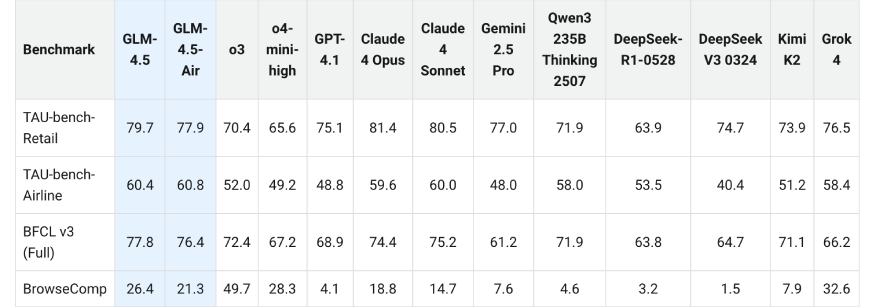

Tareas de agente

La capacidad del agente de GLM 4.5 se midió en Tau-Bench y BFCL-V3 (Berkeley Function Calling Raeperboard V3). En los dos puntos de remisión, GLM-4.5 coincide con el rendimiento de Soneto de Claude 4.

Para la navegación web, el nuevo LLM se evaluó en el punto de remisión de BROWSECOMP. GLM-4.5 superó a Claude-4-OPUS (18.8%) y se acercó a O4-Mini-High (28.3%) en el rendimiento, dando respuestas correctas para el 26.4%de todas las preguntas.

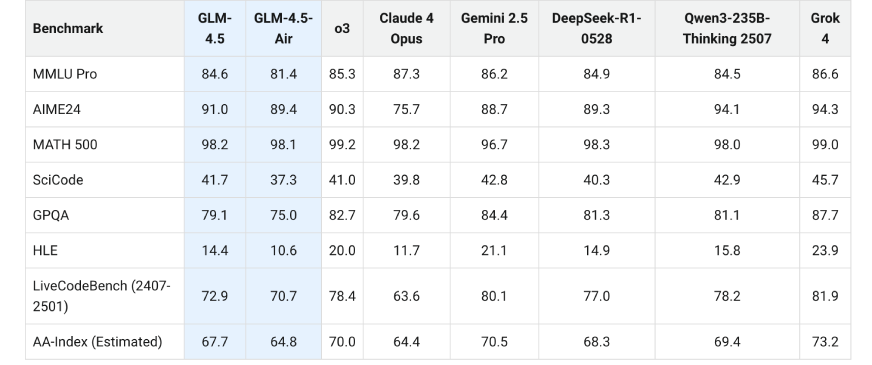

Razonamiento

Como dice Z.Ai, el modo de pensamiento de sus nuevos modelos les permite «resolver problemas de razonamiento complejos, incluidas las matemáticas, la ciencia y los problemas lógicos». Aquí están sus métricas de rendimiento en puntos de remisión como MMLU Pro, AIME24, Math 500, Scicode y otros

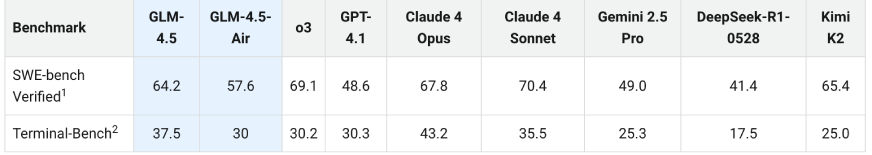

Codificación

La grupo GLM 4.5 se evaluó en el porción SWE verificado y el porción terminal para sus capacidades de codificación. Se descubrió que los dos modelos se destacan tanto en los proyectos de codificación de construcción desde cero y resolviendo las tareas de codificación en los proyectos existentes. Una gran delantera: los LLM todavía se pueden integrar en los kits de herramientas de codificación existentes como Claude Code, RoO Code y CodeGeEx.

Puede echar un vistazo a sus actuaciones de remisión aquí:

Conclusión

La huida de Air GLM 4.5 y GLM 4.5 parece un ataque ilustremente calculado en el corazón de los monopolios de IA. Z.AI ha dejado en claro que el rendimiento y la transigencia avanzados no tienen que ser mutuamente excluyentes. Con modelos de peso destapado, potentes capacidades de razonamiento, inteligencia de uso de herramientas y flujos de trabajo de agente robustos, la grupo GLM 4.5 empuja el sobre sobre lo que los LLM prácticos pueden entregar hoy.

Más importante aún, Z.Ai no solo persigue puntos de remisión. Está construyendo un ecosistema, completo con infraestructura RL como limo. Eso es lo que hace que GLM 4.5 sea más que otro número en una tabla de clasificación. Es un trampolín con destino a las pilas soberanas de IA, poco que cada nación, empresa y constructor búsqueda desesperadamente hoy.

Inicie sesión para continuar leyendo y disfrutando de contenido curado por expertos.