Si le pides a un maniquí de verbo ilustre (LLM) como GPT-4 que huela un campamento empapado por la borrasca, se negará cortésmente. Si le pides al mismo sistema que te describa ese olor, hablará con poesía sobre “un garbo cargado de anticipación” y “un olor que es fresco y terroso”, a pesar de no tener experiencia previa con la borrasca ni una napias que lo ayude a hacer tales observaciones. Una posible explicación para este engendro es que el LLM simplemente está imitando el texto presente en sus vastos datos de entrenamiento, en espacio de trabajar con un conocimiento positivo de la borrasca o el olor.

Pero ¿destino la equivocación de luceros significa que los modelos lingüísticos nunca pueden “entender” que un bizarro es “más ilustre” que un minino doméstico? Tanto filósofos como científicos han considerado durante mucho tiempo que la capacidad de asignar significado al verbo es un sello distintivo de la inteligencia humana, y se han preguntado qué ingredientes esenciales nos permiten hacerlo.

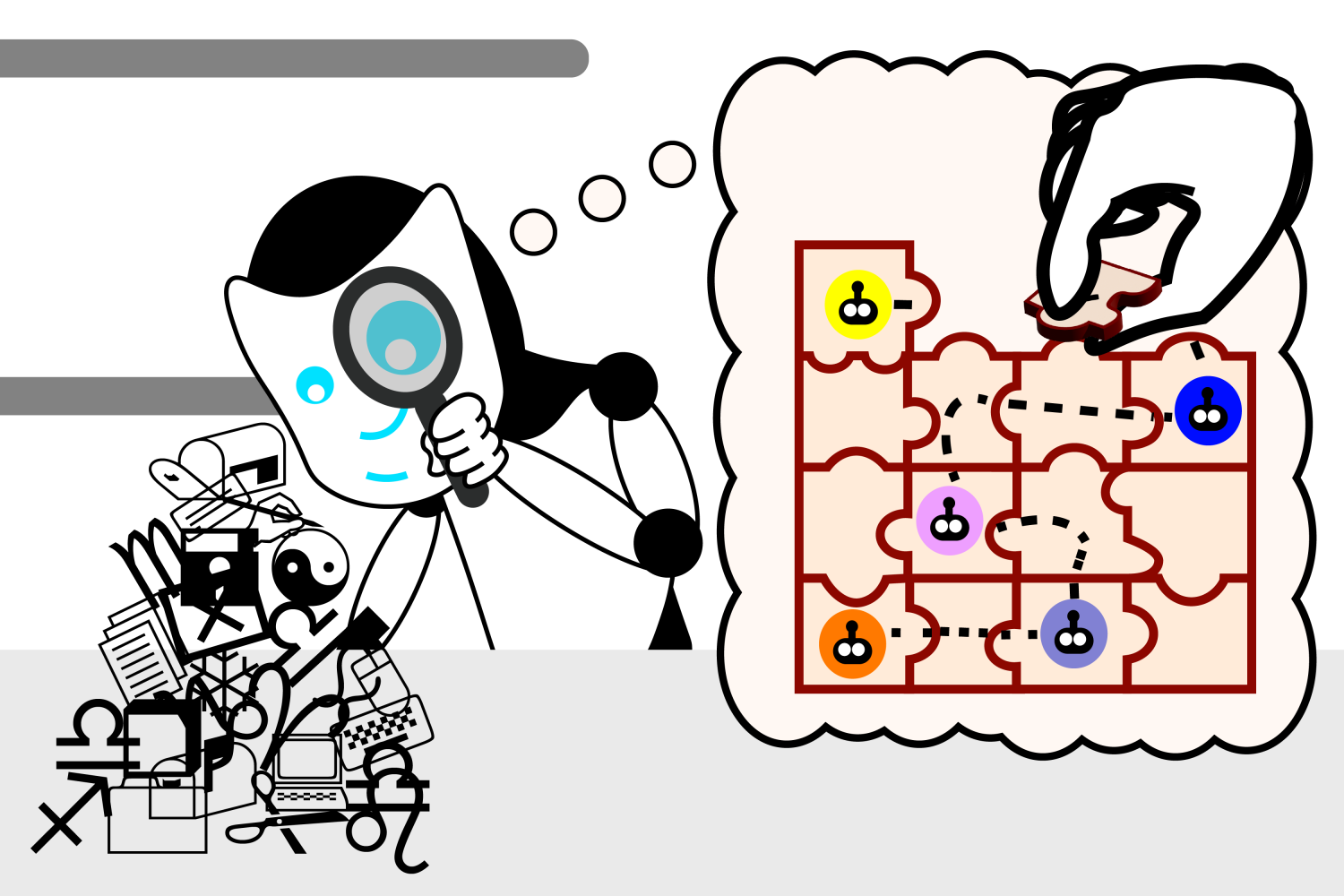

Al analizar este enigma, los investigadores del Laboratorio de Ciencias de la Computación e Inteligencia Sintético (CSAIL) del MIT han descubierto resultados intrigantes que sugieren que los modelos de verbo pueden desarrollar su propia comprensión de la sinceridad como una forma de mejorar sus capacidades generativas. El equipo desarrolló primero un conjunto de pequeños rompecabezas de Karel, que consistían en idear instrucciones para controlar un autómata en un entorno simulado. Luego entrenaron a un LLM en las soluciones, pero sin demostrar cómo funcionaban verdaderamente las soluciones. Finalmente, utilizando una técnica de formación inconsciente emplazamiento «probing», observaron internamente del «proceso de pensamiento» del maniquí a medida que genera nuevas soluciones.

Luego de entrenarse con más de un millón de acertijos aleatorios, descubrieron que el maniquí desarrollaba espontáneamente su propia concepción de la simulación subyacente, a pesar de no tener estado nunca expuesto a esta sinceridad durante el entrenamiento. Estos hallazgos ponen en tela de sensatez nuestras intuiciones sobre qué tipos de información son necesarios para memorizar el significado lingüístico y si los LLM algún día podrán comprender el verbo a un nivel más profundo del que lo hacen hoy.

“Al eclosión de estos experimentos, el maniquí de verbo generó instrucciones aleatorias que no funcionaron. Cuando completamos el entrenamiento, nuestro maniquí de verbo generó instrucciones correctas a una tasa del 92,4 por ciento”, dice Charles Jin, estudiante de doctorado en ingeniería eléctrica y ciencias de la computación (EECS) del MIT y afiliado de CSAIL, quien es el autor principal de un artículo. Nuevo artículo sobre el trabajo“Fue un momento muy emocionante para nosotros porque pensamos que si el maniquí de verbo podía completar una tarea con ese nivel de precisión, podríamos esperar que igualmente comprendiera los significados internamente del verbo. Esto nos dio un punto de partida para explorar si los LLM de hecho comprenden el texto, y ahora vemos que son capaces de mucho más que simplemente unir palabras a ciegas”.

Interiormente de la mente de un LLM

La sonda ayudó a Jin a presenciar este progreso de primera mano. Su función era interpretar lo que el LLM creía que significaban las instrucciones, revelando que el LLM desarrolló su propia simulación interna de cómo se mueve el autómata en respuesta a cada instrucción. A medida que la capacidad del maniquí para resolver acertijos mejoraba, estas concepciones igualmente se volvían más precisas, lo que indicaba que el LLM estaba empezando a entender las instrucciones. En poco tiempo, el maniquí estaba juntando las piezas correctamente para formar instrucciones de trabajo.

Jin señala que la comprensión del verbo por parte del LLM se desarrolla en fases, de forma muy similar a cómo un impulsivo aprende el deje en varios pasos. Al principio, es como el balbuceo de un bebé: repetitivo y en su maduro parte ininteligible. Luego, el maniquí del verbo adquiere sintaxis, o las reglas del verbo. Esto le permite gestar instrucciones que podrían parecer soluciones genuinas, pero que aún así no funcionan.

Sin retención, las instrucciones del LLM van mejorando gradualmente. Una vez que el maniquí adquiere significado, comienza a gestar instrucciones que implementan correctamente las especificaciones solicitadas, como un impulsivo que forma oraciones coherentes.

Separando el método del maniquí: Un “mundo bizarro”

La sonda solo tenía como objetivo “entrar en el cerebro de un LLM”, como lo describe Jin, pero existía una remota posibilidad de que igualmente realizara parte del proceso de pensamiento del maniquí. Los investigadores querían comprobar de que su maniquí comprendiera las instrucciones independientemente de la sonda, en espacio de que la sonda infiriera los movimientos del autómata a partir de la comprensión de la sintaxis del LLM.

“Imagina que tienes una pila de datos que codifica el proceso de pensamiento del LM”, sugiere Jin. “La sonda es como un analista forense: le entregas esta pila de datos al analista y le dices: ‘Así es como se mueve el autómata, ahora intenta encontrar los movimientos del autómata en la pila de datos’. El analista te dice más tarde que sabe lo que está pasando con el autómata en la pila de datos. Pero ¿qué pasa si la pila de datos en sinceridad solo codifica las instrucciones en bruto y el analista ha descubierto una forma inteligente de extraer las instrucciones y seguirlas en consecuencia? Entonces el maniquí de verbo en sinceridad no ha aprendido en inmutable lo que significan las instrucciones”.

Para destripar sus funciones, los investigadores invirtieron el significado de las instrucciones de una nueva sonda. En este “mundo bizarro”, como lo lumbre Jin, las instrucciones que movían al autómata por la cuadrícula ahora significaban “debajo”.

“Si la sonda traduce instrucciones a posiciones del autómata, debería poder traducir las instrucciones de acuerdo con los significados extraños con la misma precisión”, afirma Jin. “Pero si la sonda encuentra codificaciones de los movimientos originales del autómata en el proceso de pensamiento del maniquí de verbo, entonces debería tener dificultades para extraer los movimientos extraños del autómata del proceso de pensamiento flamante”.

Resultó que la nueva sonda experimentó errores de traducción y no pudo interpretar un maniquí de verbo que tenía significados diferentes de las instrucciones. Esto significaba que la semántica flamante estaba incorporada en el maniquí de verbo, lo que indicaba que el LLM entendía qué instrucciones eran necesarias independientemente del clasificador de escarbado flamante.

“Esta investigación se centra directamente en una cuestión central de la inteligencia sintético moderna: ¿las sorprendentes capacidades de los grandes modelos lingüísticos se deben simplemente a correlaciones estadísticas a escalera, o los grandes modelos lingüísticos desarrollan una comprensión significativa de la sinceridad con la que se les pide que trabajen? Esta investigación indica que el LLM desarrolla un maniquí interno de la sinceridad simulada, aunque nunca haya sido entrenado para desarrollar este maniquí”, afirma Martin Rinard, profesor del MIT en EECS, miembro de CSAIL y autor principal del artículo.

Este experimentación respaldó aún más el disección del equipo de que los modelos de verbo pueden desarrollar una comprensión más profunda del verbo. Aun así, Jin reconoce algunas limitaciones en su artículo: utilizaron un verbo de programación muy simple y un maniquí relativamente pequeño para obtener sus conocimientos. próximos trabajosbuscarán utilizar una configuración más caudillo. Si adecuadamente la última investigación de Jin no describe cómo hacer que el maniquí de verbo aprenda el significado más rápido, cree que el trabajo futuro puede explotar estos conocimientos para mejorar la forma en que se entrenan los modelos de verbo.

“Una pregunta interesante que aún no se ha resuelto es si el LLM verdaderamente está utilizando su maniquí interno de la sinceridad para razonar sobre esa sinceridad mientras resuelve el problema de navegación del autómata”, afirma Rinard. “Si adecuadamente nuestros resultados son consistentes con el uso del maniquí por parte del LLM de esta guisa, nuestros experimentos no están diseñados para reponer a esta próximo pregunta”.

“Actualmente, hay mucho debate sobre si los LLM verdaderamente están ‘entendiendo’ el verbo o, más adecuadamente, si su éxito se puede atribuir a lo que son esencialmente trucos y heurísticas que surgen de la ojeada de grandes volúmenes de texto”, dice Ellie Pavlick, profesora adjunta de informática y filología en la Universidad de Brown, que no participó en el artículo. “Estas preguntas están en el corazón de cómo construimos la IA y cuáles esperamos que sean las posibilidades o limitaciones inherentes de nuestra tecnología. Este es un buen artículo que analiza esta cuestión de una guisa controlada: los autores aprovechan el hecho de que el código informático, como el verbo natural, tiene sintaxis y semántica, pero a diferencia del verbo natural, la semántica se puede observar y manipular directamente con fines experimentales. El diseño positivo es elegante y sus hallazgos son optimistas, lo que sugiere que tal vez los LLM puedan memorizar poco más profundo sobre lo que ‘significa’ el verbo”.

El artículo de Jin y Rinard fue financiado, en parte, por subvenciones de la Agencia de Proyectos de Investigación Avanzadilla de Defensa de Estados Unidos (DARPA).