Los agentes son tan capaces como las herramientas que les da, y solo tan confiables como la gobernanza detrás de esas herramientas.

Esta publicación de blog es la segunda de una serie de blogs de seis partes indicación Industria de agentes que compartirá las mejores prácticas, patrones de diseño y herramientas para ayudarlo a guiarlo a través de la admisión y la construcción de AI de agente.

En el blog aludido, exploramos cinco patrones de diseño comunes de IA agente, desde el uso y consejo de la aparejo hasta la planificación, la colaboración de múltiples agentes y el razonamiento adaptativo. Estos patrones muestran cómo se pueden orquestar los agentes para obtener una automatización confiable y escalable en entornos del mundo vivo.

En toda la industria, estamos viendo un cambio claro. Los primeros experimentos se centraron en las indicaciones de un solo maniquí y los flujos de trabajo estáticos. Ahora, la conversación es sobre extensibilidad—HOW dar a los agentes un conjunto amplio y evolutivo de capacidades sin encerrar en un proveedor o reescribir integraciones para cada nueva obligación. Las plataformas compiten en lo rápido que los desarrolladores pueden:

- Integre con cientos de API, servicios, fuentes de datos y flujos de trabajo.

- Reutilice esas integraciones en diferentes equipos y entornos de tiempo de ejecución.

- Mantenga el control de punto empresarial sobre quién puede tachar a qué, cuándo y con qué datos.

La enseñanza del año pasado de la desarrollo de la IA agente es simple: Los agentes son tan capaces como las herramientas que les da, y solo tan confiables como la gobernanza detrás de esas herramientas.

Extensibilidad a través de estándares abiertos

En las primeras etapas del progreso de agentes, la integración de herramientas fue a menudo un esfuerzo a medida y específico de la plataforma. Cada entorno tenía sus propias convenciones para fijar herramientas, acontecer datos y manejar la autenticación. Esto creó varios bloqueadores consistentes:

- Duplicación del esfuerzo—La misma API interna tuvo que envolverse de forma diferente para cada tiempo de ejecución.

- Integraciones frágiles—Mall, los cambios de esquemas o puntos finales podrían romper múltiples agentes a la vez.

- Reutilización limitada—Los pendientes construidas para un equipo o entorno eran difíciles de compartir en todos los proyectos o nubes.

- Gobierno fragmentado—Diferentes tiempos de ejecución impuestos con diferentes modelos de seguridad y políticas.

A medida que las organizaciones comenzaron a desplegar agentes en entornos híbridos y de múltiples nubes, estas ineficiencias se convirtieron en grandes obstáculos. Los equipos necesitaban una forma de estandarizar cómo se describen, descubren e invocan las herramientas, independientemente del entorno de alojamiento.

Ahí es donde protocolos abiertos entró en la conversación. Así como HTTP transformó la Web creando un jerga popular para clientes y servidores, los protocolos abiertos para los agentes tienen como objetivo hacer que las herramientas portátiles, interoperables y más fáciles de dirigir.

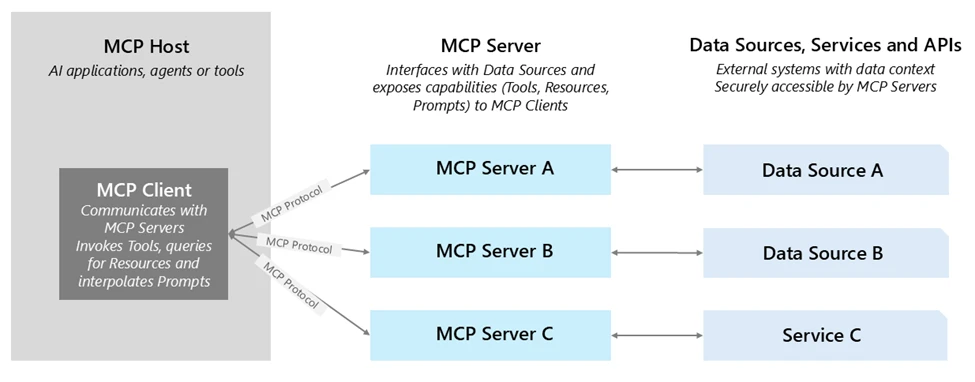

Uno de los ejemplos más prometedores es el Protocolo de contexto maniquí (MCP)—Un standard para fijar las capacidades de herramientas y los esquemas de E/S para que cualquier agente compatible con MCP pueda descubrirlos e invocarlos dinámicamente. Con MCP:

- Las herramientas son autodescritohaciendo el descubrimiento e integración más rápido.

- Los agentes pueden encontrar y usar herramientas en tiempo de ejecución sin cableado manual.

- Las herramientas pueden ser Organizado en cualquier lado—Enlo, en una estrato de socios, o en otra dispositivo de negocios, sin perder el gobierno.

Azure Ai Foundry admite MCP, lo que le permite resistir los servidores MCP existentes directamente a sus agentes. Esto le brinda los beneficios de la interoperabilidad abierta más Seguridad, observabilidad y trámite de punto empresarial. Obtenga más información sobre MCP en Días de progreso de MCP.

Una vez que tenga un standard para la portabilidad a través de protocolos abiertos como MCP, la sucesivo pregunta es: ¿Qué tipo de herramientas deberían tener sus agentes y cómo los organizan para que puedan entregar valía rápidamente mientras se mantienen adaptables?

En Azure Ai Foundry, pensamos en esto como construir un sujeción de herramientas empresarial—Un conjunto de capacidades en capas que equilibran velocidad (obtener poco valioso pasar hoy), diferenciación (capturar lo que hace que su negocio sea único), y alcanzar (Conectando todos los sistemas donde en realidad ocurre el trabajo).

1. Herramientas incorporadas para un valía rápido: Azure Ai Foundry incluye herramientas listas para usar Para evacuación empresariales comunes: despabilarse en SharePoint y Data Lake, ejecutar Python para el exploración de datos, realizar investigaciones web de varios pasos con Bing y activar tareas de automatización del navegador. Estas no son solo comodidades: dejan que los equipos se mantengan en agentes funcionales y de suspensión valía en días en lado de semanas, sin la fricción del trabajo de integración temprana.

2. Herramientas personalizadas para su superioridad competitiva: Cada estructura tiene sistemas y procesos patentados que no pueden ser replicados por herramientas listos para usar. Azure AI Foundry hace que sea sencillo envolverlos como herramientas de IA de agente, ya sea API de su ERP, un sistema de control de calidad de fabricación o el servicio de un socio. Al invocarlos a través de Openapi o MCP, estas herramientas se vuelven portátiles y descubiertas entre equipos, proyectos e incluso nubes, al tiempo que se benefician de las capas de identidad, política y observabilidad de Foundry.

3. Conectores para el mayor valor: A través de Aplicaciones lógicas de AzureFoundry puede conectar a los agentes a más de 1,400 SaaS y sistemas locales: CRM, ERP, ITSM, almacenes de datos y más. Esto reduce drásticamente el elevador de integración, lo que le permite conectarse a los procesos empresariales existentes sin construir cada conector desde cero.

Un ejemplo de esta sujeción de herramientas en actividad proviene de Datos de NTTque construyó agentes en Azure Ai Foundry que integran Agente de datos de Fabric de Microsoft cercano con otras herramientas empresariales. Estos agentes permiten a los empleados a través de fortuna humanos, operaciones y otras funciones interactuar de forma natural con los datos, revelando información en tiempo vivo y habilitando acciones, reduciendo el tiempo de comercialización de 50% y dar a los usuarios no técnicos intuitivos y entrada de hipermercado a la inteligencia empresarial.

La extensibilidad debe emparejarse con la gobernanza para acontecer del prototipo a la automatización cinta para la empresa. Azure Ai Foundry aborda esto con un seguro por defactor Enfoque para la trámite de herramientas:

- Autenticación e identidad en conectores incorporados: Los conectores de punto empresarial, como SharePoint y Microsoft Fabric, ya usan la autenticación (OBO) en el cabriola (OBO). Cuando un agente invoca estas herramientas, Foundry asegura que la indicación respeta los permisos del heredero final a través de ID de ENTRA administrados, preservando las reglas de autorización existentes. Con ID de agente de Microsoft Entracada tesina de agente creado en Azure ai fundición Aparece automáticamente en una presencia de aplicación específica del agente internamente del centro de filial de Microsoft Entra. Esto proporciona a los equipos de seguridad una presencia de directorio unificada de todos los agentes y aplicaciones de agentes que necesitan dirigir en Microsoft. Esta integración marca el primer paso para estandarizar la gobernanza para la compañía de agentes de IA. Si acertadamente Entra ID es nativo, Azure Ai Foundry todavía admite integraciones con sistemas de identidad externos. A través de la Asociación, los clientes que usan proveedores como Okta o Google Identity aún pueden autenticar a los agentes y usuarios para tachar a las herramientas de forma segura.

- Herramientas personalizadas con OpenAPI y MCP: Las herramientas especificadas por OpenAPI habilitan una conectividad perfecta utilizando identidades administradas, claves API o entrada no autenticado. Estas herramientas se pueden registrar directamente en Foundry y alinearse con las mejores prácticas de diseño de API standard. Foundry todavía está expandiendo la seguridad de MCP para incluir credenciales almacenadas, identidades administradas a nivel de tesina y flujos de OAuth de terceros, cercano con redes privadas seguras, advanciando en torno a un maniquí de integración MCP de extremo a extremo y de extremo empresarial.

- Gobierno de API con Azure API Management (APIM): APIM proporciona un poderoso plano de control para la trámite de llamadas de herramientas: permite la publicación centralizada, la aplicación de políticas (autenticación, límites de tarifas, nervio de carga útil) y monitoreo. Encima, puede implementar puertas de enlace autohostadas internamente de VNET o entornos en los primeros para hacer cumplir las políticas empresariales cercanas a los sistemas de backend. Complementando esto, Azure API Center Actúa como un centro centralizado de Inventario de API y descubrimiento de API, que mantiene equipos para registrarse, catalogar y dirigir servidores privados de MCP cercano con otras API. Estas capacidades proporcionan la misma gobernanza que calma para sus API, extendidas a las herramientas de IA de agente sin ingeniería adicional.

- Observabilidad y auditabilidad: Cada invocación de herramientas en Foundry, ya sea interna o externa, es rastreado con registro de nivel de paso. Esto incluye identidad, nombre de la aparejo, entradas, horizontes y resultados, habilitando el monitoreo de la confiabilidad continua y la auditoría simplificada.

La trámite de punto empresarial garantiza que las herramientas sean seguras y observables, pero el éxito todavía depende de cómo las diseñe y las opere desde el primer día. Basándose en la finalidad de fundición de Azure Ai y la experiencia del cliente, se destacan algunos principios:

- Comience con el entendimiento. Trate cada aparejo como un producto API. Concretar entradas claras, horizontes y comportamientos de error, y ayudar los esquemas consistentes entre los equipos. Evite sobrecargar una sola aparejo con múltiples acciones no relacionadas; Las herramientas más pequeñas de un solo propósito son más fáciles de probar, monitorear y reutilizar.

- Elija el embalaje correcto. Para las API patentadas, decida temprano, ya sea que OpenAPI o MCP se adapten mejor a sus evacuación. Las herramientas de OpenAPI son sencillas para las API REST acertadamente documentadas, mientras que las herramientas de MCP se destacan cuando la portabilidad y la reutilización de entreambre son prioridades.

- Centralizar la gobernanza. Transmitir herramientas personalizadas detrás de la trámite de API de Azure o una puerta de enlace autohospedada, por lo que la autenticación, el velocidad y la inspección de la carga útil se aplican de forma consistente. Esto mantiene la dialéctica de la política fuera del código de herramientas y hace que los cambios sean más fáciles de implementar.

- Vincular cada actividad a la identidad. Siempre sepa qué heredero o agente está invocando la aparejo. Para conectores incorporados, aproveche el paso de identidad u obo. Para herramientas personalizadas, use ID de Entra o el maniquí de secreto/credencial API apropiado, y aplique el entrada de menos privilegio.

- Utensilio temprano. Agregue los ganchos de rastreo, registro y evaluación ayer de acontecer a la producción. La observabilidad temprana le permite rastrear las tendencias de rendimiento, detectar regresiones y ajustar herramientas sin tiempo de inactividad.

Seguir estas prácticas garantiza que las herramientas que integran hoy se mantengan seguras, portátiles y mantenibles a medida que crece el ecosistema de su agente.

¿Qué sigue?

En la tercera parte del Industria de agentes serienos centraremos en Observabilidad para los agentes de IA—Ol cómo rastrear cada paso, evaluar el rendimiento de la aparejo y monitorear el comportamiento del agente en tiempo vivo. Cubriremos las capacidades incorporadas en Azure AI Foundry, patrones de integración con Azure Maestro y las mejores prácticas para convertir la telemetría en una prosperidad continua.

¿Te perdiste la primera publicación de la serie? Échale un vistazo: La nueva era de la IA agente: casos de uso comunes y patrones de diseño.