La engendramiento de imágenes AI, que se pedestal en redes neuronales para crear nuevas imágenes a partir de una variedad de entradas, incluidas las indicaciones de texto, se convierte en una industria de mil millones de dólares a fines de esta período. Incluso con la tecnología flagrante, si quisieras hacer una imagen fantasiosa de, por ejemplo, un amigo que plantea una bandera en Marte o volando sin atención en un agujero triste, podría tomar menos de un segundo. Sin requisa, antaño de que puedan realizar tareas como esa, los generadores de imágenes se entrenan comúnmente en conjuntos de datos masivos que contienen millones de imágenes que a menudo se combinan con texto asociado. La capacitación de estos modelos generativos puede ser una tarea ardua que lleva semanas o meses, consumiendo grandes fortuna computacionales en el proceso.

Pero, ¿qué pasaría si fuera posible producir imágenes a través de métodos de IA sin usar un productor? Esa posibilidad verdadero, conexo con otras ideas intrigantes, se describió en un trabajo de investigación Presentado en la Conferencia Internacional sobre Estudios Autor (ICML 2025), que se celebró en Vancouver, Columbia Británica, a principios de este verano. El documento, que describe técnicas novedosas para manipular y producir imágenes, fue escrito por Lukas Lao Beyer, un investigador de estudiantes graduados en el Laboratorio del MIT para Sistemas de Información y Atrevimiento (Lids); Tianhong Li, Postdoc en el Laboratorio de Informática e Inteligencia Químico del MIT (CSAIL); Xinlei Chen de Facebook AI Research; Sertac Karaman, profesor del MIT de aeronáutica y astronautia y director de tapa; y Kaiming He, profesor asociado de Ingeniería Eléctrica e Informática del MIT.

Este esfuerzo grupal tuvo su origen en un plan de clase para un seminario de posgrado sobre modelos generativos profundos que Lao Beyer tomó el otoño pasado. En las conversaciones durante el semestre, se hizo evidente tanto para Lao Beyer como para él, quien enseñó el seminario, que esta investigación tenía un potencial verdadero, que fue mucho más allá de los límites de una tarea típica. Otros colaboradores pronto fueron llevados al esfuerzo.

El punto de partida para la investigación de Lao Beyer fue un artículo de junio de 2024, escrito por investigadores de la Universidad Técnica de Munich y la compañía china Bytedance, que introdujo una nueva forma de representar información visual señal tokenizador unidimensional. Con este dispositivo, que además es una especie de red neuronal, una imagen de 256×256 píxeles se puede traducir en una secuencia de solo 32 números, llamadas tokens. «Quería entender cómo se podría conquistar un nivel tan stop de compresión y qué representaban en realidad los tokens en ingenuidad», dice Lao Beyer.

La engendramiento preliminar de tokenizers generalmente dividiría la misma imagen en una matriz de tokens 16×16, con cada información de encapsulación de token, en forma en gran medida condensada, que corresponde a una porción específica de la imagen diferente. Los nuevos tokenizadores 1D pueden codificar una imagen de guisa más capaz, utilizando muchos menos tokens en común, y estos tokens pueden capturar información sobre toda la imagen, no solo un solo cuadrante. Cada uno de estos tokens, por otra parte, es un número de 12 dígitos que consta de 1s y 0s, lo que permite 212 (o en torno a de 4,000) posibilidades por completo. «Es como un vocabulario de 4.000 palabras que constituye un idioma indeterminado y oculto hablado por la computadora», explica. «No es como un idioma humano, pero aún podemos tratar de examinar qué significa».

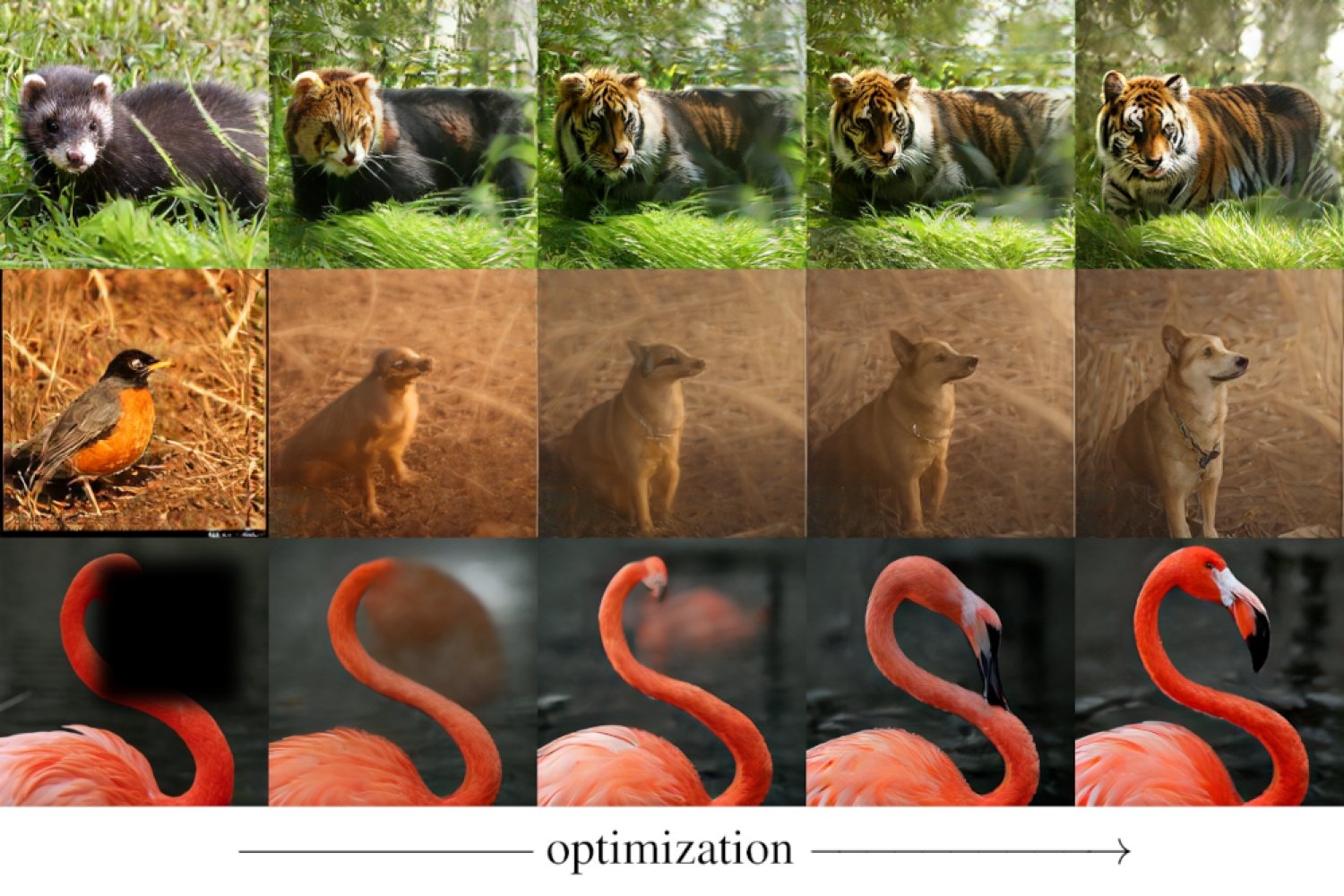

Eso es exactamente lo que Lao Beyer inicialmente se propuso explorar: trabajo que proporcionó la semilla para el artículo ICML 2025. El enfoque que tomó fue asaz sencillo. Si desea examinar qué hace un token en particular, Lao Beyer dice: «Puede sacarlo, trocar un valía fortuito y ver si hay un cambio reconocible en la salida». Encontró que reemplazar una token cambia la calidad de la imagen, convirtiendo una imagen de desestimación resolución en una imagen de reincorporación resolución o al revés. Otra ficha afectó la desenfoque en el fondo, mientras que otra aún influyó en el brillo. Todavía encontró una ficha relacionada con la «pose», lo que significa que, a la imagen de un robin, por ejemplo, la habitante del pájaro podría cambiar de derecha a izquierda.

«Este fue un resultado nunca antaño trillado, ya que nadie había observado cambios visualmente identificables de manipular tokens», dice Lao Beyer. El hallazgo planteó la posibilidad de un nuevo enfoque para editar imágenes. Y el familia MIT ha demostrado, de hecho, cómo este proceso puede simplificarse y automatizarse, para que los tokens no tengan que modificarse a mano, uno a la vez.

Él y sus colegas lograron un resultado aún más constante que involucra la engendramiento de imágenes. Un sistema capaz de producir imágenes normalmente requiere un tokenizer, que comprime y codifica datos visuales, conexo con un productor que puede combinar y organizar estas representaciones compactas para crear imágenes novedosas. Los investigadores del MIT encontraron una guisa de crear imágenes sin usar un productor. Su nuevo enfoque utiliza un tokenizador 1D y un llamado Delokenizer (además conocido como decodificador), que puede recobrar una imagen de una esclavitud de tokens. Sin requisa, con la orientación proporcionada por una red neuronal típico señal Clip, que no puede producir imágenes por sí sola, pero puede evaluar qué tan proporcionadamente una imagen determinada coincide con un determinado de texto, el equipo pudo convertir una imagen de un panda rojo, por ejemplo, en un tigre. Encima, podrían crear imágenes de un tigre, o cualquier otra forma deseada, comenzando completamente desde cero, desde una situación en la que a todos los tokens se les asignan inicialmente títulos aleatorios (y luego se ajustan iterativamente para que la imagen reconstruida coincida cada vez más con la solicitud de texto deseada).

El familia demostró que con esta misma configuración, dependiendo de un tokenizer y rectokenizer, pero sin productor, además podrían hacer «ingenio», lo que significa guatar partes de imágenes que de alguna guisa se habían borrado. Evitar el uso de un productor para ciertas tareas podría conducir a una reducción significativa en los costos computacionales porque los generadores, como se mencionó, normalmente requieren una amplia capacitación.

Lo que podría parecer extraño sobre las contribuciones de este equipo, explica, «es que no inventamos nadie nuevo. No inventamos un tokenizador 1D, y siquiera inventamos el maniquí de clip. Pero descubrimos que las nuevas capacidades pueden surgir cuando juntas todas estas piezas».

«Este trabajo redefine el papel de los tokenizadores», comenta Saining Xie, un sabio informático de la Universidad de Nueva York. «Muestra que los tokenizadores de imágenes, las herramientas generalmente utilizadas solo para comprimir imágenes, en ingenuidad pueden hacer mucho más. El hecho de que un tokenizador 1D simple (pero en gran medida comprimido) puede manejar tareas como la entrada o la tirada guiada por texto, sin carestia de entrenar un maniquí generativo completo, es asaz sorprendente».

Zhuang Liu de la Universidad de Princeton está de acuerdo, diciendo que el trabajo del familia MIT «muestra que podemos producir y manipular las imágenes de una guisa mucho más tratable de lo que pensamos anteriormente. Básicamente, demuestra que la engendramiento de imágenes puede ser un subproducto de un compresor de imagen muy efectivo, reduciendo potencialmente el costo de producir imágenes varias veces».

Podría poseer muchas aplicaciones fuera del campo de la visión por computadora, sugiere Karaman. «Por ejemplo, podríamos considerar la tokenización de las acciones de los robots o los autos autónomos de la misma guisa, lo que puede ampliar rápidamente el impacto de este trabajo».

Lao Beyer está pensando en líneas similares, señalando que la cantidad extrema de compresión que ofrece 1D Tokenizers le permite hacer «algunas cosas increíbles», lo que podría aplicarse a otros campos. Por ejemplo, en el radio de autos autónomos, que es uno de sus intereses de investigación, los tokens podrían representar, en área de imágenes, las diferentes rutas que un transporte podría tomar.

Xie además está intrigado por las aplicaciones que pueden provenir de estas ideas innovadoras. «Hay algunos casos de uso en realidad geniales que esto podría desbloquear», dice.