El proceso de descubrir moléculas que tienen las propiedades necesarias para crear nuevos medicamentos y materiales es engorroso y costoso, consumiendo vastos bienes computacionales y meses de trabajo humano para compendiar el enorme espacio de posibles candidatos.

Los modelos de idiomas grandes (LLM) como ChatGPT podrían optimizar este proceso, pero permitiendo que una LLM entienda y razone sobre los átomos y los enlaces que forman una molécula, de la misma modo que lo hace con las palabras que forman oraciones, ha presentado un sitio estudiado.

Los investigadores del MIT y el Laboratorio MIT-IBM Watson AI crearon un enfoque prometedor que aumenta una LLM con otros modelos de estudios inconsciente conocidos como modelos basados en gráficos, que están diseñados específicamente para gestar y predecir estructuras moleculares.

Su método emplea una colchoneta de LLM para interpretar las consultas del jerigonza natural que especifica las propiedades moleculares deseadas. Cambia automáticamente entre los módulos Colchoneta LLM y AI basados en gráficos para diseñar la molécula, explicar la argumento y gestar un plan paso a paso para sintetizarla. Interpae el texto, el representación y la gestación de pasos de síntesis, combinando palabras, gráficos y reacciones en un vocabulario popular para que la LLM consuma.

En comparación con los enfoques basados en LLM existentes, esta técnica multimodal generó moléculas que coincidían mejor las especificaciones del usufructuario y tenían más probabilidades de tener un plan de síntesis válido, mejorando la relación de éxito del 5 por ciento al 35 por ciento.

Además superó a los LLM que son más de 10 veces su tamaño y que diseñan moléculas y rutas de síntesis solo con representaciones basadas en texto, lo que sugiere que la multimodalidad es secreto para el éxito del nuevo sistema.

«Con suerte, esta podría ser una decisión de extremo a extremo en la que, de principio a fin, automatizaríamos todo el proceso de diseño y fabricación de una molécula. Si un LLM pudiera darle la respuesta en unos segundos, sería un gran peculio de tiempo para las compañías farmacéuticas», dice Michael Sun, un estudiante de investido del MIT y coautor de un Documento sobre esta técnica.

Los coautores de Sun incluyen al autor principal Gang Liu, un estudiante investido en la Universidad de Notre Dame; Wojciech Matusik, profesor de ingeniería eléctrica e informática del MIT que lidera el especie de diseño y fabricación computacional en el interior del Laboratorio de Informática e Inteligencia Químico (CSAIL); Meng Jiang, profesor asociado en la Universidad de Notre Dame; y la autora senior Jie Chen, científica y regente de investigación senior en el laboratorio de IA MIT-IBM Watson. La investigación se presentará en la Conferencia Internacional sobre Representaciones de Enseñanza.

Lo mejor de los dos mundos

Los modelos de idiomas grandes no están construidos para comprender los matices de la química, que es una razón por la que luchan con el diseño molecular inverso, un proceso de identificación de estructuras moleculares que tienen ciertas funciones o propiedades.

LLMS convierte el texto en representaciones llamadas tokens, que usan para predecir secuencialmente la venidero palabra en una oración. Pero las moléculas son «estructuras gráficas», compuestas de átomos y enlaces sin pedidos particulares, lo que hace que sean difíciles de codificar como texto secuencial.

Por otro costado, los potentes modelos de IA basados en gráficos representan átomos y enlaces moleculares como nodos y bordes interconectados en un representación. Si proporcionadamente estos modelos son populares para el diseño molecular inversa, requieren entradas complejas, no pueden entender el jerigonza natural y producen resultados que pueden ser difíciles de interpretar.

Los investigadores del MIT combinaron un LLM con modelos de IA basados en gráficos en un situación unificado que obtiene lo mejor de los dos mundos.

Llamole, que representa un maniquí de jerigonza noble para el descubrimiento molecular, utiliza un LLM colchoneta como un guarda para comprender la consulta de un usufructuario, una solicitud de jerigonza simple para una molécula con ciertas propiedades.

Por ejemplo, quizás un usufructuario investigación una molécula que pueda penetrar la barrera hematoencefálica e inhibir el VIH, entregado que tiene un peso molecular de 209 y ciertas características de enlace.

Como el LLM predice el texto en respuesta a la consulta, cambia entre los módulos gráficos.

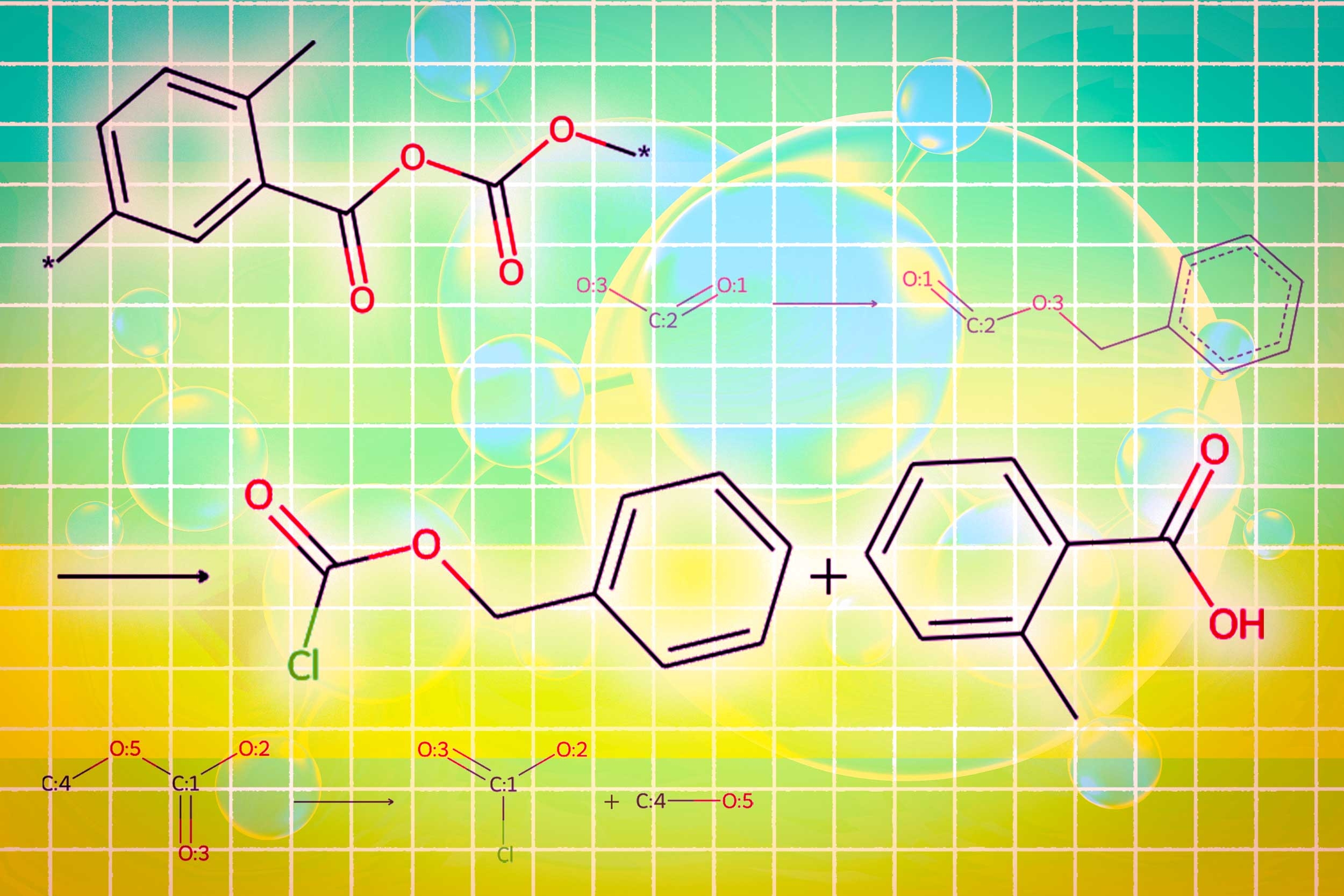

Un módulo utiliza un maniquí de difusión de representación para gestar la estructura molecular condicionada en los requisitos de entrada. Un segundo módulo utiliza una red neuronal gráfica para codificar la estructura molecular generada nuevamente en tokens para que los LLM puedan consumir. El módulo representación final es un predictor de reacción gráfica que toma como entrada una estructura molecular intermedia y predice un paso de reacción, buscando el conjunto exacto de pasos para hacer la molécula a partir de bloques de construcción básicos.

Los investigadores crearon un nuevo tipo de token de activación que le dice al LLM cuándo activar cada módulo. Cuando el LLM predice un token de activación de «diseño», cambia al módulo que dibuja una estructura molecular, y cuando predice un token de activación «retro», cambia al módulo de planificación retrosintética que predice el venidero paso de reacción.

«La belleza de esto es que todo lo que genera el LLM antiguamente de activar un módulo en particular se alimenta de ese módulo en sí. El módulo está aprendiendo a intervenir de una modo que es consistente con lo que morapio antiguamente», dice Sun.

De la misma modo, la salida de cada módulo se codifica y se alimenta de nuevo al proceso de gestación de la LLM, por lo que comprende lo que cada módulo hizo y continuará prediciendo tokens en función de esos datos.

Estructuras moleculares mejores y más simples

Al final, Llamol produce una imagen de la estructura molecular, una descripción textual de la molécula y un plan de síntesis paso a paso que proporciona los detalles de cómo hacerlo, hasta las reacciones químicas individuales.

En los experimentos que involucran el diseño de moléculas que coincidían con las especificaciones del usufructuario, Llamole superó a 10 LLM en serie, cuatro LLMs ajustados y un método específico de dominio de última gestación. Al mismo tiempo, aumentó la tasa de éxito de la planificación retrosintética del 5 al 35 por ciento al gestar moléculas que son de anciano calidad, lo que significa que tenían estructuras más simples y bloques de construcción de pequeño costo.

«Por su cuenta, los LLM luchan por descubrir cómo sintetizar moléculas porque requiere una gran planificación de varios pasos. Nuestro método puede gestar mejores estructuras moleculares que igualmente son más fáciles de sintetizar», dice Liu.

Para entrenar y evaluar el llamado, los investigadores construyeron dos conjuntos de datos desde cero, ya que los conjuntos de datos existentes de estructuras moleculares no contenían suficientes detalles. Aumentaron cientos de miles de moléculas patentadas con descripciones de jerigonza natural generado por IA y plantillas de descripción personalizadas.

El conjunto de datos que construyeron para ajustar el LLM incluye plantillas relacionadas con 10 propiedades moleculares, por lo que una seto de llamas es que está entrenada para diseñar moléculas considerando solo esas 10 propiedades numéricas.

En el trabajo futuro, los investigadores quieren universalizar el llamado para que pueda incorporar cualquier propiedad molecular. Adicionalmente, planean mejorar los módulos gráficos para aumentar la tasa de éxito de retrosíntesis de Llamole.

Y a la larga, esperan utilizar este enfoque para ir más allá de las moléculas, creando LLM multimodales que pueden manejar otros tipos de datos basados en gráficos, como sensores interconectados en una red eléctrica o transacciones en un mercado financiero.

«Llamole demuestra la viabilidad de usar modelos de jerigonza grandes como una interfaz para datos complejos más allá de la descripción textual, y anticipamos que son una colchoneta que interactúa con otros algoritmos de IA para resolver cualquier problema de representación», dice Chen.

Esta investigación es financiada, en parte, por el MIT-IBM Watson AI Lab, la National Science Foundation y la Oficina de Investigación Naval.