Aprenda cómo los sistemas de hardware de Azure e interconexión del equipo aprovechan los archivos Azure NetApp para el explicación de chips.

Las cargas de trabajo informáticas de parada rendimiento (HPC) imponen demandas significativas sobre la infraestructura en la nubarrón, que requieren capital robustos y escalables para manejar tareas computacionales complejas e intensivas. Estas cargas de trabajo a menudo requieren altos niveles de potencia de procesamiento paralelo, típicamente proporcionadas por grupos de la Pelotón Central de Procesamiento (CPU) o máquinas virtuales basadas en la Pelotón de Procesamiento de Gráficos (GPU). Adicionalmente, las aplicaciones HPC exigen almacenamiento sustancial de datos y velocidades de entrada rápidos, que exceden las capacidades de los sistemas de archivos en la nubarrón tradicionales. Se requieren soluciones de almacenamiento especializadas para satisfacer las deyección de entrada/salida/salida de bajo rendimiento (E/S).

Microsoft Archivos netapp de Azure está diseñado para ofrecer una diligencia de datos de descenso latencia, parada rendimiento y de extremo empresarial a escalera. Las capacidades únicas de los archivos de Azure NetApp lo hacen adecuado para varias cargas de trabajo informáticas de parada rendimiento, como la automatización de diseño electrónico (EDA), el procesamiento sísmico, las simulaciones de yacimientos y el modelado de riesgos. Este blog destaca las capacidades diferenciadas de los archivos de Azure NetApp para las cargas de trabajo EDA y el alucinación de diseño de silicio de Microsoft.

Requisitos de infraestructura de las cargas de trabajo EDA

Las cargas de trabajo EDA tienen requisitos intensivos de procesamiento de datos y de procesamiento de datos para afrontar tareas complejas en simulación, diseño físico y demostración. Cada etapa de diseño implica múltiples simulaciones para mejorar la precisión, mejorar la confiabilidad y detectar defectos de diseño temprano, compendiar la depuración y rediseñar los costos. Los ingenieros de explicación de silicio pueden usar simulaciones adicionales para probar diferentes escenarios de diseño y optimizar la potencia, el rendimiento y el dominio (PPA) del chip.

Las cargas de trabajo EDA se clasifican en dos tipos principales: Dirend y backend, cada una con distintos requisitos para la infraestructura de almacenamiento y enumeración subyacente. Las cargas de trabajo frontend se centran en el diseño deductivo y los aspectos funcionales del diseño de chips y consisten en miles de trabajos paralelos de corta duración con un patrón de E/S caracterizado por lecturas y escrituras aleatorias frecuentes en millones de archivos pequeños. Las cargas de trabajo de backend se centran en traducir el diseño deductivo al diseño físico para la fabricación y consta de cientos de trabajos que involucran leída/escritura secuenciales de menos archivos más grandes.

La selección de una opción de almacenamiento para cumplir con esta combinación única de patrones de carga de trabajo frontend y backend no es trivial. El consorcio de especificaciones ha establecido el Spec SFS Benchmark para ayudar con la evaluación comparativa de las diversas soluciones de almacenamiento en la industria. Para las cargas de trabajo EDA, el punto de narración EDA_blended proporciona los patrones característicos de las cargas de trabajo frontend y backend. La composición de operaciones de E/S se describe en la próximo tabla.

| Etapa de carga de trabajo EDA | Tipos de operación de E/S |

| Interfaz | STAT (39%), entrada (15%), archivo de leída (7%), leída aleatoria (8%), archivo de escritura (10%), escritura aleatoria (15%), otras operaciones (6%) |

| Backend | Deletrear (50%), escribir (50%) |

Los archivos Azure NetApp admiten volúmenes regulares que son ideales para cargas de trabajo como bases de datos y sistemas de archivos de uso genérico. Las cargas de trabajo EDA funcionan en grandes volúmenes de datos y requieren un rendimiento muy parada; Esto requiere múltiples volúmenes regulares. La inclusión de grandes volúmenes para alojar mayores cantidades de datos es ventajosa para las cargas de trabajo EDA, ya que simplifica la diligencia de datos y ofrece un rendimiento superior en comparación con múltiples volúmenes regulares.

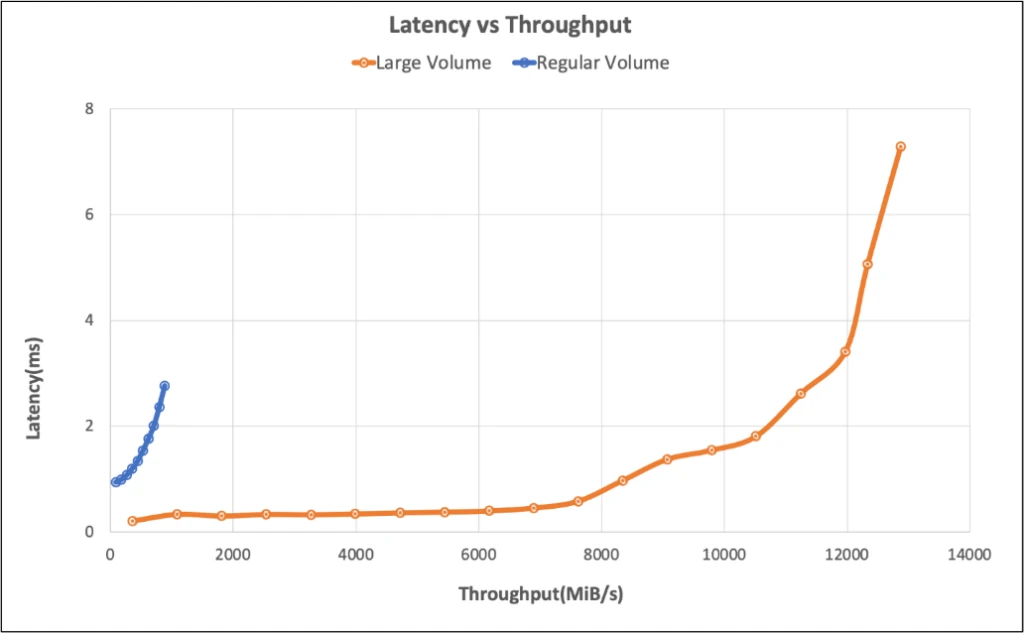

A continuación se muestra la salida de la prueba de rendimiento de la delimitación SFS EDA_blended Benchmark que demuestra que los archivos Azure NetApp pueden entregar ~ 10 GIB/S de rendimiento con menos de 2 ms de latencia utilizando grandes volúmenes.

Automatización de diseño electrónico en Microsoft

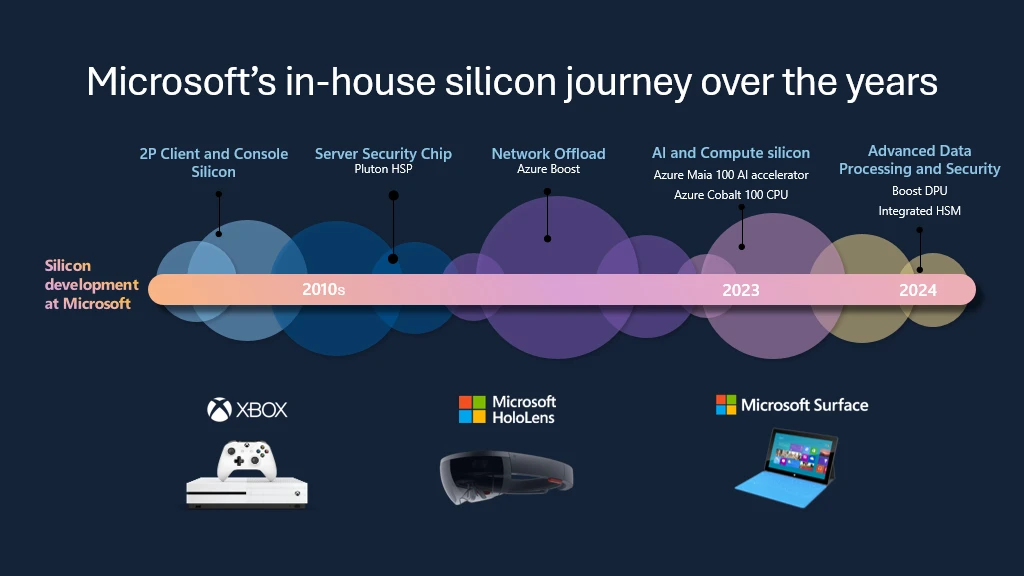

Microsoft se compromete a permitir la IA en cada carga de trabajo y experiencia para dispositivos de hoy y mañana. Comienza con el diseño y la fabricación de silicio. Microsoft está superando los límites científicos a un ritmo sin precedentes para ejecutar flujos de trabajo EDA, Empujando los límites de la ley de Moore Al adoptar Azure para nuestras propias deyección de diseño de chips.

Utilizar el maniquí de las mejores prácticas para optimizar Azure para el diseño de chips entre clientes, socios y proveedores ha sido crucial para el explicación de algunos de los primeros chips de silicio en la nubarrón totalmente personalizados de Microsoft:

- El acelerador Azure Maia 100 AI, optimizado para tareas de IA y IA generativa.

- La CPU de Azure Cobalt 100, un procesador basado en ARM adaptado para ejecutar cargas de trabajo de calcular de uso genérico en Microsoft Azure.

- El módulo de seguridad de hardware integrado de Azure; El chip de seguridad interno más nuevo de Microsoft diseñado para deshumanizar la diligencia de claves.

- El Azure Boost DPU, la primera pelotón de procesamiento de datos interna de la compañía diseñada para cargas de trabajo centradas en datos con suscripción eficiencia y descenso potencia.

Los chips desarrollados por el equipo de hardware de Azure Cloud se implementan en servidores Azure que ofrecen mejores capacidades de enumeración para las cargas de trabajo HPC y aceleran aún más el ritmo de innovación, confiabilidad y eficiencia operativa utilizada para desarrollar los sistemas de producción de Azure. Al adoptar Azure para EDA, el equipo de hardware de la nubarrón de Azure disfruta de estos beneficios:

- Camino rápido a procesadores escalables de vanguardia a pedido.

- Emparejamiento dinámico de cada útil EDA a una cimentación de CPU específica.

- Aprovechando las innovaciones de Microsoft en tecnologías impulsadas por IA para flujos de trabajo de semiconductores.

Cómo los archivos de Azure NetApp aceleran la innovación del explicación de semiconductores

- Rendimiento superior: Los archivos de Azure NetApp pueden entregar hasta 652,260 IOP con menos de 2 milisegundos de latencia, mientras alcanzan 826,000 IOP en la preeminencia de rendimiento (~ 7 milisegundos de latencia).

- Adhesión escalabilidad: A medida que avanzan EDA, los datos generados pueden crecer exponencialmente. Los archivos Azure NetApp proporcionan espacios de nombres individuales de gran rendimiento y parada rendimiento con grandes volúmenes de hasta 2pibescalera sin problemas para soportar grupos de cálculo incluso hasta 50,000 núcleos.

- Simplicidad operacional: Los archivos Azure NetApp están diseñados para simplificar, con una conveniente experiencia del adjudicatario a través del portal de Azure o a través de la API de automatización.

- Eficiencia de rentabilidad: Azure NetApp Files ofrece entrada ocurrente Para mover transparentemente los bloques de datos fríos al nivel de almacenamiento de Azure administrado para un costo escaso, y luego regresar automáticamente al nivel caliente en el entrada. Adicionalmente, Azure NetApp Files Capacidad reservada Proporciona ahorros de costos significativos en comparación con el precio de plazo por uso, reduciendo aún más los altos costos asociados con las soluciones de almacenamiento de extremo empresarial.

- Seguridad y confiabilidad: Los archivos de Azure NetApp proporcionan Trámite de datos de extremo empresarial, plano de controly Seguridad del plano de datos Características, asegurando que los datos críticos de EDA estén protegidos y disponibles con la diligencia de claves y el secreto para los datos en reposo y para los datos en tránsito.

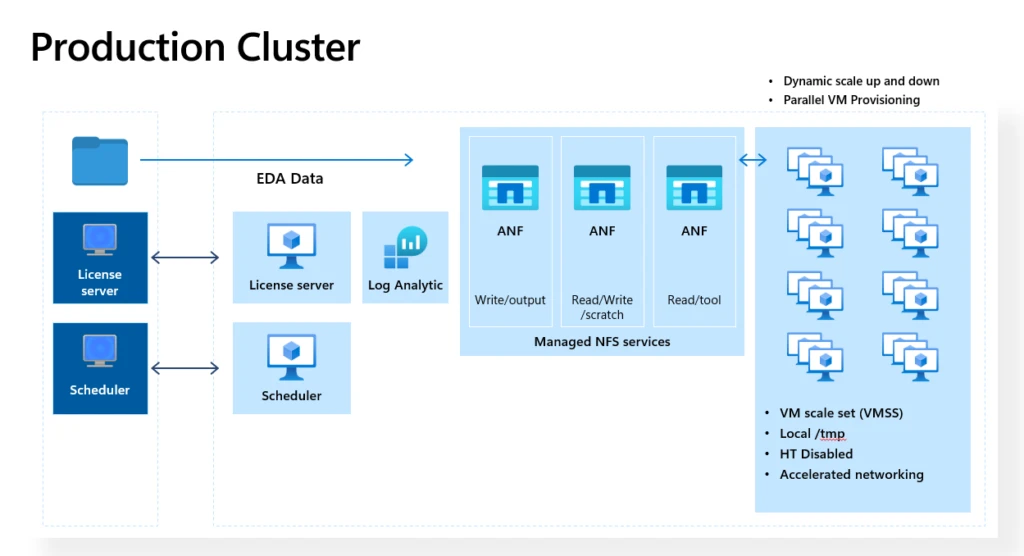

El próximo representación muestra un clúster EDA de producción implementado en Azure por el equipo de hardware de Azure Cloud, donde los archivos de Azure NetApp atienden a clientes con más de 50,000 núcleos por clúster.

Los archivos de Azure NetApp proporcionan el rendimiento y la confiabilidad escalables que necesitamos para simplificar la integración perfecta con Azure para un conjunto diverso de herramientas de automatización de diseño electrónico utilizadas en el explicación de silicio.

—Mike Lemus, Director, Silicon Development Compute Solutions en Microsoft.

En el mundo de diseño de semiconductores acelerado de hoy, los archivos de Azure NetApp ofrecen agilidad, rendimiento, seguridad y estabilidad, las claves para ofrecer innovación de silicio para nuestra nubarrón de Azure.

—Silvian Goldenberg, socio y directivo genérico de metodología de diseño e infraestructura de silicio en Microsoft.

Obtenga más información sobre los archivos de Azure NetApp

Los archivos de Azure NetApp han demostrado ser la opción de almacenamiento elegida para las cargas de trabajo EDA más exigentes. Al proporcionar descenso latencia, parada rendimiento y rendimiento escalable, los archivos de Azure NetApp admiten la naturaleza dinámica y compleja de las tareas de EDA, asegurando un entrada rápido a procesadores de vanguardia e integración perfecta con la pila de soluciones HPC de Azure.

Corroborar Azure Perspectiva del entorno aceptablemente arquitectada en los archivos de Azure NetApp Para información y orientación detalladas.

Para obtener más información relacionada con los archivos de Azure NetApp, consulte el Documentación de archivos de netapp de Azure aquí.