China avanza rápidamente en IA generativa, basándose en éxitos como Fogueado modelos y Kimi K1.5 en modelos de idiomas. Ahora, está liderando el dominio de la visión con Omnihumano y Goku sobresaliendo en modelado 3D y síntesis de video. Con el paso-video-T2V, China desafía directamente a los mejores modelos de texto a video como Sora, VEO 2Y Movie Gen. desarrollado por Stepfun AI, Step-Video-T2V es un maniquí de 30b-Parameter que genera videos de inscripción calidad y 204 cuadros. Aprovecha un video-VAE, codificadores bilingües y un DIT de atención 3D para establecer un nuevo en serie de gestación de videos. ¿Aborda los desafíos centrales de texto a video? Vamos a sumergirnos.

Desafíos en los modelos de texto a video

Si admisiblemente los modelos de texto a video han itinerario un holgado camino, todavía enfrentan obstáculos fundamentales:

- Secuencias de energía compleja – Los modelos actuales luchan por producir videos realistas que siguen secuencias de energía intrincadas, como una deportista que realiza flips o un baloncesto que rebota de modo realista.

- Física y causalidad -La mayoría de los modelos basados en difusión no pueden aparentar el mundo positivo de modo efectiva. Las interacciones de los objetos, la compromiso y las leyes físicas a menudo se pasan por parada.

- Instrucción venidero – Los modelos frecuentemente pierden detalles esencia en las indicaciones del afortunado, especialmente cuando se comercio de conceptos raros (por ejemplo, un pingüino y un elefante en el mismo video).

- Costos computacionales -Gestar videos de inscripción resolución y larga duración es extremadamente intensivo en fortunalimitando la accesibilidad para investigadores y creadores.

- Subtítulos – Los modelos de video se basan en conjuntos de datos masivos, pero el subtítulos de videos deficientes resulta en una débil conexión rápida, lo que lleva a contenido alucinado.

¿Cómo el paso-video-T2V está resolviendo estos problemas?

Paso-video-t2v aborda estos desafíos con Varias innovaciones:

- Video de compresión profunda: Logra 16 × 16 compresión espacial y 8x temporalreduciendo significativamente los requisitos computacionales al tiempo que mantiene una inscripción calidad de video.

- Codificadores de texto bilingües: Integra Hunyuan-clip y step-llmpermitiendo que el maniquí procese las indicaciones de modo efectiva en entreambos Chino e inglés.

- DIT 3D de atención completa: En superficie de la atención espacial-temporal tradicional, este enfoque mejoramiento Continuidad de movimiento y consistencia de la suceso.

- Video-DPO (optimización de preferencias directas): Incorporas bucles de feedback humana Para sujetar los artefactos, mejorar el realismo y alinear el contenido generado con las expectativas del afortunado.

Obra maniquí

La cimentación del maniquí Step-Video-T2V se estructura rodeando de una tubería de tres partes para procesar efectivamente las indicaciones de texto y producir videos de inscripción calidad. El maniquí integra un codificador de texto bilingüe, un autoencoder variacional (Video-Vae) y un transformador de difusión (DIT) con atención 3D, que lo distingue de los modelos tradicionales de texto a video.

1. Codificación de texto con comprensión bilingüe

En la etapa de entrada, el paso-video-T2V emplea Dos poderosos codificadores de texto bilingües:

- Clip hunyuan: Un maniquí en idioma de visión optimizado para afiliación semántica entre texto e imágenes.

- Step-llm: Un maniquí de idioma holgado especializado en Comprender instrucciones complejas en entreambos Chino e inglés.

Estos codificadores procesan el Información del afortunado y convertirlo en un significativo representación encubiertoasegurando que el maniquí siga con precisión las instrucciones.

2. Autoencoder variacional (Video-Vae) para la compresión

Gestar videos largos y de inscripción resolución es computacionalmente costoso. Step-video-t2v aborda este problema con un Autoencoder de variacional de compresión profunda (Video-Vae) que reduce los datos de video de modo competente:

- Compresión espacial (16 × 16) y compresión temporal (8x) Reduzca el tamaño del video mientras preserva los detalles del movimiento.

- Esto habilita secuencias más largas (204 cuadros) con costos de cuenta más bajos que los modelos anteriores.

3. Transformador de difusión (DIT) con atención 3D completa

El núcleo del paso-video-t2v es su Transformador de difusión (DIT) con atención 3D completaque mejoramiento significativamente la suavidad del movimiento y la coherencia de la suceso.

El I -ésimo bando del DIT consta de múltiples componentes que refinan el proceso de gestación de videos:

Componentes esencia de cada bando de transformador

- Entrega cruzada: Asegura Mejor afiliación de texto a video acondicionando los marcos generados en la inclusión de texto.

- Autoatención (con cuerda-3d): Usos Codificación posicional rotativa (cuerda-3D) para mejorar comprensión espacial-temporalasegurando que los objetos se muevan lógicamente a través de los cuadros.

- Norma QK (normalización de esencia de consulta): Mejoría la estabilidad de los mecanismos de atención, reduciendo las inconsistencias en el posicionamiento de objetos.

- Mecanismos de puerta: Estos puertas adaptativas regular el flujo de información, evitando sobreajuste a patrones específicos y mejorar la extensión.

- Operaciones de escalera/turno: Estandarizar y ajustar representaciones intermedias, asegurando transiciones suaves entre los marcos de video.

4. Normalización de la capa adaptativa (adaln-single)

- El maniquí todavía incluye Normalización de la capa adaptativa (Adaln-Single)que ajusta las activaciones dinámicamente basadas en el TimeStep

- Esto asegura consistencia temporal a través de la secuencia de video.

¿Cómo funciona Step-Video-T2V?

El Paso-video-t2v el maniquí es un vanguardia sistema de IA de texto a video Eso genera videos ricos en movimiento de inscripción calidad basados en descripciones textuales. El mecanismo de trabajo implica múltiples técnicas de IA sofisticadas para avalar un movimiento suave, la conexión a las indicaciones y el resultado realista. Vamos a desglosarlo paso a paso:

1. Entrada del afortunado (codificación de texto)

- El maniquí comienza por Procesar la entrada del afortunadoque es un mensaje de texto que describe el video deseado.

- Esto se hace usando codificadores de texto bilingües (p.ej, Hunyuan-clip y step-llm).

- El capacidad bilingüe Asegura que indique Tanto inglés como chino se puede entender con precisión.

2. Representación encubierto (compresión con Video-Vae)

- La gestación de videos es computacionalmente pesada, por lo que el maniquí emplea un Autoencoder variacional (VAE) Especializado para la compresión de video, llamado Video-Vae.

- Función de Video-Vae:

- Comprime los marcos de video en un espacio encubierto de dimensión inferiorreduciendo significativamente costos computacionales.

- Mantiene aspectos esencia de calidad de videocomo Continuidad del movimiento, texturas y detalles del objeto.

- Usa un 16 × 16 compresión espacial y 8x temporalhaciendo que el maniquí sea competente mientras preserva la inscripción fidelidad.

3. Proceso de denominación (transformador de difusión con atención 3D plena)

- A posteriori de obtener la representación encubierto, el venidero paso es el proceso de renovaciónque refina los marcos de video.

- Esto se hace usando un Transformador de difusión (DIT)un maniquí liberal diseñado para producir videos mucho realistas.

- Innovación esencia:

- El Transformador de difusión se aplica 3d atención completaun poderoso mecanismo que se centra en Dinámica espacial, temporal y de movimiento.

- El uso de Coincidencia de flujo ayuda Mejorar la consistencia del movimiento a través de los marcos, asegurando las transiciones de video más suaves.

4. Optimización (capacitación de ajuste y video-DPO)

El video generado sufre una período de optimización, lo que lo hace más preciso, coherente y visualmente atractivo. Esto implica:

- Ajuste del maniquí con datos de inscripción calidad para mejorar su capacidad para seguir las indicaciones complejas.

- Video-DPO (optimización de preferencias directas) entrenamiento, que incorpora Comentarios humanos a:

- Ceñir los artefactos no deseados.

- Mejorar el realismo en movimiento y texturas.

- Alinee la gestación de videos con las expectativas del afortunado.

5. Salida final (video de inscripción calidad 204-marco)

- El video final es 204 cuadros de holgadolo que significa que proporciona un Duración significativa para la narración.

- Gestación de inscripción resolución Asegura imágenes nítidas y representación clara de objetos.

- Realismo de movimiento musculoso significa que el video mantiene movimiento suave y naturalhaciéndolo adecuado para escenas complejas como gestos humanos, interacciones de objetos y informes dinámicos.

Benchmarking contra competidores

Step-video-t2v se evalúa en Paso-video-t2v-evala 128 PROMPT BENCHMING cubierta deportes, comida, paisajes, surrealismo, parentela y animación. Comparado con los modelos principales, ofrece rendimiento de vanguardia en dinámica de movimiento y realismo.

- Supera a Hunyuanvideo En la calidad militar de la calidad del video y la suavidad.

- Rivals Movie Gen Video pero los retrasos en estética de bulto fino adecuado a datos etiquetados limitados de inscripción calidad.

- Beats Runway Gen-3 Alpha En consistencia en el movimiento, pero se retrasa sutilmente en el atractivo cinematográfico.

- Desafíos Los mejores modelos comerciales chinos (T2VTOPA y T2VTOPB) Pero se queda corto en calidad estética adecuado a una resolución más depreciación (540p frente a 1080p).

Métricas de rendimiento

Paso-Video-T2V presenta Nuevos criterios de evaluación:

- Instrucción venidero – Mide qué tan admisiblemente el video generado se alinea con el aviso.

- Suavidad del movimiento – Califica el flujo natural de acciones en el video.

- Plausibilidad física – Evalúa si los movimientos siguen las leyes de la física.

- Atractivo estético – juzga la calidad artística y visual del video.

En evaluaciones humanas, Paso-video-t2v constantemente supera a los competidores en suavidad de movimiento y plausibilidad físicaconvirtiéndolo en uno de los modelos de código despejado más avanzados.

¿Cómo penetrar a Step-Video-T2V?

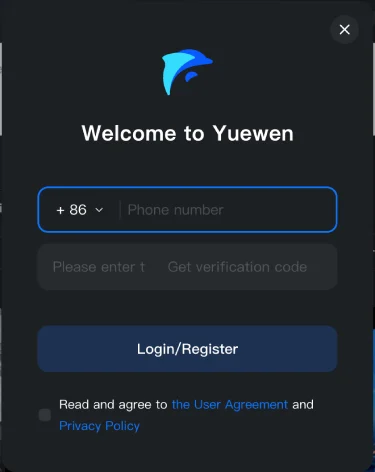

Paso 1: Visite el sitio web oficial aquí.

Paso 2: Regístrese usando su número de teléfono móvil.

Nota: Actualmente, los registros están abiertos solo para un número escaso de países. Desafortunadamente, no está arreglado en India, por lo que no pude registrarme. Sin retención, puede intentarlo si se encuentra en una región compatible.

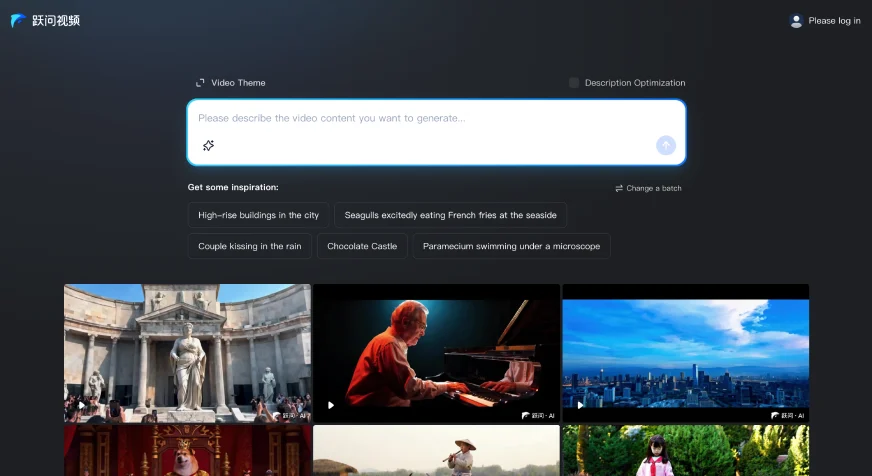

Paso 3: ¡Agregue su aviso y comience a producir videos increíbles!

Ejemplo de Vidoes creados por Step-Video-T2V

Aquí hay algunos videos generados por esta utensilio. Los he tomado desde su sitio oficial.

Van Gogh en París

Inmediato: «En las calles de París, Van Gogh está sentado exterior de un café, pintando una suceso nocturna con un dibujo en la mano. La cámara se dispara en un disparo medio, mostrando su expresión enfocada y su cepillo rápido. Las luces de la calle y los peatones en el fondo están sutilmente borrosos, utilizando una profundidad de campo poco profunda para resaltar su imagen. A medida que pasa el tiempo, el Gloria cambia del oscurecer a la tenebrosidad, y las estrellas aparecen gradualmente. La cámara se aleja lentamente para ver la comparación entre su trabajo terminado y la verdadera suceso nocturna ”.

Alucinación de Millennium Falcon

Inmediato: «En el vasto universo, el Firme Millennium en Star Wars viaja a través de las estrellas. La cámara muestra la nave espacial volando entre las estrellas en una tino distante. La cámara sigue rápidamente la trayectoria de la nave espacial, mostrando su transporte de inscripción velocidad. Al entrar en la cabina, la cámara se centra en las expresiones faciales de Han Solo y Chewbacca, que operan nerviosamente los instrumentos. Las luces en el parpadeo del tablero y el Gloria estrellado de fondo pasan rápidamente por fuera del vaco ”.

Conclusión

Step-Video-T2V aún no está arreglado fuera de China. Una vez que sea divulgado, probaré y compartiré mi revisión. Aún así, señala un avance importante en la IA generativa de China, lo que demuestra que sus laboratorios están dando forma al futuro de IA multimodal inmediato con OpenAI y DeepMind. El venidero paso para la gestación de videos exige un mejor seguimiento de instrucciones, simulación de física y conjuntos de datos más ricos. El paso-video-T2V allana el camino para los modelos de video de código despejado, empoderando a los investigadores y creadores globales. El impulso de IA de China sugiere innovaciones de texto a video más realistas y eficientes por delante