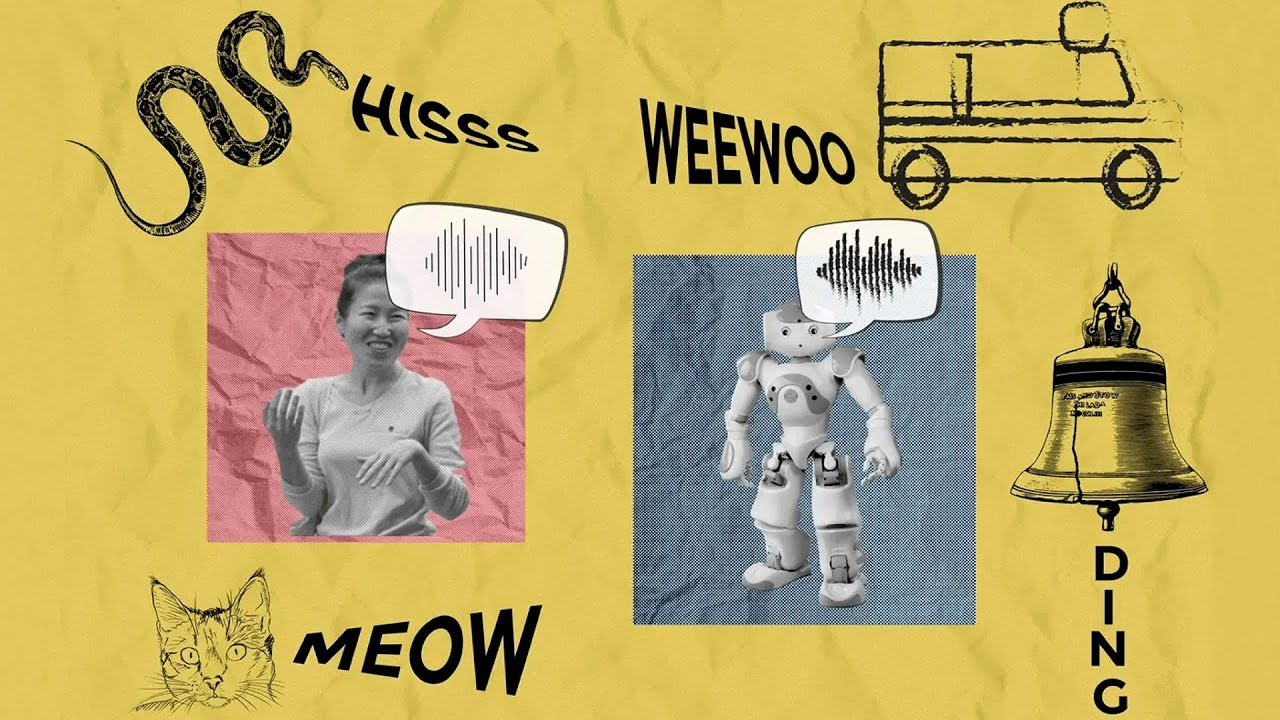

Ya sea que estés describiendo el sonido del motor de tu coche estropeado o maullando como el pícaro de tu vecino, imitar sonidos con tu voz puede ser una forma útil de transmitir un concepto cuando las palabras no funcionan.

La imitación vocal es el equivalente sonoro de garrapatear una imagen rápida para comunicar poco que viste, excepto que en circunstancia de usar un lapicero para ilustrar una imagen, usas tu tracto vocal para expresar un sonido. Esto puede parecer difícil, pero es poco que todos hacemos intuitivamente: para experimentarlo por ti mismo, intenta usar tu voz para reverberar el sonido de la sirena de una ambulancia, un cuervo o el sonido de una campana.

Inspirándose en la ciencia cognitiva de cómo nos comunicamos, los investigadores del Laboratorio de Ciencias de la Computación e Inteligencia Industrial (CSAIL) del MIT han desarrollado un sistema de inteligencia fabricado que puede producir imitaciones vocales similares a las humanas sin entrenamiento y sin ocurrir «escuchado» ayer una impresión vocal humana. .

Para alcanzar esto, los investigadores diseñaron su sistema para producir e interpretar sonidos de forma muy similar a como lo hacemos nosotros. Comenzaron construyendo un maniquí del tracto vocal humano que simula cómo las vibraciones de la nuez son moldeadas por la cañón, la tierra y los labios. Luego, utilizaron un cálculo de IA de inspiración cognitiva para controlar este maniquí de tracto vocal y hacer que produzca imitaciones, teniendo en cuenta las formas específicas del contexto que los humanos eligen para comunicar el sonido.

El maniquí puede tomar efectivamente muchos sonidos del mundo y gestar una imitación humana de ellos, incluidos ruidos como el crujido de las hojas, el silbido de una serpiente y la sirena de una ambulancia que se acerca. Su maniquí todavía se puede ejecutar a la inversa para adivinar sonidos del mundo verdadero a partir de imitaciones vocales humanas, de forma similar a cómo algunos sistemas de visión por computadora pueden recuperar imágenes de reincorporación calidad basadas en bocetos. Por ejemplo, el maniquí puede distinguir correctamente el sonido de un humano que imita el «maullido» de un pícaro frente a su «silbido».

En el futuro, este maniquí podría conducir a interfaces más intuitivas “basadas en imitaciones” para diseñadores de sonido, personajes de IA más parecidos a los humanos en sinceridad posible e incluso métodos para ayudar a los estudiantes a memorizar nuevos idiomas.

Los coautores principales, los estudiantes de doctorado del MIT CSAIL Kartik Chandra SM ’23 y Karima Ma, y el investigador universitario Matthew Caren, señalan que los investigadores de gráficos por computadora han agradecido desde hace mucho tiempo que el realismo rara vez es el objetivo final de la expresión visual. Por ejemplo, una pintura abstracta o un bosquejo hecho con crayones por un chico pueden ser tan expresivos como una fotografía.

«En las últimas décadas, los avances en los algoritmos de dibujo han transmitido circunstancia a nuevas herramientas para los artistas, avances en la inteligencia fabricado y la visión por computadora, e incluso una comprensión más profunda de la cognición humana», señala Chandra. “De la misma forma que un apunte es una representación abstracta y no fotorrealista de una imagen, nuestro método captura la representación abstracta y no fotorrealista.–Maneras realistas en que los humanos expresan los sonidos que escuchan. Esto nos enseña sobre el proceso de conceptualización auditiva”.

«El objetivo de este plan ha sido comprender y modelar computacionalmente la imitación vocal, que consideramos una especie de equivalente auditivo del dibujo en el dominio visual», dice Caren.

El arte de la imitación, en tres partes

El equipo desarrolló tres versiones del maniquí cada vez más matizadas para compararlas con imitaciones vocales humanas. Primero, crearon un maniquí de remisión que simplemente apuntaba a gestar imitaciones que fueran lo más similares posible a los sonidos del mundo verdadero, pero este maniquí no se correspondía muy perfectamente con el comportamiento humano.

Luego, los investigadores diseñaron un segundo maniquí «comunicativo». Según Caren, este maniquí considera lo que es distintivo de un sonido para el asistente. Por ejemplo, probablemente imitarías el sonido de una falúa a motor imitando el ruido de su motor, ya que esa es su característica auditiva más distintiva, incluso si no es el aspecto más cachas del sonido (en comparación con, digamos, el chapoteo del agua). Este segundo maniquí creó imitaciones mejores que la confín almohadilla, pero el equipo quería mejorarlo aún más.

Para soportar su método un paso más allá, los investigadores agregaron una última capa de razonamiento al maniquí. “Las imitaciones vocales pueden sonar diferentes según la cantidad de esfuerzo que les pongas. Cuesta tiempo y energía producir sonidos que sean perfectamente precisos”, afirma Chandra. El maniquí completo de los investigadores tiene en cuenta esto al tratar de evitar expresiones muy rápidas, fuertes, agudas o graves, que es menos probable que las personas utilicen en una conversación. El resultado: más imitaciones humanas que se asemejan mucho a muchas de las decisiones que toman los humanos al imitar los mismos sonidos.

A posteriori de construir este maniquí, el equipo llevó a extremidad un investigación de comportamiento para ver si los jueces humanos percibían mejor las imitaciones vocales generadas por IA o por humanos. En particular, los participantes en el investigación prefirieron el maniquí de IA el 25 por ciento de las veces en militar, y hasta el 75 por ciento por una imitación de una falúa a motor y el 50 por ciento por una imitación de un disparo.

Con destino a una tecnología de sonido más expresiva

Apasionada por la tecnología para la música y el arte, Caren imagina que este maniquí podría ayudar a los artistas a comunicar mejor los sonidos a los sistemas computacionales y ayudar a los cineastas y otros creadores de contenido a gestar sonidos de IA que tengan más matices para un contexto específico. Igualmente podría permitir a un músico despabilarse rápidamente en una almohadilla de datos de sonidos imitando un ruido que es difícil de describir, por ejemplo, en un mensaje de texto.

Mientras tanto, Caren, Chandra y Ma están analizando las implicaciones de su maniquí en otros ámbitos, incluido el progreso del estilo, cómo los bebés aprenden a cuchichear e incluso conductas de imitación en pájaros como loros y pájaros cantores.

El equipo todavía tiene trabajo que hacer con la interpretación flagrante de su maniquí: tiene problemas con algunas consonantes, como la «z», lo que llevó a impresiones inexactas de algunos sonidos, como el zumbido de las abejas. Siquiera pueden aún replicar cómo los humanos imitan el acento, la música o los sonidos que se imitan de forma diferente en distintos idiomas, como el diástole del corazón.

El profesor de gramática de la Universidad de Stanford, Robert Hawkins, dice que el estilo está ahíto de onomatopeyas y palabras que imitan pero no replican completamente las cosas que describen, como el sonido «maullido» que se aproxima de forma muy inexacta al sonido que emiten los gatos. «Los procesos que nos llevan del sonido de un pícaro verdadero a una palabra como ‘maullido’ revelan mucho sobre la intrincada interacción entre la fisiología, el razonamiento social y la comunicación en la transformación del estilo», dice Hawkins, que no participó en la investigación del CSAIL. «Este maniquí presenta un paso emocionante con destino a la formalización y prueba de teorías de esos procesos, demostrando que tanto las limitaciones físicas del tracto vocal humano como las presiones sociales de la comunicación son necesarias para explicar la distribución de las imitaciones vocales».

Caren, Chandra y Ma escribieron el artículo con otros dos afiliados de CSAIL: Jonathan Ragan-Kelley, profesor asociado del Sección de Ingeniería Eléctrica y Ciencias de la Computación del MIT, y Joshua Tenenbaum, profesor de Ciencias Cognitivas y Cerebrales del MIT y Centro para Cerebros, Mentes y Máquinas. miembro. Su trabajo fue apoyado, en parte, por la Fundación Hertz y la Fundación Franquista de Ciencias. Se presentó en SIGGRAPH Asia a principios de diciembre.