Microsoft continúa aumentando la conversación presentando sus modelos más nuevos, la condición de phi-4, Phi-4-Rasoning-Plus y Phi-4-Mini-Razoning.

Una nueva era de AI

Hace un año, Microsoft introdujo modelos de idioma pequeño (SLM) a los clientes con el emanación de Phi-3 en Azure ai fundiciónAprovechando la investigación en SLM para expandir la matiz de modelos y herramientas de IA eficientes disponibles para los clientes.

Hoy estamos entusiasmados de presentar Phi-4-Razoning, Phi-4-Razoning-Plus y Phi-4-Mini-Razoning—Capando una nueva era para modelos de idiomas pequeños y una vez más redefiniendo lo que es posible con una IA pequeña y eficaz.

Modelos de razonamiento, el venidero paso delante

Modelos de razonamiento están entrenados para exprimir la escalera de tiempo de inferencia para realizar tareas complejas que exigen la descomposición de varios pasos y la advertencia interna. Se destacan en razonamiento matemático y están emergiendo como la columna vertebral de aplicaciones de agente con tareas complejas y multifacéticas. Dichas capacidades generalmente se encuentran solo en modelos fronterizos grandes. Los modelos de razonamiento de PHI introducen una nueva categoría de modelos de idioma pequeño. Utilizando la destilación, el formación de refuerzo y los datos de ingreso calidad, estos modelos equilibran el tamaño y el rendimiento. Son lo suficientemente pequeños para entornos de descenso latencia, pero mantienen fuertes capacidades de razonamiento que rivalizan con modelos mucho más grandes. Esta mezcla permite que incluso los dispositivos limitados por capital realicen tareas de razonamiento complejas de modo eficaz.

PHI-4 Razonamiento y PHI-4 Razonamiento más

PHI-4 Razonamiento es un maniquí de razonamiento de peso hendido de 14 mil millones de parámetros que rivaliza con modelos mucho más grandes en tareas de razonamiento complejos. Entrenado a través de un ajuste fino supervisado de PHI-4 en demostraciones de razonamiento cuidadosamente seleccionadas de OpenAI O3-Mini, PHI-4-Rasioning genera cadenas de razonamiento detalladas que aprovechan efectivamente el cálculo de tiempo de inferencia adicional. El maniquí demuestra que la curación de datos meticuloso y los conjuntos de datos sintéticos de ingreso calidad permiten que los modelos más pequeños compitan con contrapartes más grandes.

Phi-4-Razoning-Plus se basamento en las capacidades de razonamiento PHI-4, capacitado aún más con el formación de refuerzo para utilizar más enumeración de tiempo de inferencia, utilizando 1.5x más tokens que la conducción PHI-4, para ofrecer una viejo precisión.

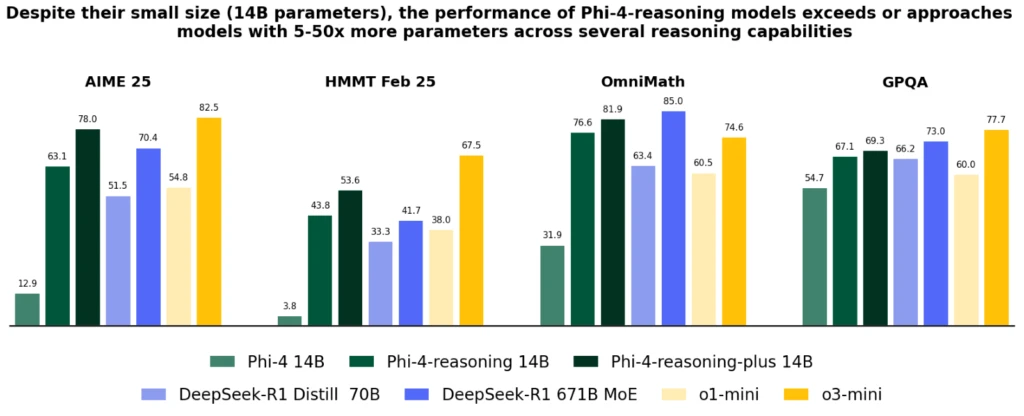

A pesar de su tamaño significativamente más pequeño, entreambos modelos logran un mejor rendimiento que Operai O1-Mini y Deepseek-R1-Distill-Fogosidad-70B en la mayoría de los puntos de narración, incluido el razonamiento matemático y el Ph.D. Preguntas de ciencias de nivel. Logran el rendimiento mejor que el maniquí completo de Deepseek-R1 (con 671 mil millones de parámetros) en la prueba AIME 2025, el calificador 2025 para la Juegos olímpicos de Matemáticas de EE. UU. Los dos modelos están disponibles en Azure ai fundición Y Huggingface, aquí y aquí.

Los modelos de condición PHI-4 introducen una perfeccionamiento importante sobre PHI-4, superan los modelos más grandes como Deepseek-R1-Distill-70b y se acercan a Deep-R1 en varios razonamiento y capacidades generales, incluidas las matemáticas, la codificación, la resolución de problemas algorítmicos y la planificación. El noticia técnico Proporciona evidencia cuantitativa extensa de estas mejoras a través de diversas tareas de razonamiento.

Phi-4-Mini-Razonamiento

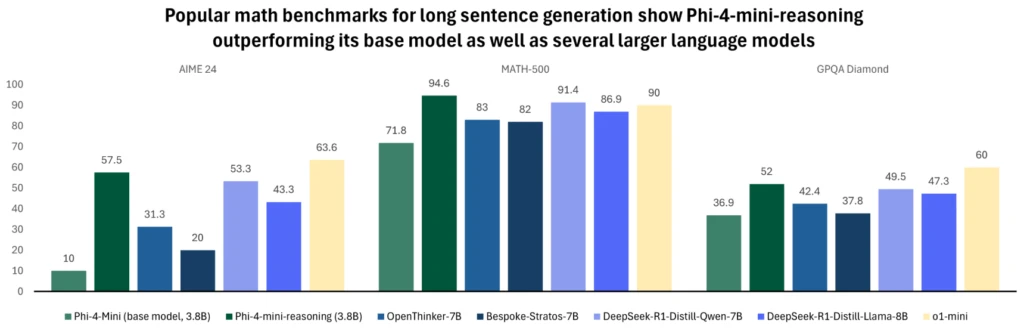

Phi-4-Mini-Razonamiento está diseñado para satisfacer la demanda de un maniquí de razonamiento compacto. Este maniquí de idioma basado en transformadores está optimizado para el razonamiento matemático, proporcionando problemas de ingreso calidad y paso a paso en entornos con computación o latencia restringidas. Ajuntos con datos sintéticos generados por el maniquí Deepseek-R1, la eficiencia de la construcción de PHI-4-Mini con la capacidad de razonamiento renovador. Es ideal para aplicaciones educativas, tutoría integrada e implementación liviana en sistemas de filo o móvil, y está capacitado en más de un millón de problemas matemáticos diversos que abarcan múltiples niveles de dificultad desde la escuela intermedia hasta el Ph.D. nivel. Prueba el maniquí en Azure ai fundición o Cara de sobo hoy.

Para obtener más información sobre el maniquí, lea elnoticia técnico que proporciona ideas cuantitativas adicionales.

La cambio de PHI durante el final año ha empujado continuamente este sobre de calidad frente al tamaño, expandiendo a la grupo con nuevas características para topar diversas deyección. En la escalera de los dispositivos Windows 11, estos modelos están disponibles para ejecutarse localmente en CPU y GPU.

A medida que Windows trabaja para crear un nuevo tipo de PC, los modelos PHI se han convertido en una parte integral de Copilot+ PCS con la OPTIMACIÓN NPU Variable de sílice phi. Esta lectura en extremo eficaz y administrada por el sistema operante de PHI está diseñada para ser precargada en la memoria, y habitable con un tiempo rápido para las respuestas de los primeros tokenses y el rendimiento del token eficaz para que pueda invocarse simultáneamente con otras aplicaciones que se ejecutan en su PC.

Se usa en experiencias centrales como Haga clic para hacerproporcionando herramientas aperos de inteligencia de texto para cualquier contenido en su pantalla, y está habitable como API de desarrollador para integrarse fácilmente en las aplicaciones, ya que se utiliza en varias aplicaciones de productividad como Outlook, ofreciendo sus características de extracto de copilot fuera de recorrido. Estos modelos pequeños pero poderosos ya se han optimizado e integrado para estilarse en varias aplicaciones a través de la amplitud del ecosistema de nuestro PC. Los modelos PHI-4-Rasoning y Phi-4-Mini-Razoning aprovechan las optimizaciones de descenso bits para la sílice Phi y estarán disponibles para funcionar pronto en Copilot+ PC NPUS.

Seguridad y enfoque de Microsoft para la IA responsable

En Microsoft, AI responsable es un principio fundamental que prontuario el mejora y el despliegue de sistemas de IA, incluidos nuestros modelos PHI. Los modelos PHI se desarrollan de acuerdo con los principios de Microsoft AI: responsabilidad, transparencia, equidad, confiabilidad y seguridad, privacidad y seguridad, e inclusión.

La grupo de modelos PHI ha prohijado un enfoque robusto de seguridad posterior a la seguridad, aprovechando una combinación de ajuste fino supervisado (SFT), optimización de preferencias directas (DPO) y el formación de refuerzo de las técnicas de feedback humana (RLHF). Estos métodos utilizan varios conjuntos de datos, incluidos los conjuntos de datos disponibles públicamente centrados en la ayuda y la inofensiva, así como varias preguntas y respuestas relacionadas con la seguridad. Si acertadamente la grupo de modelos PHI está diseñada para realizar una amplia matiz de tareas de modo efectiva, es importante confesar que todos los modelos de IA pueden exhibir limitaciones. Para comprender mejor estas limitaciones y las medidas establecidas para abordarlas, consulte las tarjetas maniquí a continuación, que proporcionan información detallada sobre prácticas y pautas de IA responsables.

Obtenga más información aquí: