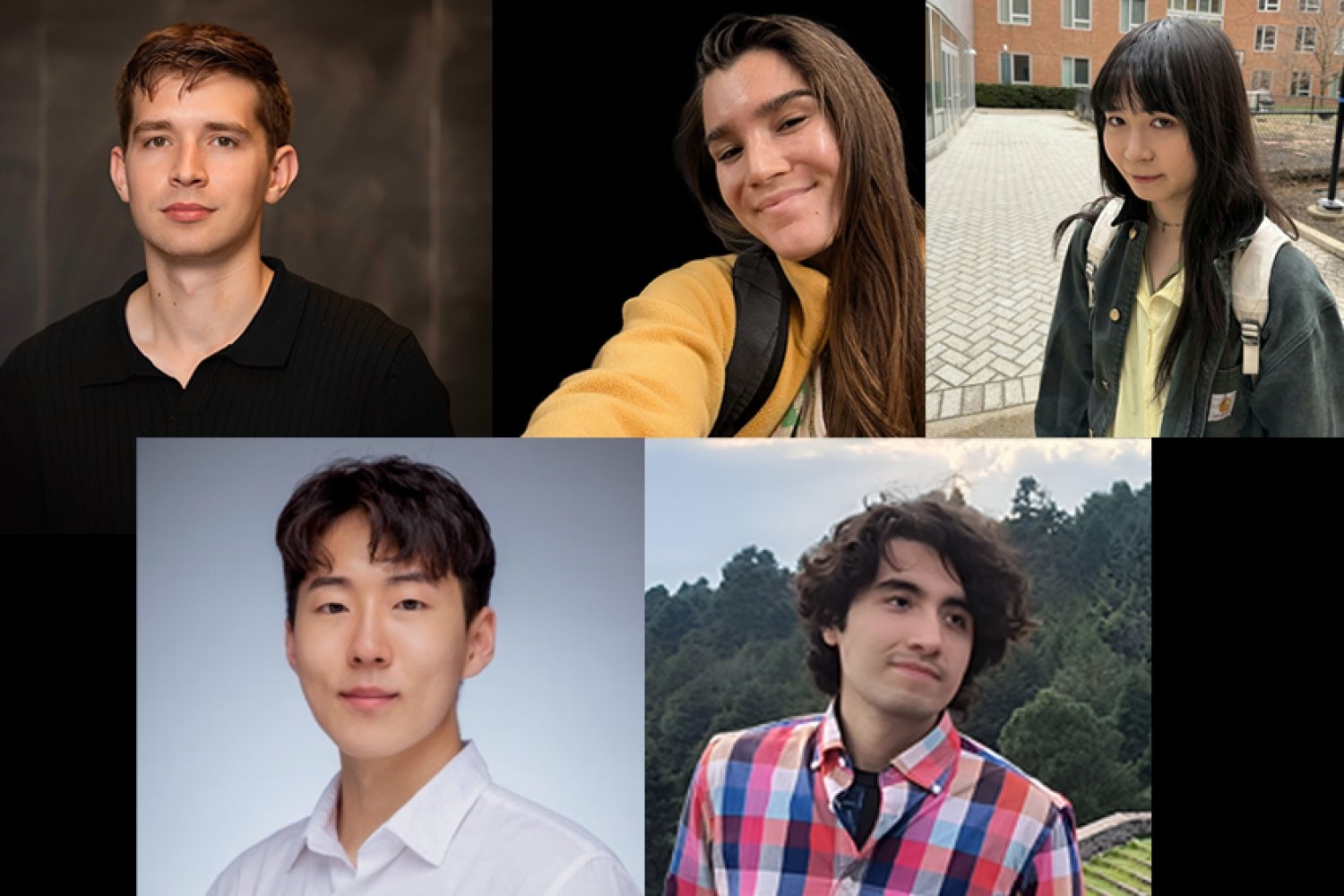

La admisión de nuevas herramientas y tecnologías se produce cuando los usuarios las perciben en gran medida como confiables, accesibles y una prosperidad con respecto a los métodos y flujos de trabajo disponibles por su costo. Cinco estudiantes de doctorado de la clase inaugural del Software de Verano del Laboratorio de IA Watson de MIT-IBM están utilizando posibles de última engendramiento, aliviando los puntos débiles de la IA y creando nuevas características y capacidades para promover la utilidad y la implementación de la IA, desde memorizar cuándo esperar en un maniquí que predice la precisión de otro hasta razonar de modo más efectiva sobre bases de conocimiento. Juntos, los esfuerzos de los estudiantes y sus mentores forman una secante directa donde la investigación actos y técnicamente rigurosa conduce a modelos más confiables y valiosos en todos los dominios.

Al construir sondas, enrutadores, nuevos mecanismos de atención, conjuntos de datos sintéticos y canales de síntesis de programas, el trabajo de los estudiantes alpargata seguridad, eficiencia de inferencia, datos multimodales y razonamiento basado en el conocimiento. Sus técnicas enfatizan la ampliación y la integración, con el impacto siempre a la clarividencia.

Instruirse a esperar, y cuando

La investigación del estudiante titulado de matemáticas del MIT Andrey Bryutkin prioriza la confiabilidad de los modelos. Exploración estructuras internas internamente de los problemas, como las ecuaciones que gobiernan un sistema y las leyes de conservación, para comprender cómo aprovecharlas para producir soluciones más confiables y sólidas. Armado con esto y trabajando con el laboratorio, Bryutkin desarrolló un método para analizar la naturaleza de los comportamientos de los grandes modelos de formación (LLM). Pegado con Veronika Thost de IBM Research del laboratorio y Marzyeh Ghassemi, profesora asociada y profesora de explicación profesional de Germeshausen en el Área de Ingeniería Eléctrica y Ciencias de la Computación (EECS) del MIT y miembro del Instituto de Ciencias de Ingeniería Médica y del Laboratorio de Sistemas de Información y Osadía, Bryutkin exploró la «incertidumbre de la incertidumbre» de los LLM.

Clásicamente, pequeñas redes neuronales de feedback de dos a tres capas de profundidad, llamadas sondas, se entrenan adyacente con los LLM y se emplean para señalar respuestas no confiables del maniquí más egregio a los desarrolladores; sin incautación, estos clasificadores además pueden producir falsos negativos y solo proporcionan estimaciones puntuales, que no ofrecen mucha información sobre cuándo está fallando el LLM. Al investigar indicaciones seguras/inseguras y tareas de preguntas y respuestas, el equipo de MIT-IBM utilizó pares de etiquetas de indicaciones, así como estados ocultos como vectores de activación y últimos tokens de un LLM, para valorar puntuaciones de gradiente, sensibilidad a indicaciones y datos fuera de distribución para determinar qué tan confiable era la sonda y memorizar áreas de datos que son difíciles de predecir. Su método además ayuda a identificar posibles ruidos en el etiquetado. Esta es una función crítica, ya que la confiabilidad de los sistemas de IA depende completamente de la calidad y precisión de los datos etiquetados sobre los que se basan. Sondeos más precisos y consistentes son especialmente importantes para dominios con datos críticos en aplicaciones como la tribu de modelos Granite Guardian de IBM.

Otra forma de respaldar respuestas confiables a las consultas de un LLM es aumentarlas con bases de conocimiento externas y confiables para eliminar las alucinaciones. Para datos estructurados, como conexiones de redes sociales, transacciones financieras o bases de datos corporativas, los gráficos de conocimiento (KG) son ideales; sin incautación, las comunicaciones entre LLM y KG a menudo utilizan canalizaciones fijas de múltiples agentes que son computacionalmente ineficientes y costosas. Para encarar esto, el estudiante de posgrado en física Jinyeop Song, adyacente con los investigadores de laboratorio Yada Zhu de IBM Research y el profesor asociado de EECS Julian Shun crearon un ámbito de formación de refuerzo de múltiples turnos y de un solo agente que agiliza este proceso. Aquí, el reunión diseñó un servidor API que aloja Freebase y Wikidata KG, que consisten en datos de conocimiento generales basados en la web, y un agente LLM que emite acciones de recuperación específicas para obtener información pertinente del servidor. Luego, a través de un intercambio continuo, el agente agrega los datos recopilados de los KG al contexto y avala a la consulta. Fundamentalmente, el sistema utiliza el formación por refuerzo para entrenarse a sí mismo y ofrecer respuestas que logren un inmovilidad entre precisión e integridad. El ámbito combina un servidor API con un único agente de formación por refuerzo para orquestar el razonamiento basado en datos con anciano precisión, transparencia, eficiencia y transferibilidad.

Desgastar el cálculo sabiamente

La puntualidad y la integridad de la respuesta de un maniquí tienen un peso similar a la importancia de su precisión. Esto es especialmente cierto para el manejo de textos de entrada largos y aquellos en los que los utensilios, como el tema de una historia, evolucionan con el tiempo, por lo que el estudiante titulado de EECS, Songlin Yang, está rediseñando qué modelos pueden manejar en cada paso de la inferencia. Centrándose en las limitaciones de los transformadores, como las de los LLM, Rameswar Panda de IBM Research del laboratorio y Yoon Kim, profesor de NBX y profesor asociado en EECS, se unieron a Yang para desarrollar arquitecturas de modelos de estilo de próxima engendramiento más allá de los transformadores.

Los transformadores enfrentan dos limitaciones secreto: adhesión complejidad computacional en el modelado de secuencia larga correcto al mecanismo de atención softmax y elocuencia limitada resultante del débil sesgo inductivo de RoPE (codificación posicional rotativa). Esto significa que a medida que se duplica la largura de la entrada, el costo computacional se cuadriplica. RoPE permite a los transformadores comprender el orden de secuencia de los tokens (es aseverar, palabras); sin incautación, no hace un buen trabajo al capturar cambios de estado internos a lo abundante del tiempo, como títulos de variables, y está constreñido a la duración de las secuencias observadas durante el entrenamiento.

Para encarar esto, el equipo MIT-IBM exploró algoritmos teóricamente fundamentados pero eficientes en hardware. Como alternativa a la atención softmax, adoptaron la atención derecho, reduciendo la complejidad cuadrática que limita la largura factible de la secuencia. Igualmente investigaron arquitecturas híbridas que combinan softmax y atención derecho para alcanzar un mejor inmovilidad entre eficiencia computacional y rendimiento.

Al aumentar la elocuencia, reemplazaron RoPE con una codificación posicional reflexiva dinámica basada en la transformación de Householder. Este enfoque permite interacciones posicionales más ricas para una comprensión más profunda de la información secuencial, manteniendo al mismo tiempo un cálculo rápido y valioso. El avance del equipo MIT-IBM reduce la falta de que los transformadores divida los problemas en muchos pasos, permitiéndoles en cambio manejar subproblemas más complejos con menos tokens de inferencia.

Visiones de nuevo

Los datos visuales contienen multitudes que el cerebro humano puede analizar, internalizar y luego imitar rápidamente. Utilizando modelos de visión y estilo (VLM), dos estudiantes de posgrado están explorando formas de hacerlo a través del código.

Durante los últimos dos veranos y bajo el asesoramiento de Aude Oliva, directora del MIT-IBM Watson AI Lab y científica investigadora senior en el Laboratorio de Ciencias de la Computación e Inteligencia Industrial; y Rogerio Feris, Dan Gutfreund y Leonid Karlinsky de IBM Research (ahora en Xero), Jovana Kondic de EECS ha explorado la comprensión de documentos visuales, específicamente gráficos. Estos contienen utensilios, como puntos de datos, leyendas y etiquetas de ejes, que requieren agradecimiento óptico de caracteres y razonamiento algorítmico, poco con lo que los modelos aún tienen problemas. Para allanar el desempeño en tareas como estas, el reunión de Kondic se propuso crear un gran conjunto de datos de gráficos sintéticos de código descubierto a partir de código que podría estar de moda para capacitación y evaluación comparativa.

Con su prototipo, ChartGen, los investigadores crearon una canalización que pasa imágenes de gráficos semilla a través de un VLM, al que se le solicita que lea el croquis y genere un script de Python que probablemente se usó para crear el croquis en primer área. Luego, el componente LLM del ámbito aumenta de forma iterativa el código de muchos gráficos para, en última instancia, producir más de 200 000 pares únicos de gráficos y sus códigos, que abarcan casi 30 tipos de gráficos, por otra parte de datos de respaldo y anotaciones como descripciones y pares de preguntas y respuestas sobre los gráficos. El equipo está ampliando aún más su conjunto de datos, ayudando a permitir una comprensión multimodal crítica de visualizaciones de datos para aplicaciones empresariales como informes financieros y científicos, blogs y más.

En área de gráficos, el estudiante titulado de EECS, Leonardo Hernández Cano, tiene sus fanales puestos en el diseño digital, específicamente en la engendramiento de texturas visuales para aplicaciones CAD y el objetivo de descubrir formas eficientes de habilitar capacidades en VLM. En equipo con los grupos de laboratorio dirigidos por Armando Solar-Lezama, profesor de EECS y Profesor Distinguido de Computación en la Colegio de Computación Schwarzman del MIT, y Nathan Fulton de IBM Research, Hernández Cano creó un sistema de síntesis de programas que aprende a refinar el código por sí solo. El sistema comienza con una descripción de textura proporcionada por un legatario en forma de imagen. Luego genera un software Python auténtico, que produce texturas visuales, y refina iterativamente el código con el objetivo de encontrar un software que produzca una textura que coincida con la descripción objetivo, aprendiendo a inquirir nuevos programas a partir de los datos que produce el propio sistema. A través de estos refinamientos, el novedoso software puede crear visualizaciones con la fosforescencia, color, iridiscencia, etc. deseados, imitando materiales reales.

Cuando se ven en conjunto, estos proyectos, y las personas detrás de ellos, están dando un impulso cohesivo con destino a una inteligencia químico más robusta y actos. Al encarar los desafíos centrales de la confiabilidad, la eficiencia y el razonamiento multimodal, el trabajo allana el camino para sistemas de IA que no solo son más poderosos, sino además más confiables y rentables, para aplicaciones científicas y empresariales del mundo vivo.