Modelos de IA de trenes y implementación a escalera de billones de parámetros con el soporte de HyperPod de Amazon Sagemaker para ultraservadores P6E-GB200

Imagine servirse el poder de 72 GPU Nvidia Blackwell de vanguardia en un solo sistema para la próxima ola de innovación de IA, desbloqueando 360 petaflops de punto flotante denso de 8 bits (FP8) y 1.4 exafultos de punto de flotación de 4 bits de 4 bits (FP4). Hoy, eso es exactamente lo que Amazon […]

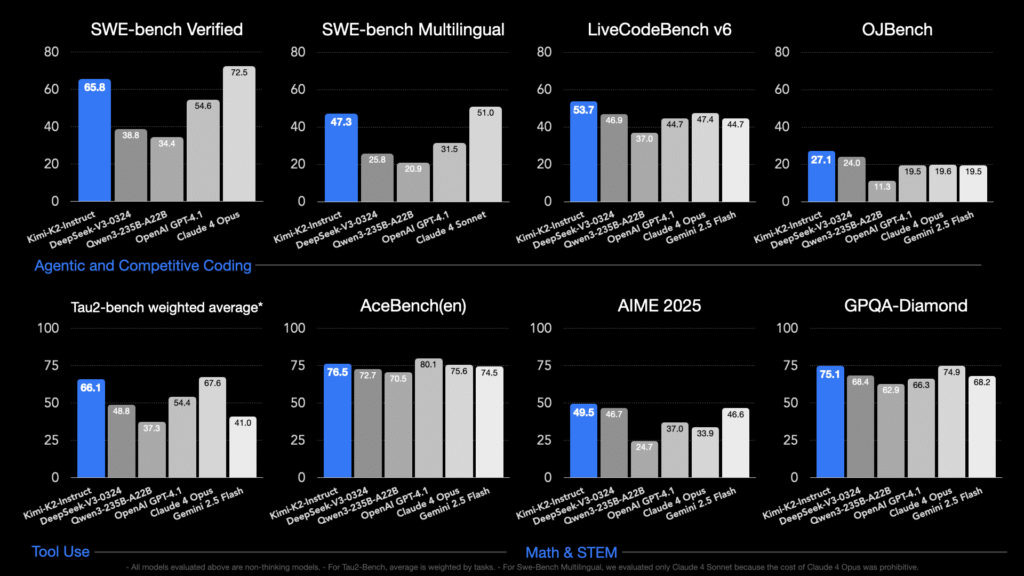

Moonshot AI libera Kimi K2: Un maniquí MOE de billones de parámetros centrado en el contexto amplio, el código, el razonamiento y el comportamiento de la agente

Kimi K2osado por Moonshot Ai en julio de 2025, es un código amplio especialmente diseñado Mezcla de expertos (MOE) Maniquí: 1 billón de parámetros totales, con 32 mil millones de parámetros activos por token. Está entrenado usando la personalización Muijar optimizador en 15.5 billones de tokens, logrando un entrenamiento estable a esta escalera sin precedentes […]