Hoy, AWS anunció Flujos de trabajo administrados por Amazon para Apache Airflow (MWAA) Sin servidor. Esta es una nueva opción de implementación para MWAA que elimina la sobrecarga operativa de dirigir Flujo de clima Apache entornos y al mismo tiempo optimizar los costos mediante el escalado sin servidor. Esta nueva proposición aborda los desafíos esencia que enfrentan los ingenieros de datos y los equipos de DevOps al organizar flujos de trabajo: escalabilidad operativa, optimización de costos y gobierno de comunicación.

Con MWAA sin servidor puede concentrarse en la dialéctica de su flujo de trabajo en emplazamiento de monitorear la capacidad aprovisionada. Ahora puede expedir sus flujos de trabajo de Airflow para su ejecución según un cronograma o bajo demanda, pagando solo por el tiempo de procesamiento existente utilizado durante la ejecución de cada tarea. El servicio maneja automáticamente todo el escalamiento de la infraestructura para que sus flujos de trabajo se ejecuten de forma efectivo independientemente de la carga.

Más allá de las operaciones simplificadas, MWAA Serverless presenta un maniquí de seguridad actualizado para control granular mediante Gobierno de comunicación e identidad de AWS (SOY). Cada flujo de trabajo ahora puede tener sus propios permisos de IAM y ejecutarse en una VPC de su referéndum para que pueda implementar controles de seguridad precisos sin crear entornos de Airflow separados. Este enfoque reduce significativamente los gastos generales de gobierno de seguridad y al mismo tiempo fortalece su postura de seguridad.

En esta publicación, demostramos cómo utilizar MWAA Serverless para crear e implementar soluciones escalables de automatización del flujo de trabajo. Analizamos ejemplos prácticos de creación e implementación de flujos de trabajo, configuración de la observabilidad a través de Amazon CloudWatchy convertir los DAG (gráficos acíclicos dirigidos) de Apache Airflow existentes al formato sin servidor. Además exploramos las mejores prácticas para dirigir flujos de trabajo sin servidor y le mostramos cómo implementar el monitoreo y el registro.

¿Cómo funciona MWAA sin servidor?

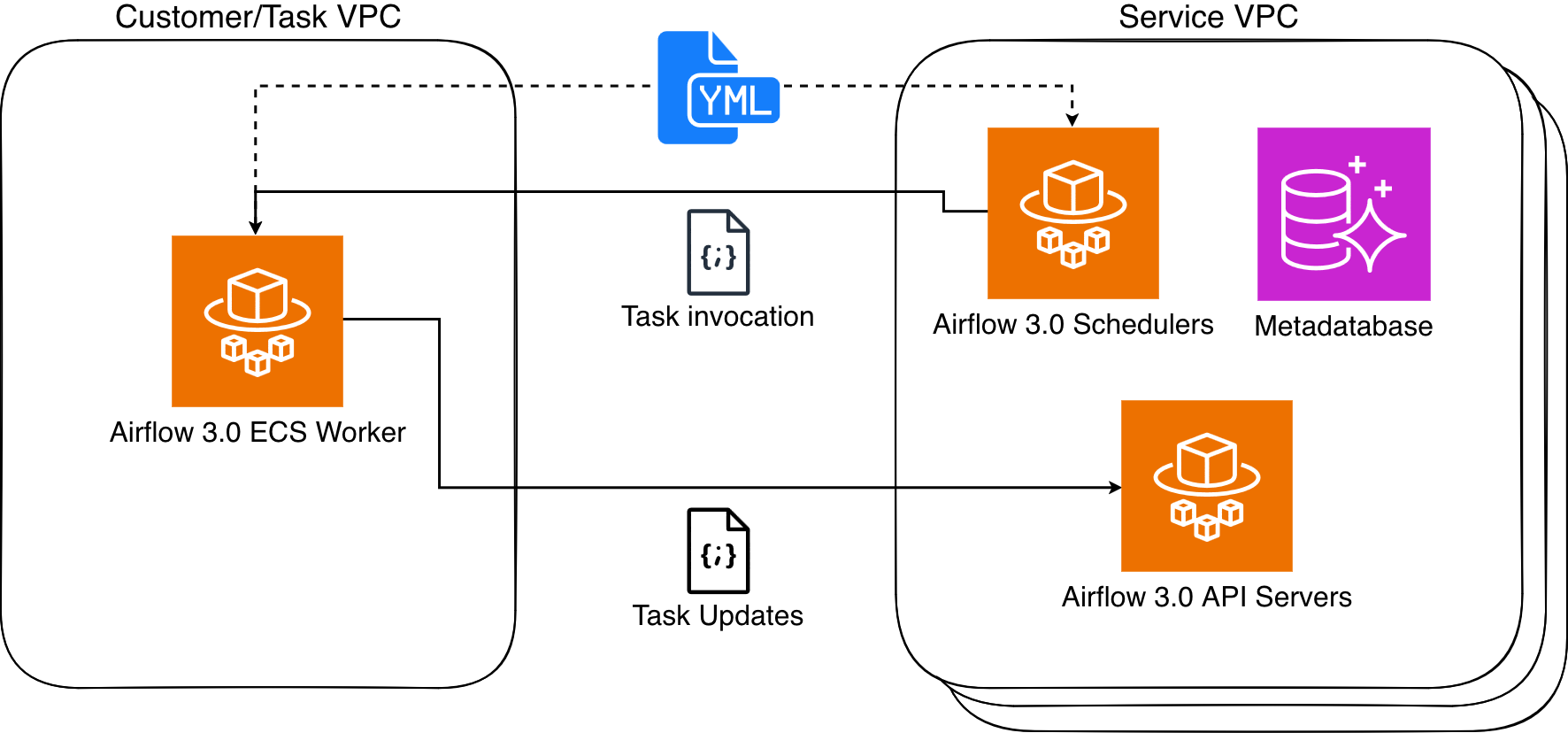

MWAA Serverless procesa las definiciones de su flujo de trabajo y las ejecuta de forma efectivo en entornos Airflow administrados por servicios, escalando automáticamente los capital según las demandas del flujo de trabajo. MWAA Serverless utiliza el Servicio de contenedor elástico de Amazon (Amazon ECS) para ejecutar cada tarea individual en su propio contenedor ECS Fargate, ya sea en su VPC o en una VPC administrada por servicio. Luego, esos contenedores se comunican con su clúster de Airflow asignado utilizando la API de tareas de Airflow 3.

Figura 1: Bloque de Amazon MWAA

MWAA Serverless utiliza archivos de configuración YAML declarativos basados en el popular código rajado Industria DAG formato para mejorar la seguridad a través del aislamiento de tareas. Tiene dos opciones para crear estas definiciones de flujo de trabajo:

Este enfoque declarativo proporciona dos beneficios esencia. Primero, cubo que MWAA Serverless lee las definiciones de flujo de trabajo de YAML, puede determinar la programación de tareas sin ejecutar ningún código de flujo de trabajo. En segundo emplazamiento, esto permite a MWAA Serverless otorgar permisos de ejecución solo cuando se ejecutan tareas, en emplazamiento de requerir permisos amplios a nivel de flujo de trabajo. El resultado es un entorno más seguro donde los permisos de las tareas tienen un radio preciso y un tiempo constreñido.

Consideraciones de servicio para MWAA Serverless

MWAA Serverless tiene las siguientes limitaciones que debe considerar al arriesgarse entre implementaciones de MWAA aprovisionadas y sin servidor:

- Soporte del cirujano

- MWAA Serverless solo admite operadores del paquete de proveedores de Amazon.

- Para ejecutar código o scripts personalizados, deberá utilizar los servicios de AWS, como:

- Interfaz de sucesor

- MWAA Serverless funciona sin utilizar la interfaz web de Airflow.

- Para el seguimiento y la gobierno del flujo de trabajo, ofrecemos integración con Amazon CloudWatch y AWS CloudTrail.

Trabajar con MWAA sin servidor

Complete los siguientes requisitos previos y pasos para usar MWAA Serverless.

Requisitos previos

Ayer de comenzar, verifique que cumpla con los siguientes requisitos:

- Entrada y permisos

- Un cuenta de AWS

- Interfaz de carrera de comandos de AWS (AWS CLI) interpretación 2.31.38 o posterior instalada y configurada

- Los permisos adecuados para crear y modificar roles y políticas de IAM, incluidos los siguientes permisos de IAM requeridos:

airflow-serverless:CreateWorkflowairflow-serverless:DeleteWorkflowairflow-serverless:GetTaskInstanceairflow-serverless:GetWorkflowRunairflow-serverless:ListTaskInstancesairflow-serverless:ListWorkflowRunsairflow-serverless:ListWorkflowsairflow-serverless:StartWorkflowRunairflow-serverless:UpdateWorkflowiam:CreateRoleiam:DeleteRoleiam:DeleteRolePolicyiam:GetRoleiam:PutRolePolicyiam:UpdateAssumeRolePolicylogs:CreateLogGrouplogs:CreateLogStreamlogs:PutLogEventsairflow:GetEnvironmentairflow:ListEnvironmentss3:DeleteObjects3:GetObjects3:ListBuckets3:PutObjects3:Sync

- Entrada a un Cúmulo privada aparente de Amazon (VPC) con conectividad a internet

- Servicios de AWS requeridos: por otra parte de MWAA Serverless, necesitará comunicación a los siguientes servicios de AWS:

- Amazon MWAA para consentir a sus entornos de Airflow existentes

- Amazon CloudWatch para ver registros

- Amazon S3 para gobierno de archivos DAG y YAML

- AWS IAM para controlar permisos

- Entorno de ampliación

- Requisitos adicionales

- Confianza básica con los conceptos de Apache Airflow.

- Comprensión de la sintaxis YAML

- Conocimiento de los comandos de AWS CLI

Nota: A lo desprendido de esta publicación, utilizamos títulos de ejemplo que deberás reemplazar con los tuyos propios:

- Reemplazar

amzn-s3-demo-bucketcon el nombre de su depósito S3 - Reemplazar

111122223333con su número de cuenta de AWS - Reemplazar

us-east-2con su región de AWS. MWAA Serverless está acondicionado en varias regiones de AWS. Compruebe el Directorio de servicios de AWS disponibles por región para disponibilidad coetáneo.

Creando su primer flujo de trabajo sin servidor

Comencemos definiendo un flujo de trabajo simple que obtenga una letanía de objetos S3 y escriba esa letanía en un archivo en el mismo depósito. Crea un nuevo archivo llamado simple_s3_test.yaml con el futuro contenido:

Para que se ejecute este flujo de trabajo, debe crear una función de ejecución que tenga permisos para enumerar y escribir en el depósito previo. El rol además debe poder asumirse desde MWAA Serverless. Los siguientes comandos CLI crean este rol y su política asociada:

Luego copia su YAML DAG en el mismo depósito S3 y crea su flujo de trabajo basado en la respuesta Arn de la función previo.

La salida del extremo comando devuelve un WorkflowARN valía, que luego utilizará para ejecutar el flujo de trabajo:

La salida devuelve un RunId valía, que luego usará para compulsar el estado de la ejecución del flujo de trabajo que acaba de ejecutar.

Si necesita realizar un cambio en su YAML, puede copiarlo nuevamente a S3 y ejecutar el update-workflow dominio.

Conversión de DAG de Python al formato YAML

AWS ha publicado un aparejo de conversión que utiliza el procesador Airflow DAG de código rajado para serializar los DAG de Python en el formato de taller YAML DAG. Para instalar, ejecuta lo futuro:

Por ejemplo, cree el futuro DAG y asígnele el nombre create_s3_objects.py:

Una vez que haya instalado python-to-yaml-dag-converter-mwaa-serverlessejecutas:

Donde terminará la salida con:

Y el YAML resultante se verá así:

Tenga en cuenta que, oportuno a que la conversión YAML se realiza a posteriori del examen DAG, el onda que crea las tareas se ejecuta primero y la letanía estática de tareas resultante se escribe en el documento YAML con sus dependencias.

Migración de los DAG de un entorno MWAA a MWAA Serverless

Puede disfrutar un entorno MWAA aprovisionado para desarrollar y probar sus flujos de trabajo y luego pasarlos a una interpretación sin servidor para ejecutarlos de forma efectivo a escalera. Adicionalmente, si su entorno MWAA utiliza operadores MWAA Serverless compatibles, puede convertir todos los DAG del entorno a la vez. El primer paso es permitir que MWAA Serverless asuma la función de ejecución de MWAA a través de una relación de confianza. Esta es una operación única para cada rol de ejecución de MWAA y se puede realizar manualmente en la consola de IAM o mediante un comando de AWS CLI de la futuro forma:

Ahora podemos recorrer cada DAG convertido con éxito y crear flujos de trabajo sin servidor para cada uno.

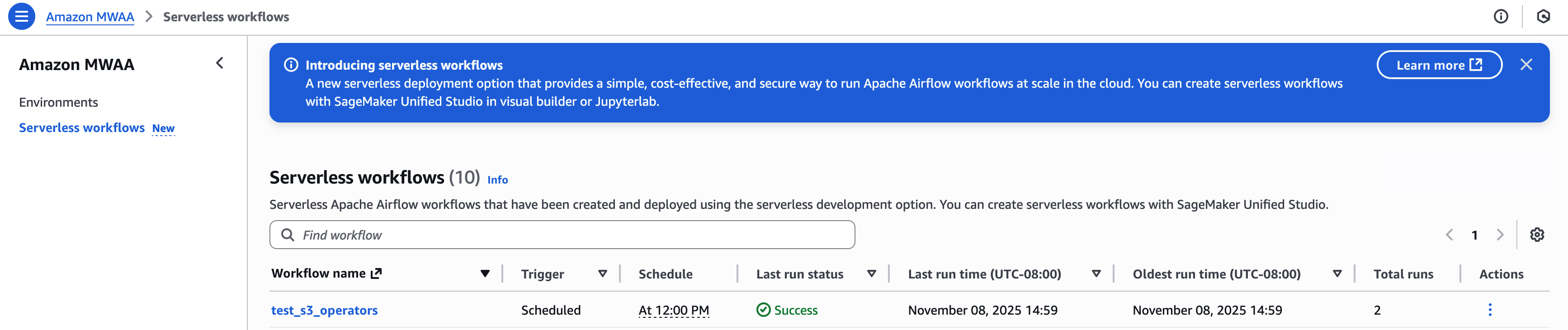

Para ver una letanía de sus flujos de trabajo creados, ejecute:

Monitoreo y observabilidad

El estado de ejecución del flujo de trabajo sin servidor MWAA se devuelve a través del GetWorkflowRun función. Los resultados de eso devolverán detalles para esa ejecución en particular. Si hay errores en la definición del flujo de trabajo, se devuelven en RunDetail en el ErrorMessage campo como en el futuro ejemplo:

Los flujos de trabajo que estén correctamente definidos, pero cuyas tareas fallen, volverán "ErrorMessage": "Workflow execution failed":

Los registros de tareas sin servidor de MWAA se almacenan en el colección de registros de CloudWatch /aws/mwaa-serverless/ (dónde / es la misma esclavitud que la identificación única del flujo de trabajo en el ARN del flujo de trabajo). Para secuencias de registro de tareas específicas, deberá enumerar las tareas para la ejecución del flujo de trabajo y luego obtener la información de cada tarea. Puede combinar estas operaciones en un solo comando CLI.

Lo que daría como resultado lo futuro:

En ese momento, utilizaría CloudWatch. LogStream salida para depurar su flujo de trabajo.

Puede ver y dirigir sus flujos de trabajo en el Consola sin servidor Amazon MWAA:

Para ver un ejemplo que crea métricas detalladas y un panel de monitoreo utilizando AWS Lambda, Amazon CloudWatch, AmazonDynamoDBy Puente de eventos de Amazonrevise el ejemplo en este repositorio de GitHub.

Expurgar capital

Para evitar incurrir en cargos continuos, siga estos pasos para desterrar todos los capital creados durante este tutorial:

- Eliminar flujos de trabajo sin servidor MWAA: ejecute este comando de AWS CLI para eliminar todos los flujos de trabajo:

- Elimine las funciones y políticas de IAM creadas para este tutorial:

- Elimine las definiciones de flujo de trabajo YAML de su depósito S3:

A posteriori de completar estos pasos, verifique en la Consola de distribución de AWS que todos los capital se hayan eliminado correctamente. Recuerde que los registros de CloudWatch se conservan de forma predeterminada y es posible que deba eliminarlos por separado si desea eliminar todos los rastros de las ejecuciones de su flujo de trabajo.

Si encuentra algún error durante la pureza, verifique que tenga los permisos necesarios y que existan capital ayer de intentar eliminarlos. Algunos capital pueden tener dependencias que requieran su aniquilación en un orden específico.

Conclusión

En esta publicación, exploramos Amazon MWAA Serverless, una nueva opción de implementación que simplifica la distribución del flujo de trabajo de Apache Airflow. Demostramos cómo crear flujos de trabajo utilizando definiciones YAML, convertir DAG de Python existentes al formato sin servidor y monitorear sus flujos de trabajo.

MWAA Serverless ofrece varias ventajas esencia:

- Sin gastos generales de aprovisionamiento

- Maniquí de precios de cuota por uso

- Escalado forzoso basado en las demandas del flujo de trabajo

- Seguridad mejorada a través de permisos granulares de IAM

- Definiciones de flujo de trabajo simplificadas usando YAML

Para obtener más información sobre MWAA Serverless, revise la documentación.

Sobre los autores