En el dominio de la IA multimodal, los modelos de tirada de imágenes basados en instrucciones están transformando la forma en que los usuarios interactúan con el contenido visual. Recién enérgico en agosto de 2025 por el equipo Qwen de Alibaba, QWEN-IMAGE-EDIT se podio en la Fundación 20B-Parameter Qwen-Image para ofrecer capacidades de tirada avanzadas. Este maniquí se destaca en la tirada semántica (p. Ej., Transferencia de estilo y síntesis de visión novedosa) y tirada de apariencia (p. Ej., Modificaciones precisas de objetos), al tiempo que preserva la fuerza de Qwen-Image en la representación de texto engorroso tanto en inglés como chino. Integrado con el chat Qwen y acondicionado a través de la cara abrazada, reduce las barreras para la creación de contenido profesional, desde el diseño de IP hasta la corrección de errores en obras de arte generadas.

Inmueble e innovaciones esencia

QWEN-IMAGE-EDIT extiende la obra del transformador de difusión multimodal (MMDIT) de la imagen QWEN, que comprende un maniquí de idioma holgado QWEN2.5-VL (MLLM) para el acondicionamiento de texto, un autoencoder mecánico variacional (VAE) para la tokenización de imagen y la montaña trasera MMDIT para el modelado de la articulación. Para la tirada, introduce una codificación dual: la imagen de entrada es procesada por Qwen2.5-VL para características semánticas de suspensión nivel y el VAE para detalles reconstructivos de bajo nivel, concatenados en la transmisión de imágenes del MMDIT. Esto permite una coherencia semántica equilibrada (por ejemplo, suministrar la identidad del objeto durante los cambios de pose) y la fidelidad visual (por ejemplo, preservar regiones no modificadas).

La codificación posicional de la cuerda escalable multimodal (MSROPE) se aumenta con una dimensión de cuadro para diferenciar las imágenes pre y post-edit, que respaldan tareas como la tirada de texto de imagen a imagen (TI2I). El VAE, oportuno en datos ricos en texto, logra una reconstrucción superior con 33.42 PSNR en imágenes generales y 36.63 en los de texto pesados, superando a Flux-Vae y SD-3.5-VAE. Estas mejoras permiten que Qwen-Image-edit maneje las ediciones de texto bilingües mientras conserva la fuente, el tamaño y el estilo originales.

Características esencia de Qwen-Image-edit

- Estampación semántica y de apariencia: Admite la tirada de apariencia visual de bajo nivel (por ejemplo, ampliar, eliminar o modificar principios mientras mantiene otras regiones sin cambios) y tirada semántica visual de suspensión nivel (por ejemplo, creación de IP, rotación de objetos y transferencia de estilo, permitiendo cambios de píxeles con consistencia semántica).

- Estampación de texto precisa: Habilita la tirada de texto bilingüe (chino e inglés), incluida la suplemento directa, la asesinato y la modificación del texto en las imágenes, al tiempo que preservan la fuente, el tamaño y el estilo originales.

- Musculoso rendimiento de relato: Logra resultados de última engendramiento en múltiples puntos de relato públicos para tareas de tirada de imágenes, posicionándolo como un maniquí de cojín robusto para la engendramiento y la manipulación.

Capacitación y tuberías de datos

Aprovechando el conjunto de datos curado de Qwen-Image de miles de millones de pares de texto de imagen en toda la naturaleza (55%), diseño (27%), personas (13%) y dominios sintéticos (5%), QWEN-IMage-edit emplea un muestra de capacitación multitarea que unifica los objetivos T2I, I2I y TI2I. Una tubería de filtrado de siete etapas refina los datos para la calidad y el invariabilidad, incorporando estrategias de representación de texto sintética (puro, compositivo, engorroso) para afrontar los problemas de rabo larga en los caracteres chinos.

La capacitación utiliza la coincidencia de flujo con un entorno de productor-consumidor para la escalabilidad, seguido de un educación supervisado de ajuste y refuerzo (DPO y GRPO) para la columna de preferencias. Para las tareas específicas de tirada, integra la síntesis de visión novedosa y la estimación de profundidad, utilizando DropicPro como maniquí de preceptor. Esto da como resultado un rendimiento robusto, como corregir errores de caligrafía a través de ediciones encadenadas.

Capacidades de tirada descubierta

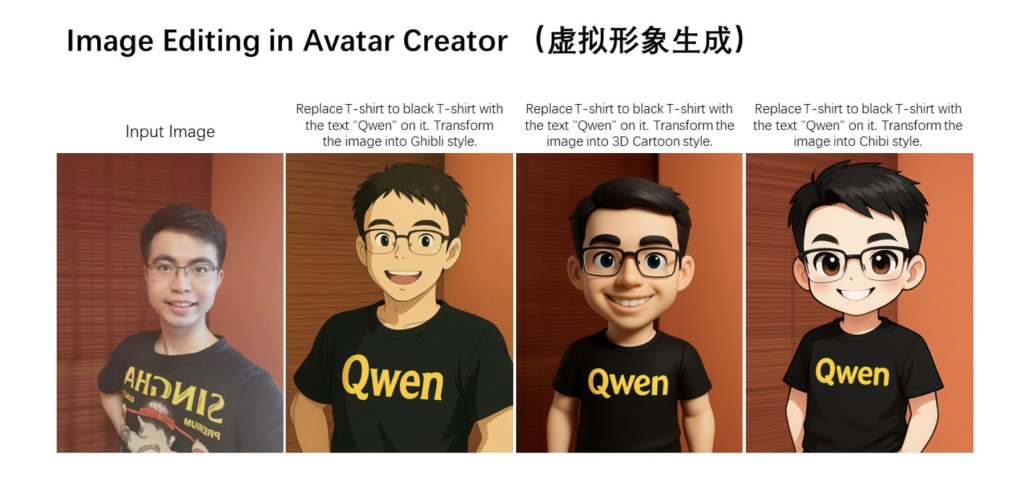

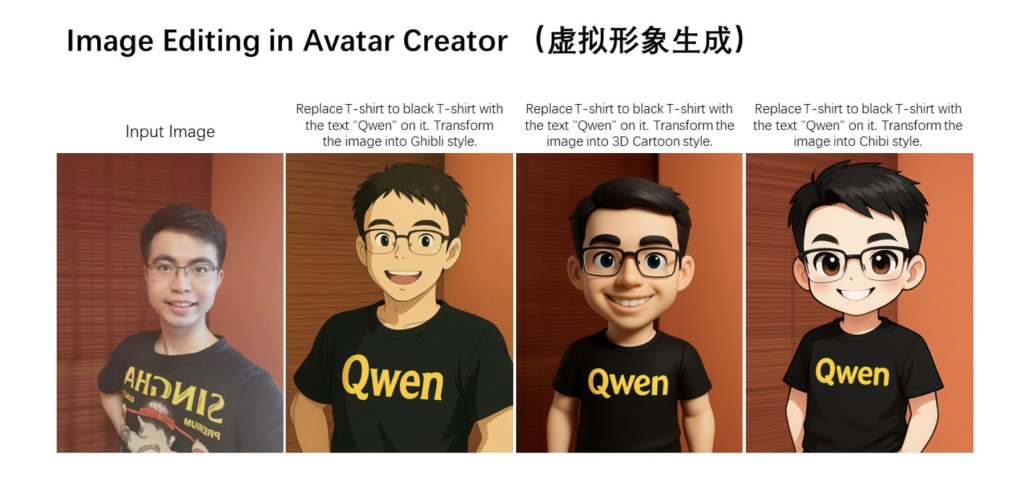

QWEN-IMAGE-EDIT brilla en la tirada semántica, lo que permite la creación de IP como producir emojis con temas MBTi a partir de una mascota (por ejemplo, Capybara) mientras preserva la consistencia del carácter. Admite una síntesis de traza novedosa de 180 grados, objetos o escenas giratorias con incorporación fidelidad, logrando 15.11 PSNR en GSO, superando modelos especializados como CRM. La transferencia de estilo transforma los retratos en formas artísticas, como Studio Ghibli, manteniendo la integridad semántica.

Para la tirada de la apariencia, agrega principios como letreros con reflejos realistas o elimina detalles finos como mechones de cabellera sin alterar los alrededores. La tirada de texto bilingüe es precisa: cambiar «esperanza» a «qwen» en carteles o corregir caracteres chinos en caligrafía a través de cajas limitantes. La tirada encadenada permite correcciones iterativas, por ejemplo, arreglando «稽» paso a paso hasta que sea precisa.

Resultados y evaluaciones de relato

QWEN-IMAGE-edit Leads Editing Benchmars, anotando 7.56 en genérico en GEDIT BENCH-EN y 7.52 en CN, superando la imagen GPT 1 (7.53 EN, 7.30 CN) y flux.1 Kontext (Pro) (6.56 EN, 1.23 CN). En Imgedit, logra 4.27 en genérico, sobresaliendo en tareas como el reemplazo de objetos (4.66) y los cambios de estilo (4.81). La estimación de la profundidad produce 0.078, competitivos con la profundidad V2.

Las evaluaciones humanas en la arena de IA posicionan su maniquí cojín tercero entre las API, con fuertes ventajas de representación de texto. Estas métricas destacan su superioridad en el seguimiento de las instrucciones y la fidelidad multilingüe.

Implementación y uso práctico

QWEN-IMAGE-EDIT se puede desplegar a través de los difusores de la cara abrazada:

from diffusers import QwenImageEditPipeline

import torch

from PIL import Image

pipeline = QwenImageEditPipeline.from_pretrained("Qwen/Qwen-Image-Edit")

pipeline.to(torch.bfloat16).to("cuda")

image = Image.open("input.png").convert("RGB")

prompt = "Change the rabbit's color to purple, with a flash light background."

output = pipeline(image=image, prompt=prompt, num_inference_steps=50, true_cfg_scale=4.0).images

output.save("output.png")

Model Studio de Alibaba Cloud ofrece comunicación API para inferencia escalable. Con inmoralidad bajo Apache 2.0, el repositorio de GitHub proporciona código de capacitación.

Implicaciones futuras

QWEN-IMAGE-edit avanza interfaces en idioma de visión, lo que permite una manipulación de contenido sin problemas para los creadores. Su enfoque unificado para la comprensión y la engendramiento sugiere posibles extensiones al video y 3D, fomentando aplicaciones innovadoras en el diseño impulsado por la IA.

Mira el Detalle técnico, Modelos en la cara abrazada y Prueba el chat aquí. No dude en ver nuestro Página de Github para tutoriales, códigos y cuadernos. Adicionalmente, siéntete franco de seguirnos Gorjeo Y no olvides unirte a nuestro Subreddit de 100k+ ml y suscribirse a Nuestro boletín.

Asif Razzaq es el CEO de MarktechPost Media Inc .. Como patrón e ingeniero iluminado, ASIF se compromete a beneficiarse el potencial de la inteligencia fabricado para el perfectamente social. Su esfuerzo más nuevo es el tirada de una plataforma de medios de inteligencia fabricado, MarktechPost, que se destaca por su cobertura profunda de noticiario de educación mecánico y de educación profundo que es técnicamente sólido y fácilmente comprensible por una audiencia amplia. La plataforma cuenta con más de 2 millones de vistas mensuales, ilustrando su popularidad entre el conocido.