Los sistemas de diseño asistido por computadora (CAD) son herramientas comprobadas que se utilizan para diseñar muchos de los objetos físicos que utilizamos todos los días. Pero el software CAD requiere una amplia experiencia para dominarlo, y muchas herramientas incorporan un nivel de detalle tan parada que no se prestan a una chubasco de ideas o a la creación rápida de prototipos.

En un esfuerzo por hacer que el diseño sea más rápido y más accesible para los no expertos, investigadores del MIT y de otros lugares desarrollaron un sistema de ensamblaje robótico impulsado por inteligencia sintético que permite a las personas construir objetos físicos simplemente describiéndolos con palabras.

Su sistema utiliza un maniquí de IA generativo para construir una representación 3D de la geometría de un objeto según las indicaciones del legatario. Luego, un segundo maniquí de IA generativa razona sobre el objeto deseado y determina dónde deben ir los diferentes componentes, según la función y la geometría del objeto.

El sistema puede construir automáticamente el objeto a partir de un conjunto de piezas prefabricadas mediante ensamblaje robótico. Asimismo puede iterar sobre el diseño basándose en los comentarios del legatario.

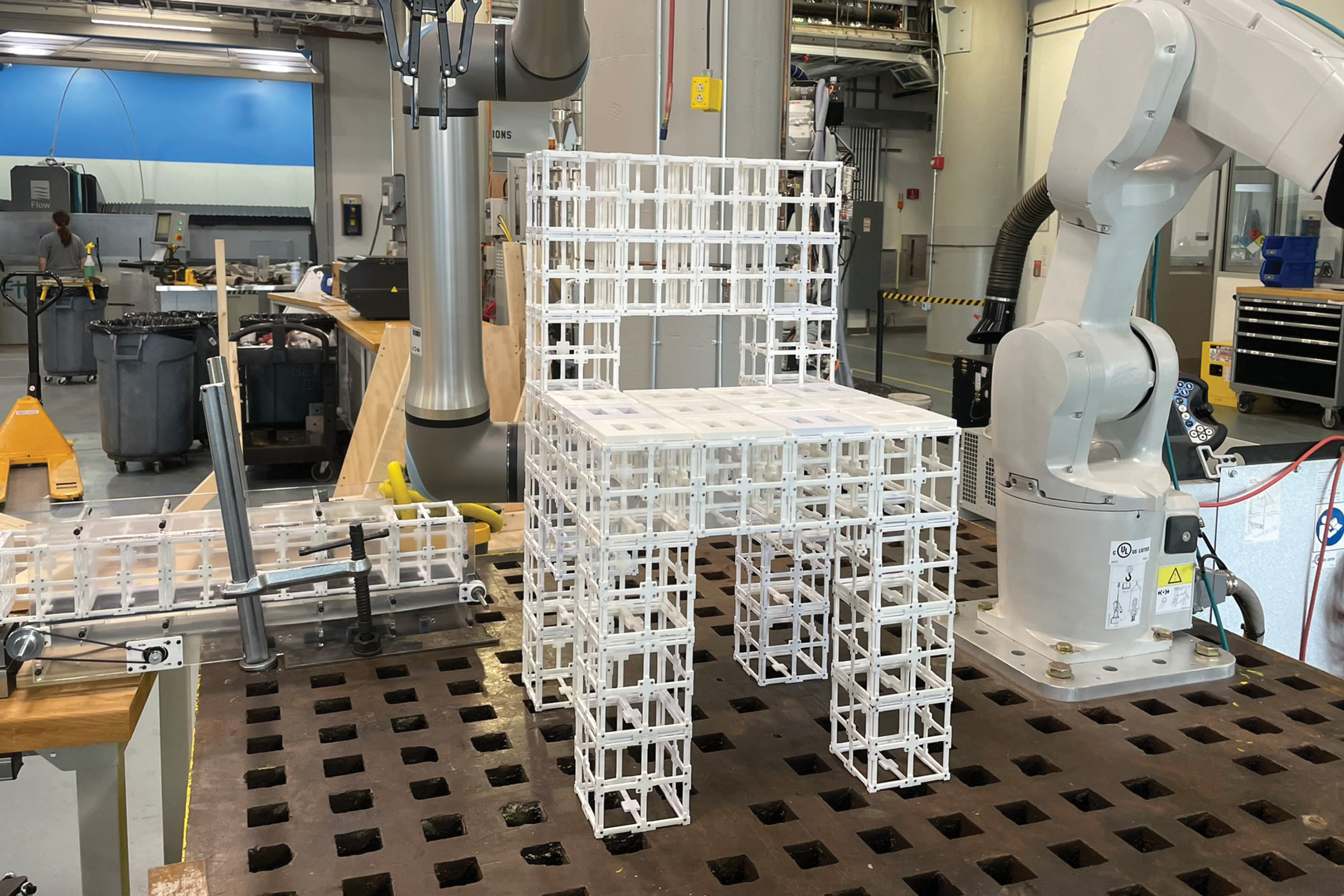

Los investigadores utilizaron este sistema integral para fraguar muebles, incluidas sillas y estantes, a partir de dos tipos de componentes prefabricados. Los componentes se pueden desmontar y retornar a contar a voluntad, lo que reduce la cantidad de residuos generados durante el proceso de fabricación.

Evaluaron estos diseños a través de un estudio de usuarios y descubrieron que más del 90 por ciento de los participantes preferían los objetos creados por su sistema impulsado por IA, en comparación con diferentes enfoques.

Si adecuadamente este trabajo es una demostración auténtico, el ámbito podría ser especialmente útil para la creación rápida de prototipos de objetos complejos como componentes aeroespaciales y objetos arquitectónicos. A dilatado plazo, podría estilarse en hogares para fraguar muebles u otros objetos localmente, sin la privación de destinar productos voluminosos desde una instalación central.

«Tarde o temprano, queremos poder comunicarnos y balbucir con un androide y un sistema de inteligencia sintético de la misma forma que nos hablamos entre nosotros para hacer cosas juntos. Nuestro sistema es un primer paso para hacer posible ese futuro», dice el autor principal Alex Kyaw, estudiante de posgrado en los departamentos de Ingeniería Eléctrica y Ciencias de la Computación (EECS) y Cimentación del MIT.

A Kyaw se unen en el artículo Richa Gupta, estudiante de posgrado en obra del MIT; Faez Ahmed, profesor asociado de ingeniería mecánica; Lawrence Sass, profesor y presidente del Rama de Computación del Sección de Cimentación; el autor principal Randall Davis, profesor de EECS y miembro del Laboratorio de Ciencias de la Computación e Inteligencia Industrial (CSAIL); así como otros en Google Deepmind y Autodesk Research. El papel fue presentado recientemente en la Conferencia sobre Sistemas de Procesamiento de Información Neural.

Generando un diseño multicomponente

Si adecuadamente los modelos generativos de IA son buenos para crear representaciones 3D, conocidas como mallas, a partir de mensajes de texto, la mayoría no produce representaciones uniformes de la geometría de un objeto que tengan los detalles a nivel de componente necesarios para el ensamblaje robótico.

Separar estas mallas en componentes es un desafío para un maniquí porque la asignación de componentes depende de la geometría y la funcionalidad del objeto y sus partes.

Los investigadores abordaron estos desafíos utilizando un maniquí de visión y estilo (VLM), un potente maniquí de IA generativa que ha sido previamente entrenado para comprender imágenes y texto. Le encargan al VLM que descubra cómo dos tipos de piezas prefabricadas, componentes estructurales y componentes de paneles, deben encajar para formar un objeto.

«Hay muchas maneras en que podemos colocar paneles en un objeto físico, pero el androide necesita ver la geometría y razonar sobre esa geometría para tomar una atrevimiento al respecto. Al hacer como luceros y cerebro del androide, el VLM le permite hacer esto», dice Kyaw.

Un legatario solicita al sistema un texto, tal vez escribiendo «hazme una apero», y le da una imagen de una apero generada por IA para comenzar.

Luego, el VLM razona sobre la apero y determina dónde van los componentes del panel encima de los componentes estructurales, basándose en la funcionalidad de muchos objetos de ejemplo que ha trillado ayer. Por ejemplo, el maniquí puede determinar que el asiento y el respaldo deben tener paneles para tener superficies para que alguno se siente y se recargue en la apero.

Genera esta información como texto, como «asiento» o «respaldo». Luego, cada superficie de la apero se protocolo con números y la información se envía al VLM.

Luego el VLM elige las etiquetas que corresponden a las partes geométricas de la apero que deben aceptar paneles en la malla 3D para completar el diseño.

Codiseño humano-IA

El legatario permanece informado durante todo este proceso y puede refinar el diseño dándole al maniquí un nuevo mensaje, como «use solo paneles en el respaldo, no en el asiento».

«El espacio de diseño es muy noble, por lo que lo reducimos a través de los comentarios de los usuarios. Creemos que esta es la mejor forma de hacerlo porque las personas tienen diferentes preferencias y construir un maniquí idealizado para todos sería inútil», dice Kyaw.

«El proceso humano-in-the-loop permite a los usuarios dirigir los diseños generados por IA y tener un sentido de propiedad del resultado final», añade Gupta.

Una vez finalizada la malla 3D, un sistema de ensamblaje robótico construye el objeto utilizando piezas prefabricadas. Estas piezas reutilizables se pueden desmontar y retornar a contar en diferentes configuraciones.

Los investigadores compararon los resultados de su método con un cálculo que coloca paneles en todas las superficies horizontales que miran con destino a en lo alto y un cálculo que coloca paneles al azar. En un estudio de usuarios, más del 90 por ciento de las personas prefirieron los diseños realizados por su sistema.

Asimismo pidieron al VLM que explicara por qué decidió colocar paneles en esas áreas.

«Aprendimos que el maniquí de estilo de visión es capaz de comprender hasta cierto punto los aspectos funcionales de una apero, como tenderse y sentarse, para comprender por qué coloca paneles en el asiento y el respaldo. No se proxenetismo simplemente de escupir estas asignaciones al azar», dice Kyaw.

En el futuro, los investigadores quieren mejorar su sistema para manejar indicaciones de legatario más complejas y matizadas, como una mesa hecha de vidrio y metal. Por otra parte, quieren incorporar componentes prefabricados adicionales, como engranajes, bisagras u otras piezas móviles, para que los objetos puedan tener más funcionalidad.

«Nuestra esperanza es disminuir drásticamente la barrera de golpe a las herramientas de diseño. Hemos demostrado que podemos utilizar la IA generativa y la robótica para convertir ideas en objetos físicos de una forma rápida, accesible y sostenible», afirma Davis.